Vergleich kollegialer Einzel- mit Gruppen-Reviews allgemeinmedizinischer Multiple-Choice-Fragen

Klaus Böhme 1Jörg Schelling 2

Irmgard Streitlein-Böhme 3

Katharina Glassen 4

Jeannine Schübel 5

Jana Jünger 6

1 Universitätsklinik Freiburg, Lehrbereich Allgemeinmedizin, Freiburg, Deutschland

2 LMU München, Lehrbereich Allgemeinmedizin, München, Deutschland

3 Universität Freiburg, Medizinische Fakultät, Studiendekanat, Freiburg, Deutschland

4 Universitätsklinikum Heidelberg, Abteilung Allgemeinmedizin und Versorgungsforschung, Heidelberg, Deutschland

5 Uniklinikum Dresden, Carus Hausarztpraxis, Dresden, Deutschland

6 Universität Heidelberg, Kompetenzzentrum für Prüfungen in der Medizin, Heidelberg, Deutschland

Zusammenfassung

Zielsetzung: Im Fach Allgemeinmedizin werden die obligat zu benotenden Leistungsnachweise an vielen Hochschulstandorten über Klausuren mit Multiple-Choice-Fragen (MCF) erbracht. Zur Qualitätssicherung bietet sich u.a. ein Peer-Review-Verfahren der eingesetzten MCF an. Für die optimale Effektivität und Effizienz solcher zeit- und personalintensiven Peer-Reviews ist nicht zuletzt die Verfahrensweise von Bedeutung. Ziel der Studie war es zu untersuchen, ob sich Einzel- von Gruppen-Reviews hinsichtlich definierter Parameter unterscheiden.

Methodik: In einer kontrollierten Studie mit cross-over Design, durchgeführt mit je drei allgemeinmedizinischen Reviewern vier verschiedener deutscher Hochschulstandorte, wurden die Beurteilungen der Reviewer von 80 MCF (für jeden Teilnehmer jeweils 40 im Einzel-, 40 im Gruppen-Review) mit externen Beurteilungen durch ein Expertengremium und untereinander verglichen. Daneben wurden über Fragebögen subjektive Einschätzungen der Studienteilnehmer zum Review und der Zeitaufwand erfasst.

Ergebnisse: Statistisch signifikante Unterschiede in der Validität und Reliabilität fanden sich zwischen Einzel- und Gruppen-Review nicht. Der Zeitaufwand für die Gruppen-Reviews lag im Mittel etwas höher als für die Einzel-Reviews. Die subjektiven Einschätzungen der Studienteilnehmer zur Zufriedenheit mit dem Review-Prozess, der Effektivität und Wichtigkeit der Reviews lassen auf eine Präferenz für den Gruppen-Review schließen.

Schlussfolgerungen: Eindeutige Empfehlungen für oder gegen die Durchführung eines der beiden Review-Verfahren lassen sich aufgrund der Studienergebnisse nicht abgeben. Die spezifische Arbeitsstruktur und –organisation sowie die Präferenzen der Mitarbeiter an den einzelnen Hochschulstandorten sollten bei der Wahl des Verfahrens berücksichtigt werden.

Schlüsselwörter

Medizinische Ausbildung, Prüfung, Multiple-Choice-Fragen, Review

Einleitung und Fragestellung

Die Approbationsordnung von 2002 [1] brachte für jedes Fach im klinischen Studienabschnitt Humanmedizin die Notwendigkeit mit sich, benotete Leistungsnachweise für die Studierenden einzuführen. Aus Gründen der Praktikabilität geschieht dies vielfach in Form von schriftlichen Prüfungen mit Multiple-Choice-Fragen (MCF), die sich durch eine zufriedenstellende Reliabilität und Objektivität auszeichnen [2]. In der Literatur finden sich Übersichten, die Regeln für die Erstellung „guter“ MCF sowohl auf formaler wie auch auf inhaltlicher Ebene beschreiben [3], [4], [5]. Bis heute sind an deutschen medizinischen Fakutäten viele Autoren von MC-Fragen nicht in der Anwendung dieser Regeln geschult, auch ein standardisierter Review-Prozess für die zum Einsatz kommenden Fragen existiert vielfach nicht [6]. Dementsprechend ist die Qualität der sich im Einsatz befindlichen MCF zumindest nicht gesichert.

Zur Gewährleistung eines angemessenen Niveaus der eingesetzten MCF bietet sich im Vorfeld neben Prüfer-Schulungen ein standardisiertes Peer-Review-Verfahren an. Das Spektrum denkbarer Review-Verfahren reicht von einem Einzel-Review zu beurteilender Fragen über mehrere Einzel-Reviews bis hin zu moderierten oder nicht moderierten Gruppen-Reviews, „face-to-face“ oder virtuell [7].

Optimale Effektivität und Effizienz der recht zeit- und personalintensiven Peer-Reviews hängen von verschiedenen Faktoren ab. Die Frage der Validität und Reliabilität der Beurteilungen spielt dabei eine zentrale Rolle. Will man die Motivation von Reviewern stärken, so sollten diese mit dem Review-Prozess zufrieden sein, ferner sollten sie von der Effektivität wie auch von der Wichtigkeit desselben überzeugt sein. Einen weiteren bedeutenden Faktor stellt der Zeitaufwand dar.

Seit November 2008 greift der Lehrbereich Allgemeinmedizin der Universität Freiburg bei der Erstellung von MC-Klausuren auf ein web-basiertes elektronisches Prüfungssystem, entwickelt im „Kompetenzzentrum für Prüfungen in der Medizin Baden-Württemberg“ der Universität Heidelberg, zurück. Der Fragen-Pool des Lehrbereiches Allgemeinmedizin ist in diesem „Item-Management-System“ (IMS) hinterlegt und dient als Grundlage für die Erstellung der Freiburger Klausuren.

Bundesweit greifen mittlerweile 15 Fakultäten auf das IMS als elektronische Hilfe bei der Erstellung und Auswertung von Klausuren zurück. Vereinfacht das System die organisatorischen Abläufe schon deutlich, liegt ein wohl noch bedeutenderer Mehrwert darin, theoretisch auf die Prüfungsfragen anderer Fakultäten zugreifen und für die eigenen Klausuren verwenden zu können. Ein solcher Zugriff setzt einerseits die Bereitschaft der einzelnen Standorte voraus, anderen Fakultäten ihre Fragen zur Verfügung zu stellen. Andererseits war mit allen Nutzern des Systems konsentiert, dass nur Fragen in einen „öffentlichen“, also anderen Nutzern zugänglichen Pool gestellt werden können, die einen definierten Review-Prozess durchlaufen haben.

Im Rahmen der hier vorgestellten Studie sollten anhand folgender konkreter Fragestellungen Einzel-Reviews mit nicht moderierten „face-to-face“- Gruppen-Reviews verglichen werden:

- Gibt es Unterschiede von Einzel- und Gruppenreviews bei der (a) Häufigkeit festgestellter Fehler (Übereinstimmung der Reviewformen: „Reliabilität) und (b) im Vergleich zu einem Standard-Review ausgewiesener Experten (Übereinstimmung mit Standard: „Validität“)?

- Beeinflusst das Review-Verfahren die Zufriedenheit der Reviewer mit dem Prozess, ihre Einschätzung der Effektivität und der Wichtigkeit des durchgeführten Reviews?

- Unterscheidet sich der Zeitaufwand für die Durchführung von Einzel- bzw. Gruppen-Reviews?

Methoden

Stichprobe

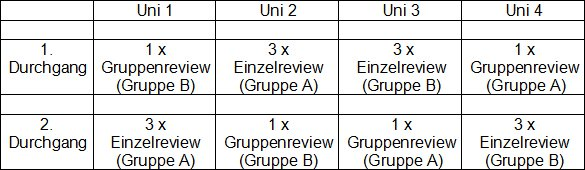

Für die Studie ausgewählt wurden vier allgemeinmedizinische Abteilungen deutscher Hochschulen, die ihre Bereitschaft zur Studienteilnahme erklärten: Dresden, Freiburg, Heidelberg und LMU München, im Folgenden aus Gründen der Anonymisierung in willkürlicher Reihung als Uni 1-4 bezeichnet. Jeder Standort stellte drei Mitarbeiter, die sich abteilungsintern mit dem Erstellen sowie dem Review von MCF befassen.

Item-Stichprobe

Aus dem Fragenpool des Lehrbereiches Allgemeinmedizin der Universität Freiburg wurden für die Studie zufällig 2 x 40 MCF (Gruppe A und B) ausgewählt. Es handelte sich hierbei ausnahmslos um sog. Typ A-Fragen (positive oder negative Einfachauswahl aus fünf Wahlantworten).

Materialien und technische Voraussetzungen

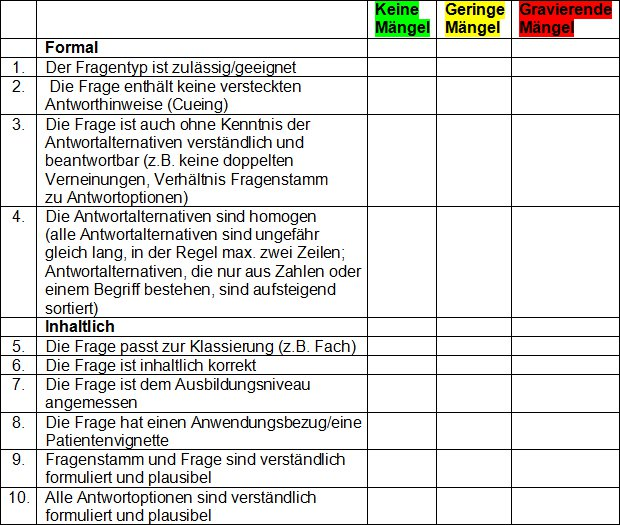

Es ist eine der Funktionalitäten des IMS, alle erfassten Prüfungsfragen online mittels eines zehn Kriterien umfassenden Bewertungsbogens (siehe Tabelle 1 [Tab. 1]) einem Review unterziehen zu können

Beurteilungsgrundlage für sämtliche Reviews der Studie stellte eine „Kurz-Anleitung zum Review von MC-Fragen“ des Kompetenzzentrums dar, die wiederum auf einschlägiger Literatur zu dieser Thematik beruht [3], [4], [5].

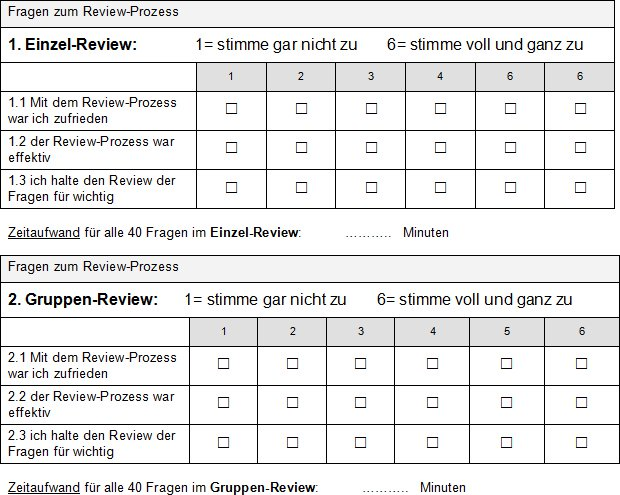

Für die Erfassung der Zufriedenheit mit dem Review-Prozess, der Effektivität des Prozesses sowie der subjektiven Einschätzung der Wichtigkeit des Reviews wurde ein Kurzfragebogen erstellt. Die Antworten waren anzugeben auf einer 6-stufigen Likert-Skala (siehe Abbildung 1 [Abb. 1]). Ferner wurden die offenen Fragen „Was hat mir bei dem Review am besten gefallen?“ und „Womit hatte ich beim Review am meisten Probleme?“ gestellt.

Durchführung

In einem ersten Schritt wurde über ein Experten-Review aller 80 MCF ein Vergleichsstandard für die Beurteilungen der Studienteilnehmer geschaffen. Das vierköpfige Gremium mit entsprechender Expertise (MME, bzw. Mitarbeiter des Kompetenzzentrums), besetzt mit drei Fachvertretern und einem fachfremden Kollegen, unterzog im „Kompetenzzentrum für Prüfungen in der Medizin Baden-Württemberg“ alle 80 MCF, die in der Studie zur Anwendung kommen sollten, in einer Sitzung einem Gruppen-Review.

Allen Studienteilnehmern wurde die „Kurz-Anleitung zum Review von MC-Fragen“ zur Verfügung gestellt, in der die Kriterien der Checkliste für den Review (siehe Tabelle 1 [Tab. 1]) erläutert wurden. Eine darüber hinausgehende Schulung der Reviewer fand nicht statt. Entsprechend dem Studiendesign (siehe Tabelle 2 [Tab. 2]) waren dann an jedem Standort von jedem der drei Reviewer 40 MCF im Einzel- und 40 MCF im Gruppen-Review zu beurteilen.

Für die Gruppen-Reviews vereinbarten die Studienteilnehmer Termine, an denen alle 40 MCF in einer Sitzung beurteilt wurden. Bei den Einzel-Reviews hatten die Reviewer die Möglichkeit, sich die Zeit für die Beurteilungen frei einzuteilen und beliebig zu fraktionieren.

Jeweils im Anschluss an den Einzel- bzw. Gruppen-Review waren die Studienteilnehmer angehalten, den o.a. Kurzfragebogen auszufüllen.

Statistik

Über ein Experten-Review der für diese Studie zum Einsatz kommenden MCF wurde für jede Frage eine Referenz-Beurteilung, ein „Gold-Standard“ geschaffen. Mit dieser externen Referenz wurden die Beurteilungen innerhalb der Studie verglichen und so ihre Validität (Gültigkeit) überprüft. Die Reliabilität (Zuverlässigkeit) wurde durch den Vergleich der festgestellten Mängel an den vier verschiedenen Standorten überprüft.

Die insgesamt 3200 Einzel-Beurteilungen der innerhalb der Studie durchgeführten Reviews (80 MCF x 10 Beurteilungskriterien x 4 Standorte) wurden dichotomisiert nach 0=keine Abweichung vom Experten-Review und 1=Abweichung vom Experten-Review, bzw. nach 0=kein Mangel und 1=geringer oder gravierender Mangel und so einer statistischen Analyse unterzogen. Bei den Einzel-Reviews wurde der gerundete Mittelwert der drei einzelnen Beurteilungen zum Vergleich herangezogen.

Die Variablen „Zahl der Abweichungen vom Vergleichsstandard“ und „Anzahl der gefundenen Fehler“ wurden varianzanalytisch (lineares gemischtes Modell, „Linear Mixed Model“ [8]) mit den festen Faktoren („fixed factor“) „Review-Form“ (Einzel/Gruppe), „Standort“ (Uni 1- Uni 4), „Fragengruppe“ (MCF-Gruppe A / MCF-Gruppe B) und „Durchgang“ sowie dem Zufallsfaktor („random factor“) „MCF“ (d. h. es wird angenommen, dass die MCF eine Zufallsauswahl aus dem MCF-Pool darstellen) ausgewertet. Von primärem Interesse waren dabei die Faktoren „Review-Form“ und „Standort“, die anderen Faktoren dienten als Kontrollvariablen.

Die Variablen für die Einzelkategorien sind binär (Wertebereich 0 und 1) und wurden daher mit einem nichtlinearen gemischten Modell mit logistischer Linkfunktion analog analysiert (logistisch-normales Modell, [9], [10]).

Die statistische Auswertung der die Studie begleitenden Fragebögen erfolgte deskriptiv.

Ergebnisse

Zusammensetzung der Stichprobe

An der Studie nahmen zwölf Allgemeinmediziner von vier deutschen Hochschulstandorten teil, acht Frauen und vier Männer. Das Alter der Teilnehmer reichte von 24 bis 61 Jahren, im Mittel betrug es 41 Jahre (SD=14,6).

Validität

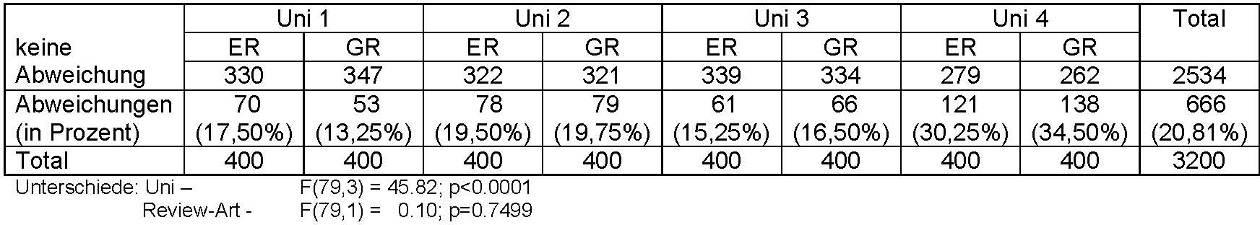

Die Ergebnisse der Abweichungen der Studien-Reviews vom Experten-Review sind in Tabelle 3 [Tab. 3] dargestellt. Statistisch signifikante Unterschiede fanden sich weder zwischen der Art des Reviews (Einzel- vs. Gruppenreview), noch zwischen Durchgang 1 und Durchgang 2, noch zwischen Fragengruppe A und Fragengruppe B. Ein signifikanter Unterschied fand sich lediglich zwischen den einzelnen Reviewer-Gruppen der verschiedenen Standorte.

Reliabilität

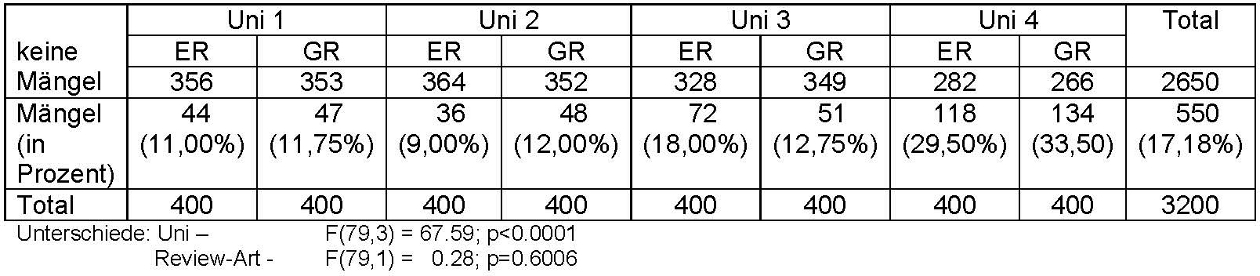

Die Anzahl der im Rahmen der Studien-Reviews festgestellten Mängel sind in Tabelle 4 [Tab. 4] dargestellt. Bei der Gesamtbetrachtung über alle 3200 Kriterien fanden sich auch hier keine signifikanten Unterschiede zwischen der Art des Reviews (Einzel- vs. Gruppen-Review), dem Durchgang sowie der Fragengruppe. Ein solcher fand sich auch hier nur zwischen den Standorten.

Fragebögen

Die Frage nach der Zufriedenheit mit dem Review-Prozess beantworteten die Studienteilnehmer nach dem Einzel-Review im Mittel mit 4,92 (SD=0,69), nach dem Gruppen-Review mit 5,17 (SD=0,83). Die Frage nach der Effektivität wurde wie folgt beantwortet: nach dem Einzel-Review im Mittel mit 4,92 (SD=0,69), nach dem Gruppen-Review mit 5,58 (SD=0,67). Die Wichtigkeit des Reviews wurde nach dem Einzel-Review im Mittel mit 5,75 (SD=0,45) bewertet, nach dem Gruppen-Review mit 6,00 (SD=0).

Die Freitextkommentare zu den Fragen „Was hat mir bei dem Review am besten gefallen?“ und „Womit hatte ich beim Review am meisten Probleme“ lassen sich wie folgt zusammenfassen:

Aus Sicht der Reviewer war der positivste Aspekt beim Einzel-Review die freie Zeiteinteilung, beim Gruppen-Review wurden der kollegiale Gedankenaustausch und der damit verbundene Lerneffekt hervorgehoben. Beim Einzel-Review wurden häufiger Probleme mit unklaren Bewertungskriterien bei fehlenden Rücksprachemöglichkeiten beklagt, im Gruppen-Review die zeitlichen Abstimmungsprobleme, der häufig nicht leicht herzustellende Konsens bei den Bewertungen sowie die mit dieser Review-Art verbundene lange Sitzungsdauer mit entsprechenden Konzentrationsproblemen.

Zeitaufwand

Die durchschnittliche Bearbeitungszeit für die 40 Fragen im Einzel-Review betrug 113 Minuten (SD=44), im Gruppen-Review 139 Minuten (SD=48).

Diskussion

Dass der systematische kollegiale Review von MCQs die Qualität der Prüfungsfragen verbessert, konnte für den deutschen Sprachraum bereits hinreichend dargestellt werden [11], [12], [13]. Was die Vor- und Nachteile verschiedener Review-Verfahrens angeht, finden sich wenige Hinweise [7], die hier vorgestellte Studie sollte helfen, die für die Praxis relevante Frage nach den Vor- und Nachteilen von Einzel- im Vergleich zu Gruppen-Reviews zu klären:

Validität

Die Ergebnisse dieser Studie zeigen, dass beide Review-Verfahren in gleicher Weise valide sind. Es ergibt sich somit keine Entscheidungsgrundlage, eine der beiden Varianten vorrangig zu empfehlen.

Statistisch signifikante Unterschiede in den Beurteilungen der MCF fanden sich allerdings zwischen den Reviewern der vier einzelnen Standorte. Die „Kurz-Anleitung zum Review von MC-Fragen“ allein, obwohl auf den gleichen Grundlagen wie das Wissen der „Experten“ beruhend, war offensichtlich nicht geeignet, über die vier Universitätsstandorte hinweg zu homogenen Beurteilungen zu kommen. Bei den Abweichungen vom Experten-Review gab es über alle Checklisten-Items hinweg betrachtet einen signifikanten Unterschied. Das Ergebnis legt den Schluss nahe, neben andernorts geforderten Autorenschulungen [4] bei breitflächiger Einführung eines standardisierten Review-Verfahrens eine Schulung der Reviewer zu empfehlen [13].

Reliabilität

Auch die an den verschiedenen Standorten festgestellten Mängel waren über alle Checklisten-Items betrachtet nicht davon abhängig, ob die Fragen im Einzel- oder im Gruppen-Review beurteilt worden waren. Somit ergibt sich auch hier keine Entscheidungsgrundlage für eine der beiden Varianten.

Anders verhielt es sich wieder beim Vergleich der Hochschulstandorte untereinander: hier fanden sich statistisch signifikante Unterschiede bei allen Items, die einer statistischen Auswertung zugeführt werden konnten. Die Forderung nach einer Reviewer-Schulung lässt sich somit bekräftigen.

Fragebögen

Möchte man sicherstellen, dass sich bundesweit möglichst viele Lehrende an einem wechselseitigen Review von MCF nachhaltig beteiligen, sollte sichergestellt sein, dass sie von der Notwendigkeit eines solchen Vorgehens überzeugt sind und die Verfahrensweise aus ihrer Sicht effektiv und subjektiv zufriedenstellend ist. Aus diesem Grund wurden die einzelnen Reviews von Fragebögen begleitet, die diese Parameter abfragten.

Über alle vier Standorte gemittelt erhielten sowohl die Fragen nach der Zufriedenheit, der Effektivität des Review-Prozesses, als auch nach der Einschätzung der Wichtigkeit des Reviews eine geringfügig höhere Zustimmung nach dem Gruppen-Review als nach dem Einzel-Review. Betrachtet man die Fragen für die einzelnen Standorte getrennt, findet sich die größere Zustimmung nach dem Gruppen-Review nahezu durchgehend wieder. Lediglich an einem Standort (Uni 1) fand die Frage nach der Zufriedenheit mit dem Review-Prozess mehr Zustimmung nach dem Einzel-Review. Auch hier wären gruppendynamische Prozesse zu diskutieren: der Standort Uni 1 hatte mit 210 Minuten Bearbeitungszeit im Gruppen-Review die längste Zeit von allen Review-Sitzungen benötigt. Dies könnte auf Probleme schließen lassen, zu gemeinsam verantworteten Entscheidungen zu finden.

Die Freitextkommentare zu den Einzel- und Gruppen-Reviews spiegeln die zu erwartenden Vor- und Nachteile der beiden Verfahren wieder: die freie Zeiteinteilung steht beim Einzel-Review den fehlenden Rückkopplungsmöglichkeiten mit Kollegen gegenüber. Beim Gruppen-Review erkennt man, dass die zeitlichen Abstimmungsprobleme mit dem häufig angeführten und als positiv erachteten kollegialen Gedankenaustausch und dem damit verbundenen Lerneffekt im Widerspruch stehen.

Zeitaufwand

Betrachtet man lediglich den Fragenpool des Lehrbereiches Allgemeinmedizin in Freiburg, der ca. 280 MCF umfasst (andere Standorte mögen über deutlich umfangreichere Pools verfügen), so lässt sich der enorme Zeitaufwand erahnen, der für den Review des Bestandes aller allgemeinmedizinischen Abteilungen und Lehrbereiche erforderlich ist. Insofern sind die im Rahmen der Studie ermittelten Zeiten bei der Diskussion um das praxistauglichere Review-Verfahren zu berücksichtigen: für die Gruppen-Reviews von 40 MCF wurden im Durchschnitt 26 Minuten mehr benötigt als für die Einzel-Reviews. Folgte man allein diesem Kriterium, müsste eine Empfehlung in Richtung Einzel-Reviews ausgesprochen werden. Interessanterweise wird dieser etwas höhere Zeitaufwand in den Freitextkommentaren nicht thematisiert.

Schwächen

Die relativ kleine Stichprobe der Reviewer, die zudem aus Gründen der Machbarkeit keine Zufallsstichprobe darstellte, schränkt die Verallgemeinerbarkeit der Studienergebnisse ein. Da bewusst die Mitarbeiter in den allgemeinmedizinischen Abteilungen und Lehrbereichen ausgewählt worden waren, die sich auch in der Alltagsroutine mit dem Erstellen und/oder dem Review von Prüfungsfragen befassen ohne über eine spezifische Zusatzausbildung zu verfügen, wurden zwangsläufig Diskrepanzen bei medizinischer Erfahrung und testtheoretischem Vorwissen in Kauf genommen. Beides schränkt die Vergleichbarkeit ein.

Die zehn Items umfassende Checkliste, anhand derer die MCF zu beurteilen waren, bildet nicht alle in der Literatur [3], [4], [5] aufgeführten Kriterien zur Erstellung „guter“ MCF ab. Einige Items müssen als redundant angesehen werden, andere Bewertungskriterien, wie die wichtige Frage nach der Relevanz einer MCF [11], fehlen.

Schlussfolgerungen

Bei der Suche nach einer Entscheidungshilfe für die Empfehlung des besser geeigneten Review-Verfahrens können die Ergebnisse dieser Studie durchaus hilfreich sein.

Wie im Ergebnisteil dargestellt und in der Diskussion ausgeführt, lässt sich ein statistisch signifikanter Unterschied in der Validität und Reliabilität beider Vorgehensweisen nicht darstellen, hierüber allein ist eine Entscheidung für oder gegen eines der Verfahren nicht abzuleiten.

Vor diesem Hintergrund bekommen die subjektiven Einschätzungen der Studienteilnehmer zu den Reviews umso mehr Gewicht. Diese tendieren mehr in Richtung Gruppen-Review. Der Zeitfaktor wird dabei scheinbar von den Studienteilnehmern der Zufriedenheit sowie der subjektiven Einschätzung zur Effektivität des Prozesses untergeordnet.

Die spezifische Situation vor Ort kann bei der Auswahl des Verfahrens nachvollziehbar eine entscheidende Rolle spielen: sind die Reviewer wissenschaftliche oder klinisch tätige Mitarbeiter, die für gewöhnlich in einer Abteilung räumlich zusammenarbeiten, wird die Wahl eher auf relativ einfach zu terminierende Gruppen-Reviews fallen können. Werden die Reviews in der Regel von niedergelassenen Lehrbeauftragten durchgeführt (wie in der Allgemeinmedizin häufig üblich), mag der Einzel-Review vom eigenen Arbeitsplatz aus sinnvoller und praktikabler erscheinen.

Aus Gründen der Praktikabilität kamen in der Studie nur Typ A-Fragen zur Anwendung. Grundsätzlich sollten die Ergebnisse jedoch auch auf andere Fragenformate übertragbar sein.

Anmerkung

Danksagung

Für die statistische Beratung zu diesem Projekt gilt mein besonderer Dank Dr. Andreas Möltner, Kompetenzzentrum für Prüfungen in der Medizin - Baden Württemberg, Universität Heidelberg

Interessenkonflikt

Die Autoren erklären, dass sie keine Interessenkonflikte im Zusammenhang mit diesem Artikel haben.

Literatur

[1] Bundesministerium für Gesundheit. Approbationsordnung für Ärzte vom 27.06.2002. BGBL. 2002:2405-2435.[2] Möltner A, Schellberg D, Jünger J. Grundlegende quantitative Analysen medizinischer Prüfungen. GMS Z Med Ausbild. 2006;23(3):Doc53. Zugänglich unter/available from: http://www.egms.de/static/de/journals/zma/2006-23/zma000272.shtml

[3] Haladyna TM, Downing SM, Rodrigues MC. A review of multiple-choice item-writing guidelines for a classroom assessment. Appl Meas Educ. 2002;15:309-344. DOI: 10.1207/S15324818AME1503_5

[4] Krebs R. Anleitung zur Herstellung von MC-Fragen und MC-Prüfungen für die ärztliche Ausbildung. Bern: Institut für Medizinische Lehre IMS, Abteilung für Ausbildungs- und Examensforschung AAE; 2004.

[5] AG Progress Test Medizin. Progress Test Medizin. Leitfaden für Fragenautorinnen und –autoren des Progress Test Medizin. Berlin: Charité Universitätsmedizin; 2003.

[6] Jünger J, Möltner A, Lammerding-Köppel M, Rau T, Obertacke U, Biller S, Narciß E. Durchführung der universitären Prüfungen im klinischen Abschnitt des Medizinstudiums nach den Leitlinien des GMA-Ausschusses Prüfungen: Eine Bestandsaufnahme der medizinischen Fakultäten in Baden-Württemberg. GMS Z Med Ausbild. 2010;27(4):Doc57. DOI: 10.3205/zma000694

[7] Kazubke E, Schüttpelz-Brauns K. Gruppenleistungen beim Review von Multiple-Choice-Fragen – ein Vergleich von face-to-face und virtuellen Gruppen, mit und ohne Moderation. GMS Z Med Ausbild. 2010;27(5):Doc68. DOI: 10.3205/zma000705

[8] Brown H, Prescot R. Applied Mixed Models in Medicine, Second Edition. Oxford/UK: John Wiley & Sons, Ltd; 2006. DOI: 10.1002/0470023589

[9] Beitler PJ, Landis JR. A Mixed-effects Model for Catagorical Data. Biometr. 1985;41:991-1000. DOI: 10.2307/2530970

[10] Wolfinger R, SUGI Proceedings. Fitting Nonlinear Models with the New NLMIXED Procedure. Cary/NC: SAS Institute Inc; 1999.

[11] Kropf R, Krebs R, Rogausch A, Beyeler C. Auswirkungen angeleiteter Itemanalysebesprechungen mit Dozierenden auf die Qualität von Multiple Choice-Prüfungen. GMS Z Med Ausbild. 2010;27(3):Doc46. DOI: 10.3205/zma000683

[12] Weih M, Harms D, Rauch C, Segarra L, Reulbach U, Degirmenci U, de Zwaan M, Schwab S, Kornhuber J. Qualitätsverbesserung von Multiple-Choice-Prüfungen in Psychiatrie, Psychosomatik, Psychotherapie und Neurologie. Nervenarzt. 2009;80(3):324-328. DOI: 10.1007/s00115-008-2618-8

[13] Rotthoff T, Soboll S. Qualitätsverbesserung von MC Fragen: Ein exemplarischer Weg für eine medizinische Fakultät. GMS Z Med Ausbild. 2006;23(3):Doc45. Zugänglich unter/available from: http://www.egms.de/static/de/journals/zma/2006-23/zma000264.shtml