Kodierübungen im Medizinstudium: Wie gut kodieren Anfänger Diagnosen mit der ICD-10?

Jürgen Stausberg 1Nils Lehmann 1

1 Institut für Medizinische Informatik, Biometrie und Epidemiologie, Universitätsklinikum Essen, Deutschland

Zusammenfassung

Die Vermittlung von Kenntnissen und Fähigkeiten der Dokumentation und der Kodierung gehört zu den Aufgaben des Medizinstudiums. Im Rahmen des Querschnittsbereiches Epidemiologie, medizinische Biometrie und medizinische Informatik wurden daher Kodieraufgaben mit den Studierenden durchgeführt. Hieraus lassen sich Rückschlüsse auf die Kodierqualität bei Anfängern ziehen. In einer Hausarbeit kodierten 118 Studierende Diagnosen von 15 Fällen aus der Nephrologie. Dies wurde mit einer Referenzlösung zur Bestimmung der Validität und untereinander zur Bestimmung der Interrater-Reliabilität verglichen. Auf Ebene der endständigen Kodes waren 59,3% der Angaben richtig, die Vollständigkeit betrug 58,0%. Diese Werte stiegen auf 91,5% bzw. 87,7% bei Betrachtung der Kapitel. Das neu eingeführte, einfache Maß zur Bestimmung der Reliabilität unter den Bedingungen der Diagnosenkodierung ergab Werte von 0,46 für endständige Kodes und 0,87 auf Ebene der Kapitel für die Übereinstimmung der Studierenden untereinander bei vergleichbarem Wert zur Referenzlösung. Demgegenüber liegen Werte aus der Krankenversorgung bei 0,34 bzw. 0,63. Sowohl für die Validität als auch für die Interrater-Reliabilität sind die Ergebnisse der Anfänger somit denjenigen von Experten, also den in der Praxis kodierenden Ärzten, vergleichbar. Der fehlende Vorsprung der Ärzte kann einerseits durch den hohen Dokumentationsaufwand und eine negative Einstellung gegenüber der Kodierung erklärt werden. Andererseits wird die Kodierung unter DRG-Gesichtspunkten durch viele Sonderregeln erschwert, die möglicherweise nicht zu einheitlichen sondern im Gegenteil zu falschen und zufälligen Kodierergebnissen führen. Die Studenten zeigen sich im 1. Semester des 2. Abschnitts der ärztlichen Ausbildung für die Kodierung jedenfalls gut gerüstet.

Schlüsselwörter

Diagnosen, Klassifikation, Kodierung, Medizinstudenten, Reliabilität und Validität

Einleitung

Die Dokumentation nimmt einen großen Teil der täglichen Arbeitszeit von Ärztinnen und Ärzten ein. Der Aufwand im Krankenhaus wird für die Innere Medizin auf 3 Stunden und 15 Minuten täglich pro Arzt geschätzt, für die Chirurgie auf 2 Stunden und 42 Minuten [2]. Hiervon entfallen 12 Minuten auf die Kodierung von Diagnosen und Prozeduren für Abrechnung, Qualitätssicherung und Gesundheitsberichterstattung. Die nach der neuen Approbationsordnung vom 27. Juni 2002 [1] geforderte Befähigung zur selbstständigen ärztlichen Berufsausübung umfasst daher auch die Vermittlung von Kenntnissen und Fähigkeiten der Dokumentation sowie der Kodierung von Diagnosen und Prozeduren mit den gesetzlich hierzu vorgeschriebenen Klassifikationen. Bei der Konzeption des Querschnittsbereiches Epidemiologie, medizinische Biometrie und medizinische Informatik an der Medizinischen Fakultät der Universität Duisburg-Essen wurde daher das Thema Dokumentation sowohl in die begleitende Vorlesung als auch in die scheinpflichtigen Übungen aufgenommen.

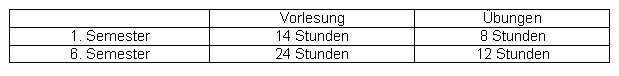

Der Querschnittsbereich ist in Essen geteilt (s. Tabelle 1 [Tab. 1]). Von den 14 Vorlesungsstunden im 1. Semester des 2. Abschnitts der ärztlichen Ausbildung entfallen 4 auf die Medizinische Informatik, eine Übungsstunde ist für die Kodierung reserviert. Der neue Querschnittsbereich wurde erstmalig im Wintersemester 2003/2004 angeboten. Wir wollen die Ergebnisse der Studierenden bei der Kodierung von Diagnosen mit der ICD-10-SGB-V 2.0 [4] vorstellen und diese mit Angaben zur Kodierqualität von Ärzten vergleichen.

Material und Methoden

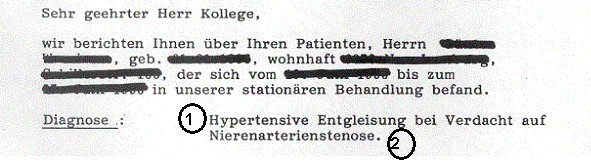

In der freiwilligen Begleitvorlesung im Wintersemester 2003/2004 wurden in einer Stunde allgemeine Aspekte der Dokumentation, in einer weiteren Stunde Klassifikationen behandelt. Eine Stunde Kodierübungen an Computern unter Nutzung des Kodiertools ID DIACOS® der Firma ID GmbH, Berlin, war für alle Studierenden verpflichtend. Geleitet wurden die Übungen teilweise durch den Erstautor, teilweise auch durch vorher geschulte Tutoren, also Studierende höheren Semesters. Nach einer kurzen theoretischen Einführung wurden vorgegebene Diagnosentexte durch die Studierenden mit ID DIACOS® in die ICD-10-SGB-V 2.0 kodiert, mit der Musterlösung verglichen und Unterschiede diskutiert. Als Hausarbeit erhielten die Studierenden ein Arbeitsblatt mit einer Liste von Diagnosen aus einem Arztbrief. Insgesamt standen 15 Fälle mit einer unterschiedlichen Anzahl von Diagnosetexten zur Verfügung. Es handelte sich ausschließlich um nephrologische Krankheitsbilder. Abbildung 1 [Abb. 1] zeigt das allen Studierenden zur Verfügung gestellte Beispiel.

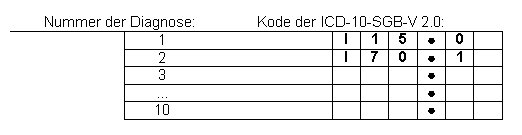

Der jeweilige Fall sollte innerhalb von 5-14 Tagen in die ICD-10-SGB-V 2.0 kodiert werden. Als Hilfsmittel wurden die Studierenden auf die HTML-Fassung der ICD-10 beim Deutschen Institut für Medizinische Dokumentation und Information verwiesen, nicht jedoch auf die Deutschen Kodierrichtlinien. Teilweise konnte ID DIACOS® genutzt werden. Die Ergebnisse waren in der in Tabelle 2 [Tab. 2] dargestellten Form abzugeben. In der schriftlichen Prüfung befasste sich eine von fünf Aufgaben mit der Kodierung. Hier waren fünf vorgegebene Diagnosetexte aus dem Bereich der Hernien unter Zuhilfenahme eines entsprechenden Ausschnittes der ICD-10-GM 2004 zu kodieren: Hernia diaphragmatica (Zwerchfellhernie) (richtige Lösung K44.9), Hernia inguinalis, doppelseitig (beidseitige Leistenhernie) (K40.20), Hernia femoralis, irreponibel, ohne Gangrän (nicht reponierbare Femoralhernie ohne Gangrän) (K41.3), Hernia lumbalis (Lendenhernie) (K45.8), Hernia abdominalis (abdominelle Hernie) (K46.9).

Die von den Studierenden zurückgegebenen Bögen wurden anonym in eine Datenbank unter Microsoft® Access 2000 eingegeben. Die Auswertung erfolgte mit Access, Microsoft® Excel 2000 und SAS Version 8.2. Die verwendeten Kenngrößen sind bei den Ergebnissen dargestellt, um den jeweiligen Kontext zu verdeutlichen. Als Vergleichskollektiv für die Ergebnisse zur Interrater-Reliabilität steht eine Doppelkodierung von 244 chirurgischen Fällen von September 2001 zur Verfügung. Diese Daten waren im Rahmen eines Vergleiches zwischen konventioneller Papierakte und rechnergestützter Basisdokumentation erhoben worden [13]. Ziel des Vergleiches war es, Stärken und Schwächen beider Dokumentationsformen hinsichlich verschiedener Qualitätskriterien der Diagnosen- und Prozedurenkodierung herauszuarbeiten. Das unten eingeführte Reliabilitätsmaß wurde für die Daten dieser Untersuchung neu berechnet.

Von 129 Studierenden wurden 118 Bögen ausgewertet (91,5%), je Fall zwischen 6 und 11 Bögen. Von 519 Kodes waren 13 weder als kodierbarer Endpunkt noch als Knoten zulässig. Diese wurden bis auf zwei korrigiert, indem z. B. eine überflüssige Stelle im Kode gestrichen wurde. Da ein Kode doppelt eingegeben war, verblieben 516 für die weitere Analyse. Hierunter befanden sich noch 27 nicht endständige Kodes. Die Referenzlösung wurde sowohl bei der Hausarbeit als auch in der Klausur durch den Erstautor vorgegeben.

Ergebnisse

Referenzlösung der Hausarbeiten

Für 15 Fälle wurden 66 Kodes benötigt. Im Mittel wurden 4,4 Kodes, im Median 4 Kodes (Spannweite 2-9) pro Fall verwendet. In einem Fall wurde eine Diagnose mit einer Kombination aus einem Kreuz-Kode und einem Stern-Kode abgebildet. Bei 46 unterschiedlichen Kodes kamen 14 nur bei einem Fall vor. Am häufigsten waren die Essentielle (primäre) Hypertonie (I10) mit 5, die Sonstige chronische Niereninsuffizienz (N18.8) mit 4 sowie die Fettleber [fettige Degeneration], anderenorts nicht klassifiziert (K76.0) und die Tubulointerstitielle Nephritis, nicht als akut oder chronisch bezeichnet (N12) mit je 3 Fällen. Häufigste Gruppen waren mit 7 Fällen Hypertonie (I10-I15) und Niereninsuffizienz (N17-N19) sowie mit 6 Fällen Tubulointerstitielle Nierenkrankheiten (N10-N16).

Validität

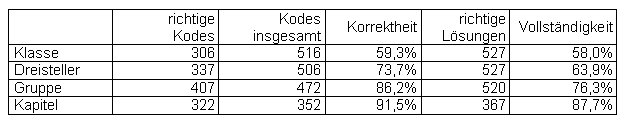

Die Validität der Kodierung kann über die Vollständigkeit und Korrektheit bestimmt werden [7]. Für die Vollständigkeit wird die Anzahl richtiger Kodes im Nenner als Summe des Produkts der Anzahl abgegebener Bögen mit der Anzahl richtiger Diagnosen je Fall berechnet. Die Korrektheit wird als Quotient aus der Anzahl übereinstimmender Kodes zur Gesamtzahl abgegebener Kodes gebildet. Die von Logan [11] vorgeschlagene Unterscheidung zwischen falsch kodierten Diagnosen und nicht kodierten Diagnosen bei der Berechnung der Vollständigkeit war auf Grund der fehlenden eindeutigen Identifikation jeder Diagnose nicht möglich.

Die Berechnung der Vollständigkeit erfolgt analog zur Sensitivität, der Korrektheit analog zum positiven Vorhersagewert. Auf Grund der geringen Fallzahl (N=15) im Verhältnis zu den Klassen der ICD-10-SGB-V 2.0 (N=12 401) ist die Zahl der zu Recht nicht verwendeten Kodes sehr groß. Damit liegen Spezifität und positiven Vorhersagewert automatisch sehr hoch und sind für diese Betrachtung von geringem Interesse.

Tabelle 3 [Tab. 3] stellt Vollständigkeit und Korrektheit dar. Für die Aggregationsebenen der ICD-10 werden auf jeder Ebene nur eindeutige Kodes gewertet. Die Studierenden haben somit auf der Ebene der Klasse 58,0% der Diagnosen richtig kodiert, 59,3% der von den Studierenden ermittelten Ergebnisse sind richtig. Die Korrektheit schwankt zwischen 20,0% und 89,2% je nach Fall. Bei 9 Fällen sind mehr als 50% der Kodes richtig, bei 6 Fällen weniger als 50%. Die Studierenden verwendeten im Mittel ebenfalls 4,4 Diagnosen pro Fall.

In der Klausur zeigte sich folgendes Ergebnis: 73 Studierende hatten alle 5 Diagnosen richtig kodiert, 35 Studierende 4 Diagnosen, 13 Studierende 3 Diagnosen, 3 Studierende 2 Diagnosen und 1 Studierender 1 Diagnose. Keiner der Studierenden hatte keine Diagnose richtig.

Interrater-Reliabilität

Bei unserer Untersuchung treten zwei Sonderbedingungen für die Bestimmung der Interrater-Reliabilität auf. Zum einen ist die Zahl möglicher Kategorien (12 401 Klassen der ICD-10-SGB-V 2.0) im Verhältnis zur Zahl verwendeter Kategorien (123 unterschiedliche Kodes) sehr hoch. Zum anderen werden Mengen mit einer oder mehreren Diagnosen verglichen. Zudem kann auch die Anzahl von Diagnosekodes je Kodierer unterschiedlich sein.

Das κ-Maß dient dem Vergleich einer durch zwei Personen kodierten Hauptdiagnose,

κ=(po-pe)/(1-pe). Hier ist po die Anzahl der Übereinstimmungen bezogen auf die Anzahl der Fälle, und pe die sich aus den Randsummen der Mehrfeldertafel ergebende erwartete Übereinstimmung. Da die Zahl möglicher Kodes der ICD-10 sehr hoch ist, ist die Mehrfeldertafel groß und typischerweise spärlich so besetzt, dass pe<

o(<1) gilt. Damit ist κ ≈ po.

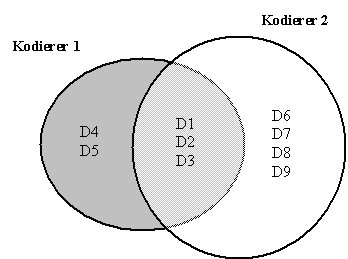

Für den Vergleich mehrerer Diagnosekodes bei 2 Kodierern berechnen wir je Fall P=no/(n1+no+n2). Hierbei ist no die Anzahl übereinstimmender Kodes im gegebenen Fall, n1 die Anzahl der nicht mit Kodierer 2 übereinstimmenden Kodes von Kodierer 1 und n2 die Anzahl der nicht mit Kodierer 1 übereinstimmenden Kodes von Kodierer 2. In Abbildung 2 [Abb. 2] ist no=3, n1=2, n2=4 und P=3/9. Wir erhalten als Maßzahl pom für die Übereinstimmung den Mittelwert der P über die Fälle. Bei einer Diagnose je Fall ist P entweder 0/2 oder 1/1 und es folgt pom=po. Die Maßzahl pom ist demnach eine mögliche Verallgemeinerung von po, gegeben mehrere Diagnosen je Fall.

Zum Vergleich der studentischen Diagnosen (mehrere Bögen je Fall) mit der Referenzlösung berechnen wir je Fall den Mittelwert der P und mitteln anschließend über die Fälle, um pom zu erhalten. Zur Ermittlung der Interrater-Reliabilität bilden wir je Fall alle Paare von Studenten, die diesen kodiert haben (z. B. 5 Bögen bei einem Fall: 5*4/2 Paare), und berechnen das mittlere P. Die Berechnung von pom erfolgt wieder durch anschließende Mittelung über die Fälle.

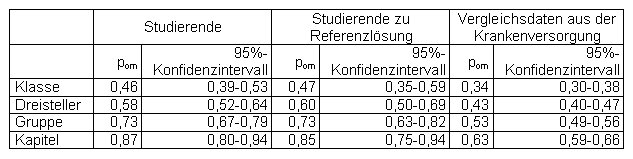

Tabelle 4 [Tab. 4] zeigt die Reliabilität der Studierenden untereinander, die Übereinstimmung mit der Referenzlösung sowie die Ergebnisse aus den Vergleichsdaten der Krankenversorgung. Für die Aggregationsebenen der ICD-10 wurden auf jeder Ebene ebenfalls nur eindeutige Kodes gewertet. Auf Ebene der Klasse liegt pom je Fall zwischen 0,24 und 0,65. Die mittlere Anzahl von Diagnosen je Fall war in den Vergleichsdaten aus der Krankenversorgung 3,9 bzw. 3,7, bei den Studierenden sowie der Referenzlösung 4,4.

Diskussion

Zur Übereinstimmung von Ärzten bei der Kodierung von Diagnosen liegen nur wenige kontrollierte Studien vor (z.B. [12]). Hierbei zeigen sich mäßige Ergebnisse bei der Betrachtung einer einzelnen Diagnose auf dem Niveau des endständigen Kodes (=Klasse). Die Ursachen hierfür sind vielfältig.

a) Die ICD ist fehlerhaft, mehrdeutig, missverständlich und widersprüchlich [15].

b) Bei einer Kodierung auf der Basis von Befunden kann es zu unterschiedlichen Einschätzungen hinsichtlich der vorliegenden Erkrankung kommen [6]. Dieser Umstand entfällt bei der Vorgabe eines Diagnosentextes.

c) Die Regeln zur Kodierung sind mit derzeit 193 Deutschen Kodierrichtlinien für den einzelnen nicht zu überblicken [3].

d) Ökonomische Gesichtspunkte beeinflussen die Validität der Dokumentation [8].

e) Der Aufwand zur Dokumentation ist hoch und in der täglichen Routine kaum zu leisten [2].

f) Das Thema Kodierung ist negativ besetzt. Der Kodierpflicht wird nur widerwillig gefolgt [5].

Von diesen Faktoren können wir in unserer Untersuchung von Studierenden des 1. Semesters im 2. Abschnitt der ärztlichen Ausbildung alle bis auf a) ausschließen. Hingegen war für die Studierenden die Kodierung durch den bislang fehlenden Kontakt mit dem Thema, den Umgang mit einer unbekannten Software sowie das noch unvollständige medizinische Wissen erschwert.

Die Studierenden haben die Kodes der Musterlösungen zu 58,0% richtig kodiert. Dieser Wert liegt höher, als er unter DRG-Gesichtspunkten für die Dokumentation der Krankenhäuser angenommen wird. Bei einer Untersuchung des Medizinischen Dienstes der Krankenversicherung Rheinland-Pfalz wurden im 1. Quartal der Prüfung nur 53,6% der Hauptdiagnosen aus einer Abteilung für Innere Medizin eines Krankenhauses der Grundversorgung bestätigt [14]. Nach einer Lernphase stieg dieser Wert im 3. Quartal auf 69,0%. Für Nebendiagnosen betrug die Vollständigkeit 31,1% im 1. Quartal und im 3. Quartal 44%. Eine Untersuchung von 1974, also noch vor der Entwicklung von DRGs, hatte einen Wert von 65,2% für die Übereinstimmung von Hauptdiagnosen ergeben [9].

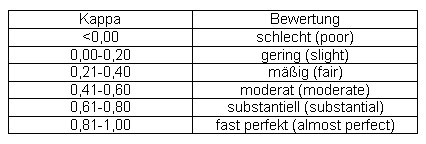

In einer schwedischen Studie wurde der mittlere Kappa-Wert aus 3 Paaren von Kodierern gebildet, die jeweils 50 oder 51 unterschiedliche Befunde mit einer schwedischen Version der ICD-10 kodiert hatten [12]. Unter Zugrundlegung der Einteilung von Landis [10] (s. Tabelle 5 [Tab. 5]) konnte bestenfalls eine moderate Übereinstimmung mit einem Kappa von 0,58 für den endständigen Kode erreicht werden. Die auch bei uns sichtbare Verbesserung auf höher aggregierten Ebenen der ICD-10 zeigte sich hier mit einem Kappa von 0.82 bei Betrachtung der Kapitel. Ähnliche Werte wurden für die Hauptdiagnose mit 0,49 bzw. 0,84 bei einem Vergleich von papiergestützter Krankenakte und rechnergestützter Basisdokumentation ermittelt [13].

Zur Bewertung der Interrater-Reliabilität bei Kodierung von Studierenden wurde in der vorgelegten Untersuchung einerseits die Übereinstimmung mit der Referenzlösung herangezogen. Hierbei zeigen sich kaum Unterschiede. Im Vergleich zu den andererseits nachkalkulierten Daten aus [13] ist die Übereinstimmung jedoch deutlich besser mit einem pom von 0,46 (95%-Konfidenzintervall 0,39-0,53) zu 0,34 (95%-Konfidenzintervall 0,30-0,38). Dieser Unterschied wird auf den höheren Aggregationsebenen der ICD noch deutlicher.

Schlussfolgerungen

Die Validität und Reliabilität der Kodierung von Diagnosen durch Studierende in die ICD-10-SGB-V 2.0 ist mit Ergebnissen von Ärzten vergleichbar. Dieser Vergleich wird allerdings durch das Design der publizierten Studien (zumeist fehlende Kontrolle der Kodierung in der täglichen Praxis) sowie das uneinheitliche Vorgehen zur Bestimmung von Validität und Reliabilität erschwert. Dennoch gibt eine gleich gute Qualität von „Anfängern" (Studierenden) und Experten („Ärzten") zu denken. Unserer Ansicht nach ist die fehlende Überlegenheit der Experten vor allem durch zwei der oben angeführten Ursachen begründet, die wir in unserer Untersuchung ausschließen konnten:

1. Die Deutschen Kodierrichtlinien tragen nicht zu einer richtigen Kodierung bei. Hingegen verwirren sie den Anwender, indem nicht klare Prinzipien, sondern vielfache Ausnahmen in den Vordergrund gestellt werden.

2. Der hohe Aufwand zur Dokumentation beeinflusst in Verbindung mit einer ablehnenden Einstellung in der Ärzteschaft die Kodierung negativ, wodurch auch die Qualität der gewonnenen Daten nicht das mögliche Maß erreicht.

Es ist daher eine radikale Vereinfachung der Kodierrichtlinien zu fordern. Damit wird gleichzeitig ein Beitrag zur Verringerung des Aufwandes geleistet. Zusätzlich sollte das Bewusstein für die Bedeutung von Dokumentation und Kodierung sowie die hierzu notwendigen Kenntnisse, Fähigkeiten und Fertigkeiten schon im Studium vermittelt werden. Die hier vorgelegte Untersuchung zeigt, dass die Studierenden rasch einen zielführenden Zugang zur Kodierung finden.

Gleichzeitig wurde in diesem Beitrag ein einfaches Maß zur Berechnung der Reliabilität von Diagnosenmengen vorgestellt. Die Verwendung eines einheitlichen Maßes würde den kodierenden Bereichen eine sichere Beurteilung ihre Kodierqualität ermöglichen. Weitere Untersuchungen sind allerdings notwendig, um eine qualitative Einordnung von Zahlenwerten der Maßzahl pom entsprechend der o. a. Einteilung von Kappa-Werten zu etablieren.

Danksagung

Die Autoren sind den Studierenden zu Dank verpflichtet, die sich sehr ernsthaft mit dem Thema Kodierung auseinandergesetzt haben. Für die Zurverfügungstellung der Referenzdaten bedanken wir uns bei Herrn Prof. Dr. med. Michael Betzler, Leitender Arzt der Klinik für Allgemeine Chirurgie, Unfall- und Gefäßchirurgie des Alfried Krupp Krankenhauses in Essen.

Literatur

[1] Approbationsordnung für Ärzte vom 27. Juni 2002. Bundesgesetzblatt. 2002;(Teil 1 Nr. 44 vom 3. Juli 2002):2405-35.[2] Blum K, Müller U. Dokumentationsaufwand im Ärztlichen Dienst der Krankenhäuser. Bestandsaufnahme und Verbesserungsvorschläge. Düsseldorf: Deutsche Krankenhausverlagsgesellschaft; 2003.

[3] Deutsche Krankenhausgesellschaft, Spitzenverbände der Krankenkassen, Verband der Privaten Krankenversicherung, Institut für das Entgeltsystem im Krankenhaus. Deutsche Kodierrichtlinien, Version 2004. Düsseldorf: Deutsche Krankenhausverlagsgesellschaft; 2004.

[4] Deutsches Institut für Medizinische Dokumentation und Information. Internationale statistische Klassifikation der Krankheiten und verwandter Gesundheitsprobleme 10. Revision. Systematisches Verzeichnis für die stationäre Versorgung - Version 2.0, Stand November 2000. Köln: Deutscher Ärzteverlag; 2001.

[5] Fietzek M. ICD: Verrat an der ärztlichen Kunst. Dtsch Ärztebl. 2004;101:A1084-A1086.

[6] Friedmann CP, Gatti GG, Murphy GC, Franz TM, Fine PL, Heckerling PS, Miller TM. Exploring the boundaries of plausibility: empirical study of a key problem in the design of computer-based clinical simulations. In: Kohane I, ed. Proceedings AMIA Annual Symposium. Philadelphia: Hanley & Belfus; 2002. p. 275-9.

[7] Hogan WR, Wagner MM. Accuracy of data in computer-based patient records. J Am Med Inform Assoc. 1997;4:342-55.

[8] Hsia DC, Krushat WM, Fagan AB, Tebbutt JA, Kusserow RP. Accuracy of diagnostic coding for Medicare patients under the prospective-payment system. N Engl J Med. 1988;318:352-5.

[9] Institute of Medicine. Reliability of Hospital Discharge Abstracts. Report of a Study. Washington: National Academy of Sciences; 1997.

[10] Landis JR, Koch GG. The measurement of observer agreement for categorical data. Biometrics. 1977;33:159-74.

[11] Logan JR, Gormann PN, Middleton B. Measuring the quality of medical records: A method for comparing completeness and correctness of clinical encounter data. In: Bakken S, ed. A medical odyssey: Visions of the future and lessons from the past. Proceedings AMIA 2001 Annual Symposium. Philadelphia: Hanley & Belfus; 2001. p. 408-12.

[12] Nilsson G, Petersson H, Ahlfeld H, Strender LE. Evaluation of three Swedish ICD-10 primary care visions: Reliability and ease of use in diagnostic coding. Method Inform Med. 2000;39:325-31.

[13] Stausberg J, Koch D, Ingenerf J, Betzler M. Comparing paper-based to electronic patient records: Lessons learned during a study on diagnosis and procedure codes. J Am Med Inform Assoc. 2003;10:470-7.

[14] Stockdreher K, Kuls G, Modrack M, Schlösser A, Walter S, Weibler-Villabos U, Nordhoff M. Parallelkodierung von Krankenhausfällen. Krankenhaus. 2004;96:437-43.

[15] Surján G. Questions on validity of International Classification of diseases-coded diagnoses. Int J Med Inform. 1999;54:77-95.