[Evaluation of medical education]

Hendrik van den Bussche 1Katja Weidtmann 2

Nikolaj Kohler 1

Maike Frost 2

Hanna Kaduszkiewicz 1

1 Universit?tsklinikum Hamburg-Eppendorf, Institut f?r Allgemeinmedizin, Zentrum f?r Psychosoziale Medizin, Hamburg, Deutschland

2 Universit?tsklinikum Hamburg-Eppendorf, Prodekanat f?r Lehre, Hamburg, Deutschland

Abstract

Background:

The importance of evaluation is increasing, not only in medical education. Apart from giving feedback to the teachers the results of evaluations can be used for allocation of educational funds. At the medical faculty of the University of Hamburg the evaluation of medical education has been performed since ten years.

Results:

An analysis of the Hamburg experience in the standardized evaluation of medical education shows a series of problems.

1. The cumulative evaluation of curriculum parts tends to turn out different than the detailed evaluation of its consisting parts.

2. Theoretical courses tend to be assessed worse than clinical courses - irrespective of their real quality. The reason for this "handicap" of theoretical courses is that students tend to rate their benefit for clinical practice lower.

3. There are differences between prompt and delayed assessments of the same courses.

4. Students' assessment also depends on the stage of their training and on the didactic type of the evaluated course.

Conclusion:

Ranking of courses should be performed with caution. To improve reliability and validity of results the following suggestions are made:

1. Results of cumulative evaluation of curriculum parts should be interpreted with care.

2. Unequal opportunities of theoretical and clinical courses to gain good results should be considered.

3. Repeated assessments and longitudinal comparisons are essential.

4. Comparisons should be made only between similar didactical types of courses.

5. Results should be analysed with respect to their possible causes, preferably by mixed evaluation commissions.

6. It is recommended to evaluate aspects of process quality rather than of result quality.

Keywords

evaluation, methodology, medical education

Einleitung

Die Evaluation von Lehrveranstaltungen und curricularen Abschnitten nimmt (nicht nur) in der ?rztlichen Ausbildung zu [1] [2] [3]. Neben der didaktischen Funktion k?nnen die Ergebnisse der Evaluation von Ausbildungsangeboten eine wichtige Basis f?r budget?re Allokationsentscheidungen in der Lehre bilden. Daraus ergibt sich die berechtigte Forderung nach einer angemessenen Reliabilit?t und Validit?t von Evaluationsergebnissen. Dass dies leichter gefordert als eingel?st ist, soll die folgende Analyse von Problemen der Evaluation der ?rztlichen Ausbildung verdeutlichen. Sie beruht auf zehnj?hriger Erfahrung mit der Evaluation von Lehrveranstaltungen an der Hamburger Medizinischen Fakult?t.

Eine Problemauflistung

Es ist eine Binsenweisheit, dass die Ergebnisse von Erhebungen durch die angewandte Erhebungsmethode und durch die Erhebungssituation beeinflusst werden. Dennoch wird in den meisten Erhebungen nur eine Methode benutzt oder die Erhebung auf eine einmalige Messung beschr?nkt. In der Evaluation der ?rztlichen Ausbildung wird vielfach - so auch an der Hamburger Medizinischen Fakult?t - in erster Linie auf standardisierte Frageb?gen zur?ckgegriffen, in denen die Studierenden unter Wahrung ihrer Anonymit?t likertskalierte Statementfragen bewerten (vgl. Abbildung 1 [Abb. 1]).

Der Vorteil dieser Methode liegt in ihrer geringen Personalintensit?t und damit ihrer Kosteng?nstigkeit, ferner in der Gleichbehandlung aller untersuchten Einheiten, seien es Veranstaltungen oder wissenschaftliche Einrichtungen. Dies verleiht ihnen einen Anschein von Objektivit?t. Diese "einheitliche" Methodik geht aber mit einer Reihe von Problemen einher. In der wissenschaftlichen Literatur finden sich viele Arbeiten zu St?r- bzw. Biasvariablen der studentischen Lehrevaluation. Als von vielen Seiten akzeptierte, wenn auch nicht unumstrittene, Biasvariablen gelten das vorbestehende Interesse am Fach bzw. an der Veranstaltung, die Notenerwartung, die Arbeitslast bzw. Schwierigkeit der Veranstaltung und die Gruppengr??e [4] [5] [6] [7]. In der zehnj?hrigen Evaluationst?tigkeit der Lehre an der Hamburger Medizinischen Fakult?t sind weitere Probleme mehrfach aufgetreten und weisen somit einen gewissen ?berzuf?lligen Charakter auf. Diese Probleme werden in diesem Artikel dargestellt und anhand von Beispielen verdeutlicht. Die nachfolgende Beschreibung beansprucht aber keinen Anspruch auf Vollst?ndigkeit und ist kein Beweis daf?r, dass solche Probleme immer auftreten m?ssen. Ziel dieser Publikation ist auf die Gefahr m?glicher Fehlinterpretationen hinzuweisen und den Blick daf?r zu sch?rfen, dass die Beurteilung von Evaluationsdaten mit Vorsicht vorzunehmen ist.

Eine methodische Vorbemerkung: Streng messtheoretisch sind die in den als Beispiele angef?hrten Erhebungen verwendeten Ratingskalen ordinalskaliert, was die Interpretation der Skalenmittelwerte problematisch macht [8]. Aus didaktischen Gr?nden wurde die Darstellung auf der Basis von Mittelwerten dennoch beibehalten.

1. Unterschiede zwischen der Bewertung von Einzelf?chern im Vergleich zu gesamten Curriculumsabschnitten

Mehrfach wurde festgestellt, dass die Bewertung eines gesamten Studienabschnitts sich von der Bewertung der darin enthaltenen einzelnen F?cher bzw. Veranstaltungen betr?chtlich unterscheiden kann. Hierzu folgende Beispiele:

1.1. Die vorklinische Ausbildung

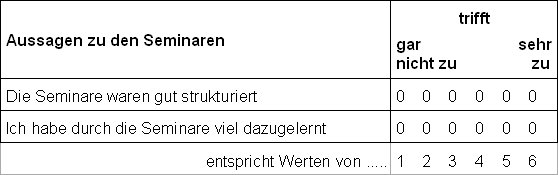

In einer retrospektiven Evaluation der vorklinischen Ausbildung im Jahr 2001 [9] wurde festgestellt, dass die Bewertung der Vorklinik als ganzen Studienabschnitt ?berwiegend deutlich kritischer ausfiel als die Bewertung der Mehrzahl der einzelnen F?cher. So gaben zwei Drittel (65%) der im 5. klinischen Semester retrospektiv befragten 170 Studierenden bei einer R?cklaufquote von 88% an, mit der Vorklinik "insgesamt nicht zufrieden" zu sein (M=2.2 auf einer Vierpunktskala, SD=0.98). Mehr als die H?lfte der Studierenden war der Meinung, "das in der Vorklinik Gelernte sei (eher) nicht von gro?em Nutzen f?r das weitere klinische Studium." (M=2.5; SD=0.85; vgl. Abbildung 2 [Abb. 2]).

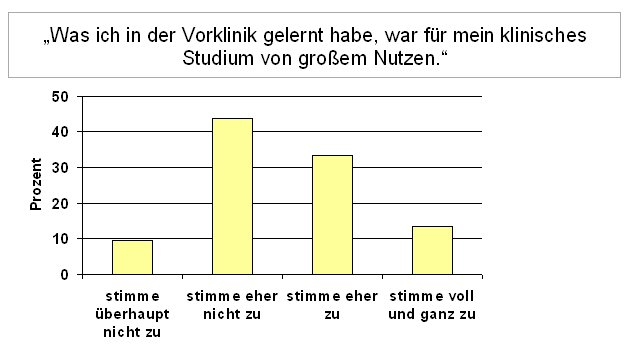

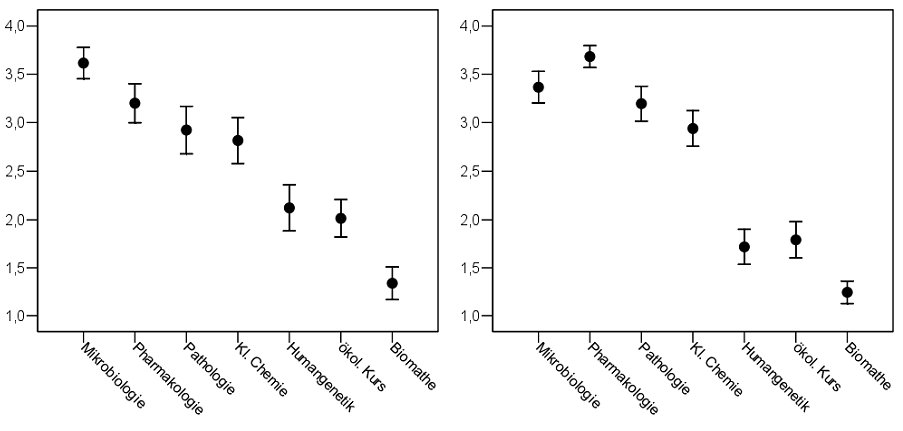

Demgegen?ber ergab die Frage nach dem Nutzen der einzelnen F?cher bzw. Veranstaltungen ein anderes Bild: Immerhin wurden z.B. die Veranstaltungen des Faches Anatomie von den gleichen Studierenden in der gleichen Befragung als eher n?tzlich beurteilt (Werte zwischen drei und vier in der nachfolgenden Abbildung 3 [Abb. 3]).

Nennenswerte Unterschiede nach Geschlecht, Studiendauer oder Physikumsnote wurden bei diesen Einsch?tzungen nicht festgestellt. Diese Kontrollvariablen hatten in derselben Befragung hingegen Einfluss auf die Gesamtzufriedenheit mit der Vorklinik gehabt, d.h. Studierende, die durch das Physikum gefallen waren und l?nger studiert hatten, waren insgesamt unzufriedener.

1.2. Die klinische Ausbildung

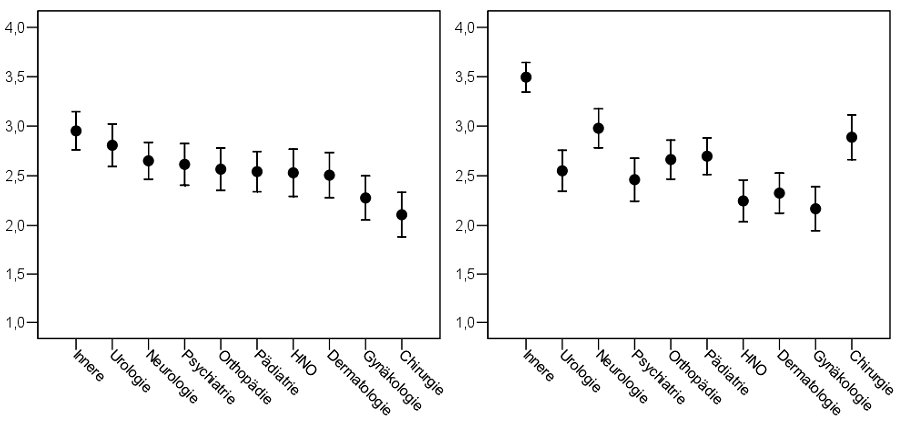

Vergleichbare Diskrepanzen zwischen der Beurteilung der einzelnen Veranstaltungen und des Studienabschnitts wurden auch in Bezug auf die klinische Ausbildung festgestellt. Aus Abbildung 4 [Abb. 4] geht zum Beispiel hervor, dass die didaktische Qualit?t des Unterrichts am Krankenbett und der Nutzen dieser Veranstaltung in einer retrospektiven Befragung von PJ-Studierenden im Jahr 2001 (N=92; R?cklaufquote 49%) f?r die Mehrzahl der F?cher als mittelm??ig (= um den Skalenmittelwert von 2.5) beurteilt wurde.

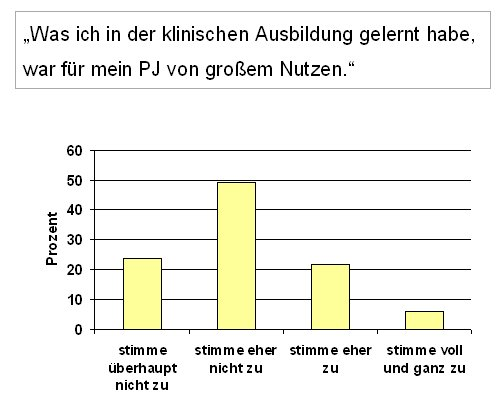

Die Frage nach dem Nutzen der klinischen Ausbildung f?r das PJ wurde von den gleichen Studierenden in der gleichen Befragung deutlich negativer beantwortet. Die Aussage "Was ich in der klinischen Ausbildung gelernt habe, war f?r mein PJ von gro?em Nutzen", wurde nur von einem Viertel der Studierenden bejaht (M=2.1, SD=0.83, vgl. Abbildung 5 [Abb. 5]).

Als Fazit sei festgehalten, dass die Gesamtbeurteilung eines Studienabschnitts negativer bzw. anders auszufallen scheint als die Beurteilung seiner Bestandteile. Die Erkl?rung f?r diese Diskrepanzen liegt vermutlich darin, dass pauschale Fragen eher dazu anregen, auch pauschal zu antworten, w?hrend Fragen nach einzelnen Bestandteilen zu einer eher differenzierten Beurteilung f?hren. Aus Gesamtbeurteilungen von Studienabschnitten oder Studieng?ngen sollte dementsprechend nur mit Vorsicht auf die einzelnen F?cher bzw. Veranstaltungen geschlossen werden.

2. Unterschiede in der Bewertung von F?chern

Implizit wird angenommen, die verschiedenen F?cher h?tten vergleichbare Ausgangsbedingungen bei der Bewertung durch Studierende. De facto aber gibt es - und zwar in der Regel unabh?ngig von der Qualit?t des Lehrangebots am einzelnen Fakult?tsstandort - beliebtere und weniger beliebte F?cher.

Abbildung 6 [Abb. 6] zeigt als Beispiel die retrospektive Beurteilung der "didaktischen Qualit?t" und des "Nutzens f?r Ihre klinische Ausbildung" der klinisch theoretischen F?cher in der bereits in Abschnitt 1.2. beschriebenen Befragung von PJ Studierenden. Die Abbildung zeigt die betr?chtlichen, in der Mehrzahl statistisch signifikanten Unterschiede zwischen den F?chern. Humangenetik, ?kologischer Kurs und Biomathematik liegen in Bezug auf beide Dimensionen unter dem Skalenmittelwert von 2.5, w?hrend die anderen F?cher positiv beurteilt wurden.

In den Veranstaltungsgruppen, die in den Abbildungen 4 und 6 [Abb. 4] [Abb. 6] dargestellt werden, finden wir in der Regel eine positive Korrelation zwischen der Beurteilung der didaktischen Qualit?t und der Nutzeneinsch?tzung der einzelnen F?cher in einer Gr??enordnung von r=0.25 bis r=0.65. Diese sind ausnahmslos zweiseitig auf dem 0.05%-Niveau, in den meisten F?llen sogar auf dem 0.01%-Niveau, signifikant. Die logische Interpretation w?re, dass didaktisch gute Veranstaltungen auch einen h?heren Nutzen haben. In Einzelf?llen unterscheiden sich Nutzen und didaktische Qualit?t jedoch betr?chtlich. Bei einem zweiseitigen t-Test f?r gepaarte Stichproben auf dem 0.01%-Niveau (Ausschluss listwise, n=64) ergeben sich signifikante Unterschiede zwischen den Bewertungen von didaktischer Qualit?t und Nutzen in folgender Weise:

- Didaktische Qualit?t signifikant (p<0.01) gr??er als Nutzen: Humangenetik und ?kologischer Kurs.

- Nutzen signifikant (p<0.01) gr??er als didaktische Qualit?t: Pharmakologie, Pathologie, Innere Medizin, Neurologie und Chirurgie.

Die Auflistung zeigt, dass die Studierenden in vielen F?llen den Nutzen wesentlich h?her bewerten als die didaktische Qualit?t. Offenbar gehen in ihren Nutzenbegriff nicht nur der unmittelbare Nutzen durch die lokale Veranstaltung, sondern auch die lehrangebotsunabh?ngige Bedeutung des Faches f?r die Qualifikation als (junger) Arzt ein. Daraus ergibt sich, dass es problematisch ist, nach dem Nutzen eines Faches bzw. einer Veranstaltung zu fragen, wenn man das lokale Lehrangebot beurteilen und bewerten will.

Zusammenh?nge zwischen Nutzen und Didaktik m?ssen auch bez?glich der Bewertung der vorklinischen F?cher in Abbildung 3 [Abb. 3] diskutiert werden. Der deutliche Zusammenhang zwischen Nutzeneinsch?tzung und Bewertung der didaktischen Qualit?t der F?cher k?nnte auch in diesem Fall darauf zur?ckzuf?hren sein, dass gegenst?ndliche und k?rperbezogene F?cher grunds?tzlich bevorzugt werden, was die positive Einsch?tzung der F?cher Anatomie, Physiologie und Biologie (mit-)bedingen w?rde. Wom?glich h?ngt dies auch damit zusammen, dass diese F?cher von ihrer "Natur" her h?ufiger und plastischer in der Lage sind, dem studentischen Desideratum nach klinischen Bez?gen im Unterricht zu entsprechen. Diese These wird durch mehrere Evaluationen der vorklinischen Ausbildung gest?tzt, in denen das Fach Anatomie durchweg gute Beurteilungen erhielt w?hrend Chemie, Physik, Berufsfelderkundung und Medizinische Psychologie eher negativ beurteilt wurden [10] [11] [12]. Es stellt sich aber auch die Frage nach der F?higkeit der Studierenden, zwischen Nutzen und Didaktik zu differenzieren. Die unterschiedliche Beurteilung von didaktischer Qualit?t und Nutzen einzelner F?cher l?sst sich als Beleg f?r die differenzierte Urteilsf?higkeit interpretieren, die ?ber alle F?cher hinweg deutliche Korrelation hingegen als Beleg dagegen.

Das Problem eines m?glichen F?cherbias stellt sich mit besonderer Sch?rfe, wenn aus den studentischen Bewertungen der F?cher im Rahmen von Konzepten zur leistungsorientierten Mittelvergabe F?cherrankings und darauf basierend Mittelallokationen vorgenommen werden. In diesem Fall m?ssten f?r die nachweislich attraktiveren F?cher "Handicaps" eingebaut werden.

F?r die Fragebogenkonstruktion hei?t dies, dass in den Erhebungen nur nach Parametern gefragt werden sollte, die vom lokalen Lehrangebot und nicht von allgemeinen studentischen Pr?ferenzen bzw. Vorstellungen ?ber den Arztberuf abh?ngen. Dies bedeutet konkret, dass vorrangig nach Parametern der Prozessqualit?t des lokalen Unterrichts, wie Dozentenverhalten, Organisationsqualit?t, Brauchbarkeit von Lernmaterialien etc. gefragt werden sollte und nicht nach m?glicherweise nicht lokal bedingten Faktoren wie Nutzen f?r den ?rztlichen Beruf.

Allerdings sind bez?glich der Attraktivit?tsunterschiede auch andere Zusammenh?nge denkbar:

• Es k?nnte postuliert werden, dass F?cher, bei denen der Nutzen weit gr??er als die didaktische Qualit?t eingesch?tzt wird, tats?chlich auch diejenigen sind, bei denen didaktische Verbesserungen am ehesten angezeigt w?ren. Umgekehrt finden sich auch immer wieder prinzipiell weniger attraktive F?cher, die sich durch besondere didaktische Anstrengungen gute Beurteilungen sichern.

• Unterschiede in der Beurteilung des Nutzens bzw. der didaktischen Qualit?t von F?chern k?nnten auch mit der relativen Angebotsmenge im Sinne einer Mitbeurteilung der Darbietungsdauer ("Quantit?t anstatt Qualit?t") zusammenh?ngen. So korrelieren in der beschriebenen Vorklinik-Untersuchung die Zahl der Veranstaltungsstunden pro Fach mit den Mittelwerten der Beurteilung des Nutzens mit r=0.39 bzw. mit der didaktischen Qualit?t mit r=0.59. Damit w?re die Beurteilung des Nutzens und der Qualit?t der Veranstaltungen (auch) ein Spiegelbild der Schwerpunkte des jeweiligen Studienangebots.

3. Beliebte und ungeliebte Veranstaltungsformen

An der Kohorte der Hamburger Vorklinik Absolventen (Medizinstudierende im 5. klinischen Semester) wurde 2001 auch ?berpr?ft, welche Studierenden die jeweiligen Veranstaltungsformen - Vorlesung, Seminar oder Praktikum - bevorzugten, wovon diese Pr?ferenzen abh?ngen und in welchem Zusammenhang sie mit dem subjektiv empfundenen Lernerfolg stehen. Die Auswertung zeigt, dass Praktika und Seminare gegen?ber Vorlesungen im Durchschnitt als deutlich n?tzlicher angesehen wurden. Diese unterschiedliche Bewertung der Veranstaltungsformen findet sich auch in den Antworten auf die Frage wieder, ob der Stundenumfang einer Veranstaltungsform verringert, beibehalten oder vergr??ert werden sollte. So w?nschten sich weit mehr Studierende einen Ausbau der Seminare (26%) und Praktika (25%), als dies f?r Vorlesungen (2%) der Fall war. In einer vergleichbaren Erhebung im Jahr 2004 wurde die negative Beurteilung der Vorlesung best?tigt: 39% der Studierenden w?nschten einen Ausbau der Seminare, 22% einen Ausbau der Praktika, aber nur 12% einen solchen der Vorlesungen.

Hieraus folgt, dass F?cher, die relativ st?rker auf Vorlesungen basieren, in der studentischen Bewertung in der Regel von vornherein negativer bewertet werden d?rften als solche, die andere Veranstaltungsformen, insbesondere kommunikativere oder praxisorientiertere Typen, anbieten. Hieraus folgt auch, dass es bei vergleichenden, insbesondere rankenden Evaluationen sinnvoll erscheint, vergleichbare Veranstaltungsformen - z.B. Vorlesungen mit Vorlesungen, Unterricht am Krankenbett mit Unterricht am Krankenbett miteinander zu vergleichen bzw. bei F?chervergleichen auf den m?glichen Bias der Veranstaltungsform zu achten.

4. M?gliche Unterschiede zwischen zeitnahen und zeitfernen Veranstaltungsevaluationen

Mehrfach ist aufgefallen, dass die Bewertung der gleichen Veranstaltung durch Studierende je nach Bewertungszeitpunkt - zeitnah oder zeitfern - sehr unterschiedlich ausfallen kann. Als Beispiel werden die Evaluationsergebnisse der ersten Durchf?hrung des Querschnittsbereichs "Gesundheits?konomie, Gesundheitssystem, ?ffentliche Gesundheitspflege" nach der neuen Approbationsordnung f?r ?rzte in Hamburg im Fr?hjahr 2004 dargestellt.

Das Lehrangebot f?r diesen Querschnittsbereich umfasste:

• Vier einst?ndige Einf?hrungsvorlesungen und

• je eine Veranstaltungsreihe zu den Themen "neue Versorgungsformen" einerseits und "Qualit?tssicherung" andererseits, die jeweils aus einer Exkursion zu einem Beispiel f?r eine neue Versorgungsform bzw. einem Qualit?tssicherungsprojekt sowie einem Vor- und einem Nachbereitungsseminar bestand.

• ?ber die Exkursionen hatten die Studierenden in Sechsergruppen einen kritischen Bericht und eine m?ndliche Pr?sentation am Overheadprojektor anzufertigen.

Da auch die Eignung der einzelnen Exkursionsprojekte erfasst werden sollte, wurde zeitnah, d.h. im Anschluss an die beiden Nachbereitungsseminare, eine Evaluation durchgef?hrt. Dar?ber hinaus bewerteten die gleichen Studierenden alle Veranstaltungen am Ende des jeweiligen Trimesters, d.h. nach ca. 12 Wochen Unterrichtsbetrieb. Letztere Evaluation umfasste alle F?cher und Veranstaltungen des Blockes, in casu f?nf F?cher und zwei Querschnittsbereiche.

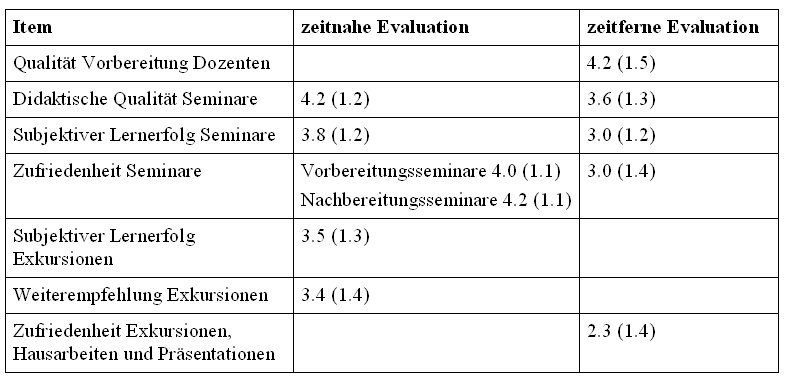

Tabelle 1 [Tab. 1] fasst die Ergebnisse der Evaluationen zusammen. In den beiden zeitnahen Evaluationen (N=151 Frageb?gen bei 85 Teilnehmern - jeder Studierende h?tte idealerweise zwei Evaluationsb?gen abgeben sollen, einen f?r Neue Versorgungsformen und einen f?r Qualit?tssicherung) schnitten die Seminare des Querschnittsbereiches gut, die Exkursionen mittelm??ig ab. In der Endevaluation (n=72) ergab sich aber ?berraschenderweise ein insgesamt deutlich negativeres Bild. Zufriedenheit und Lernerfolg bez?glich der Seminare wurden kapp negativ beurteilt, die Zufriedenheit mit den Exkursionen, Hausarbeiten und Pr?sentationen wurde nunmehr als sehr gering angegeben (M=2.3). Im Gro?en und Ganzen ergab sich eine Differenz zwischen zeitnaher und zeitferner Evaluation von einem ganzen Punkt auf der Sechserskala.

Viele Erkl?rungen f?r diese Unterschiede zwischen zeitferner und zeitnaher Evaluation sind denkbar. Zu der positiven Bewertung, die direkt im Anschluss an die Nachbereitungsseminare abgegeben wurde, mag die Erleichterung der Studierenden beigetragen haben, einen guten Vortrag gehalten zu haben. Denn 79 bzw. 88 Prozent der Pr?sentationen in den Unterrichtseinheiten Neue Versorgungsformen bzw. Qualit?tssicherung wurden mit der Note 1 oder 2 bewertet und den Studierenden sofort mitgeteilt. Auf der anderen Seite kann die eher negative Bewertung der Veranstaltungen in der zeitfernen Evaluation folgende Gr?nde gehabt haben:

- Im Vergleich zu anderen, noch positiver erlebten Veranstaltungen des Themenblocks, k?nnten die Studierenden die Bewertung des Querschnittsbereiches relativiert haben.

- Die negative Bewertung k?nnte das Resultat einer insgesamt schlechten Stimmung der Studierenden am Ende des Trimesters sein. Sie w?re somit Ausdruck einer pauschalen Unzufriedenheit, die sich - anders als in Abschnitt 2.1 beschrieben - auch in der Bewertung der einzelnen Veranstaltungen niederschl?gt.

- Sie k?nnte aber auch die Ver?rgerung ?ber die vielen Leistungsnachweise im Querschnittsbereich widerspiegeln. So hatte jeder Studierende 2 Pr?sentationen und 2 Hausarbeiten anfertigen m?ssen und bereitete sich gegen Ende des Trimesters - zum Zeitpunkt der zeitfernen Evaluation - auf die abschlie?ende Klausur vor.

Die Ursache f?r die Diskrepanz zwischen zeitnaher und zeitferner Evaluation ist im Nachhinein nicht zu ermitteln. Es empfiehlt sich allerdings bei der Evaluation von Veranstaltungen unterschiedliche Zeitpunkte zu w?hlen und die Kontextabh?ngigkeit des Bewertungsverhaltens zu ber?cksichtigen.

5. Beurteilungsunterschiede und Studiendauer

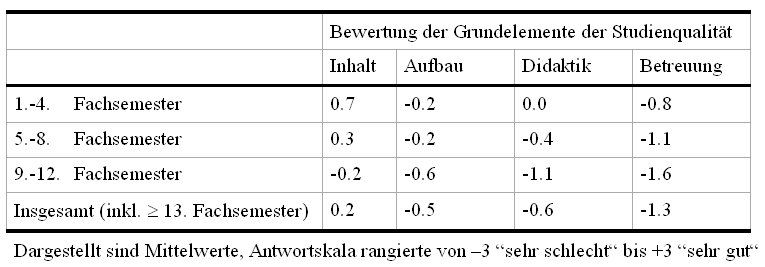

Ein vergleichbares Problem des Befragungszeitpunktes d?rfte es auch f?r das Gesamtstudium geben. Zur Beurteilung der Qualit?t des Studiengangs, d.h. losgel?st von einzelnen Lehrveranstaltungen und Dozenten, untersuchten Bargel und Ramm [13] die Antworten auf einige globale Items zu inhaltlicher (fachliche G?te des Lehrangebots), struktureller (Aufbau und Gliederung), didaktischer (Art und Weise der Veranstaltungsdurchf?hrungen) und tutoraler (Betreuung und Beratung) Qualit?t des Studiengangs Medizin. Im Vergleich der Fachsemestergruppen untereinander schnitt das Medizinstudium bei den Studierenden der Vorklinik am besten ab. Je l?nger die Studierenden studiert hatten, desto schlechter fiel ihre Beurteilung der Erfahrungen im bisherigen Studium aus (vgl. Tabelle 2 [Tab. 2]). In der wissenschaftlichen Literatur ist die Frage, ob Veranstaltungen, die sp?ter im Studium stattfinden, grunds?tzlich schlechter oder besser bewertet werden, allerdings nicht abschlie?end gekl?rt. Marsh und Roche [4] sowie D'Appolonia und Abrami [5] res?mieren in ihren ?bersichtsarbeiten, dass die diesbez?glichen Studienergebnisse uneinheitlich und die Effekte gering sind.

Diskussion und Schlussfolgerungen

Die Analyse hat gezeigt, dass die Ergebnisse standardisierter Evaluationen der ?rztlichen Ausbildung eine Reihe von Erhebungs- und Interpretationsproblemen in sich bergen. Dementsprechend ist stets vorsichtig beim Ziehen von Schlussfolgerungen bzw. gar beim Ranking von F?chern und Veranstaltungen zu verfahren. Eine Verbesserung der Interpretationssicherheit kann ?ber folgende Gesichtspunkte erreicht werden:

- Aus Gesamtbeurteilungen sollte nur mit Vorsicht auf die einzelnen Veranstaltungen geschlossen werden.

- Bei Rankings sind "Handicaps" der theoretischen bzw. patientenfernen F?cher zu bedenken bzw. im Sinne einer besseren Vergleichbarkeit „Handicaps" f?r klinische F?cher einzubauen.

- Einmalige Messungen reichen f?r valide Aussagen nicht aus, Mehrfachmessungen, auch L?ngsschnittvergleiche, sind eine Grundvoraussetzung.

- Vergleiche sollten nach M?glichkeit nur bei vergleichbaren Einheiten (z.B. nach Veranstaltungstyp) vorgenommen werden.

- Empirisch gefundene Unterschiede sind immer auf ihre Ursachen(-B?ndel) zu untersuchen. Auch Fakult?tsvergleiche k?nnen helfen, Fehlinterpretationen zu vermeiden.

- Gleiches gilt f?r die Notwendigkeit, die Bewertungen nicht von einer Person, sondern aus verschiedenen Blickwinkeln (z.B. von gemischten Evaluationskommissionen) vorzunehmen.

- Veranstaltungen und F?cher sollten grunds?tzlich nach verschiedenen Gesichtspunkten bewertet werden. F?r lokale Entscheidungsprozesse sollte nur nach lokal beeinflussbaren Faktoren gefragt werden: Erhebungen zur Prozessqualit?t sind hier grunds?tzlich brauchbarer als solche zur Ergebnisqualit?t.

Zusammenfassend betrachtet gelten f?r die Evaluation von Ausbildungsangeboten die Grundannahmen der Triangulation [14] beim Einsatz von Forschungsinstrumenten. Mehrere Zugangswege - qualitative und quantitative Methoden, offene und geschlossene Erhebungstechniken - sind zu w?hlen und die auf verschiedenen methodischen Wegen gewonnenen Aussagen zu gleichen Fragestellungen vergleichend zu analysieren, um auf diese Weise ein Maximum an Aussagekraft zu erhalten.

Zuallerletzt: Die beschriebenen Probleme sind kein Grund, Evaluationen der Ausbildung zu unterlassen. Perfektion gibt es hier genauso wenig bei der Beurteilung von Forschungsleistungen oder bei der Evaluation von Versorgungsprozessen. Die weitere Beforschung von Ans?tzen zur L?sung der beschriebenen Evaluationsprobleme ist dringend notwendig.

Literatur

[1] Pabst R. Lehrevaluation in der Medizin. Befragungen zur Qualit?t der Lehre in den Hochschulen. Dtsch Arztebl. 2001; B630-B632.[2] Theisel N, Stosch C, Koebke J. Evaluationsbem?hungen an den Medizinischen Fakult?ten in Deutschland - Ergebnisse einer Umfrage. Med Ausbild. 2000;17:18-21.

[3] Weber A, Wacker A, Weltle D, Lehnert G. Stellenwert der Lehre an den deutschen medizinischen Fakult?ten. Dtsch Med Wochenschr. 2000;125:1560-1564.

[4] Marsh HW, Roche LA. Making students' evaluations of teaching effectiveness effective. Am Psychol. 1997;52:1187-1197.

[5] D'Appolonia S, Abrami PC. Navigating Student Ratings of Instruction. Am Psychol. 1997;52:1198-1208.

[6] McKeachie WJ. Student Ratings. The Validity of Use. Am Psychol. 1997;52:1218-1225.

[7] Marsh HW. Student's Evaluations of University Teaching: Dimensionality, Reliability, Validity, Potential Biases, and Utility. Br J Educ Psychol. 1984;76:707-754.

[8] Bortz J, D?ring N. Forschungsmethoden und Evaluation. Berlin. Heidelberg. New York: Springer-Verlag. 1995.

[9] Kohler N, van den Bussche H. Je schwieriger desto beliebter. Nutzen, didaktische Qualit?t und Schwierigkeitsgrad des vorklinischen Lehrangebots aus der Sicht von Hamburger Medizinstudenten. Ann Anat. 2004;186:283-288.

[10] Pabst R, Rothk?tter HJ. Retrospective evaluation of a medical curriculum by final-year students. Med Teach. 1996;18:288-293.

[11] Pabst R, Rothk?tter HJ. Retrospective Evaluation of Undergraduate Medical Education by Doctors at the End of their Residency Time in Hospitals: Consequences for the Anatomical Curriculum. Anat Rec. 1997;249:431-434.

[12] Medizinische Fakult?t der Universit?t zu K?ln. Lehrbericht der Medizinischen Fakult?t der Universit?t zu K?ln. K?ln: Universit?t K?ln. 1999.

[13] Bargel T, Ramm M. Das Studium der Medizin. Eine Fachmonographie aus studentischer Sicht. Schriftenreihe Studien zu Bildung und Wissenschaft 118. Bonn: Bundesministerium f?r Bildung und Wissenschaft. 1994.

[14] Dunkelberg H, van den Bussche H. Triangulation: Von unterschiedlichen Ergebnissen beim Einsatz unterschiedlicher Methoden. Z Arztl Fortbild Qualitatssich. 2004;98:519-525.