Format und Durchf?hrung schriftlicher Pr?fungen

Johannes Schulze 1Stefan Drolshagen 1

1 Johann Wolfgang Goethe-Universit?t Frankfurt/Main, Dekanat des Fachbereichs Medizin, Frankfurt/Main, Deutschland

Zusammenfassung

Alle Leistungsnachweise des klinischen Studienabschnittes nach neuer ?rztlicher Approbationsordnung m?ssen benotet werden; hierzu sind in der Regel schriftliche Pr?fungen notwendig. Bisher erprobte Methoden beinhalten die Pr?fung passiven Wissens (Einfachauswahlfragen, multiple choice-Fragen, progress test-Fragen) und aktiven Wissens (short essay questions, long essay questions). Vor- und Nachteile dieser Verfahren werden diskutiert, sowie die zur Erstellung, Durchf?hrung und Auswertung schriftlicher Pr?fungen notwendigen Ressourcen.

Schlüsselwörter

Einfachauswahlverfahren, MC-Fragen, short essay questions, long essey questions, Pr?fungen, Validit?t, Reliabilit?t, Objektivit?t, Ressourcen

Einleitung

Mit der im Juni 2002 neu gefassten ?rztlichen Approbationsordnung (?AppO) wird ein betr?chtlicher Teil der universit?ren Pr?fungen in der Humanmedizin wieder auf die Fakult?ten zur?ckverlagert. W?hrend bisher zwar Leistungsnachweise verlangt wurden, stellte es die fr?here ?AppO den Fachbereichen frei, wie die erfolgreiche Teilnahme nachgewiesen wurde; nicht selten verzichteten einzelne Disziplinen hierauf. Nun m?ssen im klinischen Studienabschnitt benotete Leistungsnachweise in insgesamt 39 F?chern, Querschnittsbereichen und Blockpraktika erbracht werden. Auch jetzt ist den Fachbereichen die Form der Notenfindung freigestellt; die Notwendigkeit der Benotung macht es jedoch erforderlich, studentische Leistungen nachvollziehbar und ?berpr?fbar zu messen. Die bisher w?hrend des klinischen Studienabschnittes durchgef?hrten Teile des Staatsexamens, fr?hestens nach dem 2. bzw. 6. klinischen Semester, entfallen; der neue 2. Abschnitt wird als fallbezogene schriftliche Abschlusspr?fung nach dem Praktischen Jahr durchgef?hrt.

Pr?fungsformate sollen nach den Lernzielen, der Ausrichtung des studentischen Lernens und den Ressourcen ausgew?hlt werden [22]; in der Regel wird vor allem im klinischen Studium nur eine Mischung verschiedener Formate zu einer guten Pr?fung f?hren. Dar?ber hinaus eignen sich schriftliche Pr?fungen nicht f?r alle Lernziele. Praktische F?higkeiten und Routineanwendungen lassen sich nur mit anderen Methoden wie OSCE pr?fen [10], [15], [23]. Auch wenn dabei die Ergebnisse beider Pr?fungsmethoden stark korrelieren, so werden doch unterschiedliche Wissensbereiche gepr?ft [1], [25]. Die klinische Kompetenz wird dabei von der Summe beider Tests besser vorhergesagt als von den Einzeltests [1], [25]. Dieser Artikel befasst sich nur mit schriftlichen Pr?fungen; f?r eine Bewertung anderer Formate wie OSCE [11], [14], [15], [24] oder globale Beurteilungen in Praktika [11], [22] sei auf die entsprechenden Quellen verwiesen [12].

Methoden

Pr?fungsziele

Jede Pr?fung hat sich den Kriterien Objektivit?t, Reliabilit?t und Validit?t zu unterwerfen [6]. Die lange Diskussion um den Stellenwert von Objektivit?t, Reliabilit?t und Validit?t soll hier nicht wiederholt werden [3], [16], [17]. Eine gute Pr?fung erreicht, dass die Studierenden sich den Lernstoff so aneignen, dass er sp?ter in einer den Anforderungen entsprechenden Weise pr?sent ist [22]. Die Pr?fungsart soll sicherstellen, dass der Lernstoff in einer geeigneten Art - aktives oder passives Wissen - wiedergegeben werden kann; sie steuert dadurch das Lernverhalten der Studierenden [9]. Ideal erscheint auf dem ersten Blick damit eine Pr?fungsart, die den sp?teren Erfordernissen m?glichst nahe kommt (direct validity, [7]). Hierbei wird als Charakteristikum angesehen, dass eine gute Pr?fung mehr durch den Inhalt charakterisiert wird als durch die Pr?fungsergebnisse. Sollen diese Punkte erreicht werden, sind Chancen und Limitationen von schriftlichen Pr?fungsverfahren anhand der angestrebten Lernziele gegeneinander abzuw?gen.

Im Folgenden sollen die weiter verbreiteten schriftlichen Pr?fungsformate kurz skizziert werden, f?r eine ausf?hrliche Bewertung sei insbesondere auf das Handbuch "Kompetent pr?fen" des IAWF [13] in Bern verwiesen.

Einfachauswahlverfahren

Bei diesem Fragentyp ist unter f?nf vorgegebenen M?glichkeiten eine und nur eine M?glichkeit zutreffend und muss markiert werden. Vom Pr?fling wird verlangt, sich zwischen mehreren M?glichkeiten zu entscheiden; wenn dies das Lernziel ist, ist dieser Fragentyp sehr gut geeignet.

Dieser Fragentyp (im Folgenden als MC-Fragen bezeichnet) hat durch die Verwendung in den schriftlichen Staatsexamina ?ber die letzten drei Jahrzehnte die medizinischen Pr?fungen dominiert. Er ist f?r universit?re Pr?fungen durch Gewohnheit, aber auch durch die verwaltungsgerichtliche ?berpr?fung der Fragen [26] sehr beliebt. Die neue ?AppO schreibt diesen Fragentyp nicht explizit vor, sondern legt lediglich ein Antwort-Wahl-Verfahren und die Vorgabe m?glicher Antworten fest (?AppO, ?29,3).

MC-Fragen sind

- schnell und reproduzierbar auszuwerten (hohe Objektivit?t)

- und beinhalten durch viele Fragen viele Items des Stoffgebietes (hohe Reliabilit?t).

Auch wenn das Kriterium der rechtlichen ?berpr?fung allein kein G?tekriterium ist - wie die sehr geringe Zahl von Anfechtungsklagen beim prinzipiell anders strukturierten Abitur mit einem ?hnlich hohen Selektionscharakter zeigt - wird dieses Argument doch immer wieder f?r MC-Fragen vorgebracht. Auch im Hinblick auf die nun von den Fachbereichen zu vertretenden eventuellen Klagen wird einer bisher guten juristischen Pr?fungslage ein hoher Stellenwert zugemessen.

Gute MC-Fragen enthalten neben der richtigen Antwort gute Distraktoren. W?hrend f?r die Pr?fung des Faktenwissens geeignete Distraktoren relativ einfach zu finden sind, gilt dies bei Zusammenhangswissen nur eingeschr?nkt. Hier sind gute Fragen nur schwer zu konstruieren, durch das Einf?gen von Schl?sselworten kann die richtige Antwort h?ufig auch ohne Wissen erraten werden. Sie werden durch ungenaue oder irref?hrende Formulierungen schnell angreifbar. Die schwierige Trennung zwischen "falsch" und "richtig" vor allem im klinischen Studienabschnitt (Lehrmeinungen in unterschiedlichen B?chern) kann durch MC-Fragen mit der geforderten Trennsch?rfe nur schwer nachgebildet werden.

Die Erstellung guter MC-Fragen ist sehr aufwendig. Hierbei ist weniger die Formulierung der "einen" anzukreuzenden M?glichkeit schwierig, sondern die Identifikation geeigneter Distraktoren ("medical education is awash with seriously flawed test questions" [5]). Ein guter Distraktor erscheint zwar plausibel und hat einen engen Zusammenhang zur Fragestellung, andererseits ist er aber eindeutig falsch, und vier geeignete Distraktoren m?ssen gefunden werden. Eine zu gro?e Ferne von der richtigen L?sung wird die Frage sehr leicht machen, eine zu gro?e N?he macht die eindeutige Einordnung als "falsch" schwierig (construct irrelevant variations, [3]). Die Stellung von Fragen einer geeigneten Schwere wird damit in vielen Bereichen problematisch, ebenfalls schwierig wird die Zusammenstellung einer Pr?fung, die sowohl anspruchsvoll ist, aber auch allt?gliches medizinisches Wissen sowie Standardprozeduren beinhaltet (construct underrepresentation; [3]). Diese Faktoren f?hren dazu, dass der in geeigneter Weise zu pr?fende Stoff vor allem in der Klinik limitiert ist, die Verwendung im vorklinischen Bereich erscheint dagegen weniger problematisch.

True-False-Aufgaben

Auswahlfragen k?nnen auch so strukturiert werden, dass eine Frage eine oder mehrere Antwortm?glichkeiten enth?lt, die unabh?ngig bewertet werden m?ssen (z.B. in Progress Tests). Hierdurch entfallen Distraktoren, da der Zwang zur Entscheidung zwischen Alternativen nicht besteht. Ein Beispiel hierf?r ist die F?hrerscheinpr?fung. Neben den M?glichkeiten "richtig" und "falsch" wird in Progress-Test-Pr?fungen oft auch die M?glichkeit "wei? ich nicht" angeboten; die Verwendung dieser Option ist umstritten [22]. True false Fragen k?nnen mit einer beliebigen Anzahl von M?glichkeiten gestellt werden; hierzu geh?rt auch, dass die Fragen bei f?nf zu bewertenden Aussagen formal identisch zu den MC-Fragen aussehen, dass aber nichtsdestotrotz jede der Alternativen individuell beantwortet werden muss.

Eine Modifikation dieser Fragen sind "k aus n-Fragen" [13]. Hierbei werden n Antwortalternativen gegeben, von denen k richtig sind und markiert werden m?ssen. Hier bleibt ein gr??erer Bereich f?r Alternativentscheidungen durch den Zwang, sich auf k Antworten festzulegen.

Beide Fragetypen (MC-Fragen, true-false-Fragen) testen das Wiedererkennen der richtigen L?sung bzw. das Wiedererkennen, ob eine Aussage zutrifft. Sie eignen sich damit f?r den Bereich des passiven Wissens. Durch die zus?tzliche Informationsgabe k?nnen auch Entscheidungsprozesse imitiert werden; f?r Wissen, welches sp?ter ohne Vorgaben pr?sentiert werden soll, sind sie nicht geeignet.

Kurzantwort - Fragen

Kurzantwortfragen (short essay questions SEQ) erfordern das Niederschreiben der richtigen Antwort (oder eine der m?glichen richtigen Antworten) in freier Form. Damit wird prim?r aktives Wissen gepr?ft, der "cueing"-Effekt durch Wiedererkennen einer Antwort entf?llt. Kurzantwortfragen werden in einer Reihe gebr?uchlicher Versionen verwendet, die als "short essay questions", "short answer questions", "modified essay questions" oder "short answer management problems" bezeichnet werden [12]. Short essay-Fragen wurden als Alternative zu MC-Fragen entwickelt und derzeit vor allem in angels?chsischen L?ndern als Ersatz oder Erg?nzung zu MC-Fragen eingesetzt [18]; in Deutschland hat diese Frageform bisher keine weite Verbreitung gefunden. Wie bei MC-Fragen erfordern gute short essay-Fragen eine sorgf?ltige Formulierung und Erstellung des L?sungsthesaurus. Das freie Niederschreiben erlaubt auch, vermeintlich einfache Sachverhalte wieder zu pr?fen; sie sind vor allem f?r Kontext-reiche Fragen geeignet [22].

Als Vorteil von Kurzantwort-Fragen ist zu werten, dass durch die aktive Reproduktion in einigen Bereichen die klinische Realit?t besser dargestellt werden kann (Vervollst?ndigung einer Anamnese, Anforderung weiterf?hrender Diagnostik, Befundung). Dies erlaubt eine Ausweitung des abzufragenden Wissensbereiches. Bei der Pr?fung von Routinewissen, bei dem auch im Alltag a priori keine Vorgaben f?r die T?tigkeiten gegeben werden, k?nnen Kurzantwort-Fragen das aktiv vorhandene Wissen ?berpr?fen. Sie sind dementsprechend in modifizierter Form oft auch Bestandteile praktischer Pr?fungen [11], [21].

Eine Alternative zu reinen SEQ-Fragen sind dabei "extended matching"-Fragen (EMQ), bei denen die richtige L?sung aus einem Thesaurus entnommen werden muss. Wenn dieser hinreichend gro? ist und Schreibvarianten sowie Verwechslungen beinhaltet, eignen sich EMQ-Fragen in gleicher Weise wie SEQ [22]. Dies gilt insbesondere, wenn der L?sungsthesaurus f?r mehrere Fragen zusammengefasst ist.

Auch gute SEQ-Fragen sind schwer zu erstellen und erfordern einen hohen Aufwand. Nachteilig ist zudem der h?here Auswertungsaufwand, vor allem durch die M?glichkeit von Schreibvarianten oder mehreren richtigen L?sungen. Dies verringert auch deutlich die Reliabilit?t und Objektivit?t dieses Fragetyps.

Long essay - Fragen

In Long essay-Fragen werden, analog zum Abitur, offene Fragen gestellt, die mit einem l?ngeren Text beantwortet werden. Gefordert wird hierbei die schriftliche Darlegung von Zusammenh?ngen oder die Begr?ndung einer Entscheidung; sie testen hierdurch nicht die Entscheidung selbst, sondern das dieser Entscheidung zugrunde liegende Wissen. Diese Fragen testen vor allem Zusammenhangswissen; eine Anwendung auf konkrete Probleme ist m?glich, aber nicht unbedingt erforderlich.

Long essay-Fragen sollten ebenfalls sorgf?ltig formuliert werden; die l?ngere Bearbeitungszeit reduziert die Anzahl der f?r eine Pr?fung notwendigen Fragen (verminderte Reliabilit?t). Problematisch ist auch die Auswertung; Objektivit?t und Reliabilit?t werden durch Auswertung durch mehrere Personen sowie eine Aufgaben-gebundene Bewertung erh?ht (jeder Auswerter bearbeitet eine Frage f?r alle Studierenden).

Bisher ungekl?rt ist die Validit?t dieses Verfahrens in der Medizin. Zumindest bei problemorientierten Fragen erscheint prima vista ein gr??erer Zusammenhang mit dem sp?teren Patientenmanagement gegeben. Durch das Fehlen von Vorgaben ber?cksichtigen long essay-Fragen auch das aktive Wissen, und sprechen hierdurch einen anderen Wissensbereich an [25]. Die Auswertung von long essay-Pr?fungen ist schwierig und nur durch vorgegebene Bewertungslisten objektivierbar. Hierdurch wird der im Vergleich zu anderen Fragenformaten niedrige Entwicklungsaufwand auf die Auswertung verlagert.

F?r alle Fragenformate bestehen ?hnliche Probleme, die einer jeden schriftlichen Pr?fung inh?rent sind. Einige wichtige Aspekte sollen im Folgenden dargestellt werden, die bei der Auswahl eines Formates ber?cksichtigt werden m?ssen:

Prozedurale ?berlegungen

Ratewahrscheinlichkeit

Studierende und Pr?fer sind sich meist dar?ber im Klaren, dass ein Teil der richtigen Antworten durch geschicktes Raten erreicht werden kann. Dies kann eine erw?nschte Eigenschaft sein, die den ?rztlichen Alltag widerspiegelt; auch hier spielt die Unsicherheit und das "richtige" Raten der Diagnose und geeigneten Therapie eine gro?e Rolle. Raten sollte aber begrenzt sein und bleiben, bei der ?berpr?fung des Verst?ndnisses oder der F?higkeit, Schlussfolgerungen zu begr?nden, sollte der Ratefaktor so klein wie m?glich sein.

Ob Raten grunds?tzlich schlecht ist, oder ob Raten als "begr?ndete Entscheidungsfindung bei unsicherem Wissen" ein wesentliches Element der ?rztlichen T?tigkeit gilt, ist umstritten [2], [4], [6]. Dabei sollte unterschieden werden zwischen "blindem Raten" bei v?lliger Unkenntnis des Lernstoffes, eine eher artifizielle Annahme. F?r dieses Raten wird als Szenario typischerweise angenommen, ob ein Laie eine Pr?fung durch Raten bestehen kann. Dieses Raten wird wesentlich durch die Formulierung beeinflusst (z.B. durch "immer", "nie", "ausschlie?lich" als cueing-Faktoren), d.h. versteckte Hinweise auf die richtige Antwort in der Fragenformulierung. Vor allem im klinischen Bereich gibt es kaum ein "immer" oder "nie"; die Verwendung dieser W?rter markiert eine M?glichkeit sofort als unzutreffend. Ein h?ufigerer cueing-Effekt besteht bei Widerspruch zwischen zwei Aussagen; in diesem Falle ist meist eine der beiden Aussagen richtig. Es gibt derzeit wenig belastbare Untersuchungen zur St?rke dieses Effektes [22]. Bei einem Vergleich von Pr?fungsfragen, die als MC-Frage, alternativ dazu als Frage mit mehreren m?glichen richtigen Antworten (zwischen 0 und 5 richtigen M?glichkeiten) pr?sentiert wurde, zeigte sich, dass ohne Vorgaben weniger als die H?lfte der Studierenden die vollst?ndig richtige Antwort wissen, bei MC-Fragen die richtige Antwort aber zu >80% geraten wird [19]. Cueing ist jedoch nicht auf MC-Fragen beschr?nkt. Da dieser Effekt formulierungsbedingt ist, ist dieses Ph?nomen auch bei anderen Formen der passiven Wissens?berpr?fung in wechselndem Ausma? pr?sent.

Daneben besteht Raten auch darin, bei MC-Fragen von den 5 Alternativen drei auszuschlie?en und zwischen den beiden verbleibenden Variablen eine begr?ndete Entscheidung zu treffen ("scientific guess"). Dieses zweite Raten kommt vielen Entscheidungssituationen nahe und entspricht einem h?ufig akzeptablen, wenn nicht erw?nschten Lernziel; dementsprechend kann das begr?ndete Entscheiden ein angestrebtes Lernziel sein. Begr?ndetes Entscheiden wird wesentlich durch den Fragenkontext beeinflusst und wird durch die Angaben im Fragenstamm gesteuert [22].

Generell gilt, dass bei einer Pr?fung aktiven Wissens die Ratewahrscheinlichkeit gering ist. Bei true false-Aufgaben (ohne die Option "wei? ich nicht") besteht eine Ratewahrscheinlichkeit von 50%. Bei der Bewertung besteht einerseits die M?glichkeit, Falschantworten durch Minuspunkte zu "bestrafen", was f?r eine Gesamtklausur zu einer Ratewahrscheinlichkeit von 0% f?hrt (ausgeglichene Zusammensetzung aus richtigen und falschen Aussagen vorausgesetzt). Da die Vergabe der Minuspunkte kritisch gesehen und auch aus Akzeptanzgr?nden eher abgelehnt wird [22], betr?gt ohne Minuspunkte die Ratewahrscheinlichkeit 50% richtige Antworten.

Trainierbarkeit

Sowohl die reine Ratewahrscheinlichkeit als auch cueing-Effekte k?nnen trainiert werden und begr?nden den Erfolg spezifischer, Format-abh?ngiger Pr?fungsvorbereitungen. Dieser Effekt allein f?hrt dazu, dass nach einer l?ngeren Beibehaltung eines dominierenden Formates dieses bereits deshalb schlecht wird, weil es seit langer Zeit unver?ndert verwendet wird, nicht weil das Format als solches schlecht ist. In gleicher Weise wird jedes Pr?fungsformat, welches durch eine spezifische nichtmedizinische Vorbereitung besser bestanden wird, nach einer l?ngeren Verwendung zur Anpassung der studentischen Vorbereitung f?hren. Geeignet ist dann diejenige Pr?fungsform, die zu einem vom Lehrenden gew?nschten Lernverhalten f?hrt. Bei allen anderen Verfahren kann die Dauer der Verwendung allein ein Parameter f?r eine zunehmend schlechtere Pr?fungsqualit?t sein.

Die jetzt seit etwa 30 Jahren dominierenden MC-Pr?fungen sind auch deshalb in Verruf gekommen, weil sie Altfragenlernen und Wiedererkennen belohnen, aktives Wissen jedoch nicht. Eine "Abk?hlphase" ?ber etwa 10 Jahre w?rde sicherlich gut tun. Generell ist vorzuziehen, Pr?fungen mit einer Mischung verschiedener Fragentypen durchzuf?hren.

Bestehensgrenzen

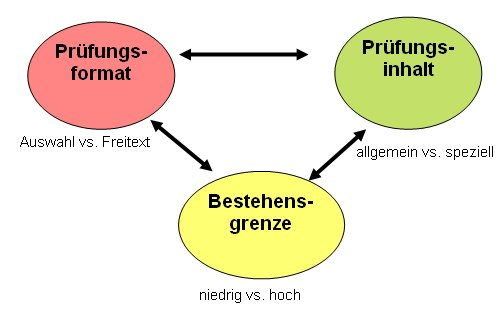

Zwischen dem Fragenformat einer Pr?fung, dem angestrebten Bereich des gepr?ften Wissens (werden h?ufige oder allt?gliche Sachverhalte thematisiert?) und der Bestehensgrenze besteht ein enger Zusammenhang (siehe Abbildung). Vor allem Pr?fungsfragen des passiven Wissens - Wiedererkennen vorgegebener L?sungsalternativen - werden auch durch schw?chere Studierende oft richtig beantwortet. Wird in diesem Format Grundlagenwissen abgefragt (schlechte Distraktoren), muss die Bestehensgrenze hoch liegen, damit der Selektionscharakter erhalten bleibt. Dies zeigt sich exemplarisch in praktischen Pr?fungen nach OSCE (objective structured clinical examinations), bei denen die Bestehensgrenze je nach Station zwischen 60 und 80% der maximal erreichbaren Punktzahl liegt, um dem rechnerischen Einfluss der hohen Anzahl richtiger Items in "leichten" Stationen Rechnung zu tragen. Auch bei der F?hrerscheinpr?fung liegt die Bestehensgrenze mit etwa 90% der Fragen sehr hoch. Andererseits muss die Bestehensgrenze bei Pr?fungen mit "schwerem" Stoff niedrig liegen, damit nicht die Kohorte insgesamt durchf?llt.

Bei den Staatsexamensfragen des IMPP sind sowohl das Fragenformat (MC-Fragen) als auch die Bestehensgrenze (60%) gesetzlich vorgegeben. Um einen Selektionscharakter zu erhalten, muss durch eine entsprechende Fragenschwere der Pr?fungsdurchschnitt "eingestellt" werden, was in den letzten Jahren zum zunehmenden Fragen von Spezialwissen gef?hrt hat. Dennoch erscheint es derzeit m?glich, das Staatsexamen auch dann zu bestehen, wenn objektiv nur wenig gefestigtes Wissen vorliegt [8].

Einfluss nichtmedizinischer Faktoren auf die Fragenbeantwortung

Vor allem bei MC-Fragen wird immer wieder argumentiert, dass Studierende durch Testtraining das Ergebnis beeinflussen k?nnen. Hierzu tragen mehrere Faktoren bei:

- schlechte Formulierung von Fragen;

- "cueing"- und "priming"-Effekt;

- fehlende Vortestung der Fragen durch Ver?ffentlichung;

- weite Verbreitung von Altfragensammlungen.

Probleme der Fragenformulierung und des cueing/priming wurden oben angesprochen. Vortestung ist ein essentieller Faktor bei der Generierung guter Fragen, unabh?ngig vom Typus. Hierbei werden bei der Erststellung der Fragen Schweregrad und h?ufigere Falschantworten eruiert und die Qualit?t der Frage bestimmt. Je st?rker der Einfluss der spezifischen Formulierung auf das Antwortverhalten ist, d.h. je genauer zwischen "Richtig" und "Falsch" unterschieden werden muss, desto wichtiger ist eine Vortestung. Dies erfordert aber, dass Fragen nicht ver?ffentlicht werden und in der exakten Formulierung den Pr?flingen unbekannt bleiben. Bei Ver?ffentlichung der gestellten Fragen ist eine Vortestung wegen der hohen Abh?ngigkeit der Fragenqualit?t von der exakten Formulierung nicht m?glich.

Ver?ffentlichung gestellter Fragen

Das Ausma? der Fragenver?ffentlichung bleibt den Fachbereichen ?berlassen, wird aber nicht einheitlich gehandhabt. Aus testtheoretischen Gr?nden erscheint eine Nichtver?ffentlichung zwingend geboten, so wie es auch bei den Staatsexamina in anderen L?ndern gehandhabt wird. Andererseits haben die Studierenden ein Einsichtsrecht [26], damit im Klagefall eine rechtliche ?berpr?fung begr?ndet werden kann. Zwischen der Geheimhaltung und der ?berpr?fung muss eine geeignete Abw?gung getroffen werden.

Auch die Verbreitung von "Altfragen" wird nicht zu unterbinden sein. Das studentische Bestreben einer optimalen Pr?fungsvorbereitung ist verst?ndlich, Altfragensammlungen sind hierzu ein effizienter Weg. Im Idealfall wird das gesamte zu pr?fende Wissen durch Altfragen abgedeckt; in diesem Fall bilden die Altfragen den Gegenstandskatalog des Faches.

Auch f?r einen solchen "Gegenstandskatalog" ist das Fragenformat problematisch, da nicht alle Lernziele durch ein Fragenformat sinnvoll gepr?ft werden k?nnen. Bei offenen Fragen oder m?ndlichen Pr?fungen stellen vollst?ndige Fragensammlungen ein Lehrbuch in unorthodoxer Struktur dar (z.B. Fall-basierte Lehrb?cher f?r die Vorbereitung zum m?ndlichen Examen). F?r formulierungssensitive Formate (MC-Fragen, true-false-Antworten) kann dies nicht zutreffen. Eine Ver?ffentlichung ist damit abh?ngig von der Vorstrukturierung der Antwort - problematisch bei Fragen zum Ankreuzen, weniger bei SEQ und unproblematisch bei long essay-Fragen oder m?ndlichen Pr?fungen.

Notwendige Ressourcen

Die f?r die Erstellung, Durchf?hrung und Auswertung guter schriftlicher Pr?fungen notwendigen Ressourcen werden weithin untersch?tzt. Der Erstellungsaufwand steigt mit der Formulierungssensitivit?t stark an, er ist insbesondere bei MC-Fragen mit der Notwendigkeit von vier guten Distraktoren sehr hoch. Allgemein werden richtige Alternativen von vielen Lehrenden leichter formuliert als falsche, aber plausibel erscheinende Aussagen. Hierbei sollten immer mehrere Entwickler einbezogen werden, eine gute Frage sollte zudem in einer Klausur vorgetestet sein (blueprinting, [22], [21]). Auch bei true-false-Fragen, Kurzantwortfragen oder extended matching-Fragen ist der Erstellungsaufwand nur unwesentlich geringer; f?r eine objektive Bewertung ist die Erstellung eines m?glichst vollst?ndigen L?sungsthesaurus aller als richtig anerkannten M?glichkeiten vor Fragenstellung notwendig. Dieser Thesaurus sollte m?glichst alle zu erwartenden Antworten einschlie?lich der Schreibvarianten enthalten, sowie die wesentlichen erwarteten Falschantworten. Da keine Antwortalternativen vorformuliert werden m?ssen, beschr?nkt sich der Formulierungsaufwand der Fragen selbst auf den Fragenkopf. Er ist betr?chtlich, wenn - wie angestrebt werden sollte [22] - Kontext-reiche Fragen gestellt werden.

Die Pr?fungsdurchf?hrung ist bei allen Fragentypen ?hnlich. Alle aufgef?hrten Fragem?glichkeiten lassen sich derzeit als Papier-basierte Pr?fung, bei vorhandener Hardware auch als Computer-basierte Pr?fung durchf?hren. Der Aufwand f?r die Vervielf?ltigung der fertigen Pr?fungen und f?r die Aufsicht ist vergleichbar und h?ngt eher von der Zahl der Pr?flinge und dem Umfang ab.

Auswahlfragen lassen sich schnell maschinell auswerten. Das Einscannen der B?gen erfordert eine manuelle Kontrolle auf Lesefehler; die Bewertung der Fragen anhand eines vorgegebenen Bewertungsschemas kann durch Software erfolgen. Eine Anpassung der Software an unterschiedliche Bewertungskriterien ist bei "Richtig-Falsch"-Markierungen unproblematisch, bei Freitextaufgaben hoch. Derzeitige Computerprogramme lassen eine Vorbewertung der Antworten mittels Thesaurus zu; alle Antworten, die nicht im Thesaurus enthalten sind, m?ssen manuell bewertet werden. Dies erfordert die Korrektur durch einen entsprechend ausgebildeten Mitarbeiter, auch ein erfahrener Bewerter ben?tigt hierf?r viel Zeit.

Die Bewertung von Freitextaufgaben sollte immer Frage f?r Frage erfolgen (Item-spezifisch), nicht Klausur f?r Klausur (Studenten-spezifisch; [6]); sie wird erleichtert, wenn die Antworten elektronisch, z.B. in einem Spreadsheet erfasst sind. Noch wesentlich h?her ist der Bewertungsaufwand f?r Long essay Fragen, f?r die neben einer Musterantwort ein ausf?hrlicher Bewertungsbogen erstellt und f?r jede Klausur ausgef?llt werden muss, und sollte unabh?ngig von mehreren Bewertern vorgenommen werden. Angesichts der Studierendenzahlen ist dieser Aufwand wohl von keinem Institut zu leisten und wird dementsprechend in Deutschland auch nicht eingesetzt.

Zusammenfassung

Kein Pr?fungsformat ist per se schlecht oder gut, die Verwendung einzelner Formate sollte sich ausrichten:

- an der gew?nschten Reproduktion des gepr?ften Stoffes (aktives vs. passives Antworten);

- an der gew?nschten studentischen Vorbereitungsweise (Steuerung des Lernverhaltens);

- an der ?hnlichkeit zur sp?teren T?tigkeit (Praxisvorbereitung, Routinef?higkeit);

- an der bisherigen Dauer der Verwendung (Erfahrung mit Vor- und Nachteilen);

- an den zur Verf?gung stehenden Ressourcen (Personalausstattung).

Im Spagat zwischen optimaler Pr?fungsdurchf?hrung und begrenztem Personal muss eine Abw?gung getroffen werden. Die Auswahl eines einzelnen Formates als alleiniges Pr?fungsverfahren erscheint dabei als die schlechteste aller M?glichkeiten. In Abh?ngigkeit vom Lernstoff, dem Ausbildungsstand und den Pr?fungszielen erscheint eine Mischung verschiedener Fragenformate und eine auf das Format und den Schwierigkeitsgrad angepasste Bestehensgrenze als die beste M?glichkeit, das studentische Lernen richtig zu steuern, den gepr?ften Wissensstoff an die Lernziele anzupassen und damit eine m?glichst valide Pr?fung durchzuf?hren (siehe Abbildung 1 [Abb. 1]).

Literatur

[1] Auewarakul C, Downing SM Jaturatamrong E, Praditsuwan R. Sources of validity evidence for an internal medicine student evaluation system: an evaluative study of assessment methods. Med Educ. 2005;39:276-283.[2] Burton RF. Guessing in selected-response tests. Med Educ. 2004;37:112.

[3] Downing SM, Haladyna TM. Validity threats: overcoming interference with proposed interpretations of assessment data. Med Educ. 2004;38:327-333.

[4] Downing SM. Guessing on selected-response examinations. Med Educ. 2003;37:670-671.

[5] Downing SM. On guessing corrections. Med Educ. 2004;38(1):113.

[6] Downing SM. Reliability: on the reproducibility of assessment data. Med Educ. 2004:38;1006-1012.

[7] Ebel RL. The practical validation of tests of ability. Educ Meas: Issues Pract. 1983;2:7-10.

[8] Gebert G. Medizinstudium: Naturwissenschaftliche Grundkenntnisse nach der Vorklinik. Dt Arztebl. 2002;99:A252-253.

[9] Hakstian RA. The effects of type of examination anticipated on test preparation and performance. J Educ Res. 1971;64:319-324.

[10] Harden R, Stevenson M, Downie W, Wilson G. Assesment of clinical competence using objective structured examinations. Br Med J. 1975:;(5955):447-451.

[11] Hudson JN, Tonkin AL. Evaluating the impact of moving from discipline-based to integrated assessment. Med Educ. 2004;38:832-843.

[12] Institut f?r Medizinische Lehre (IML). Kompetent pr?fen. Bern/Wien: IML. 1999:51-52. Zug?nglich unter: http://www.iawf.unibe.ch/aae/aaecontent.asp?pg=72&ID=80.

[13] Institut f?r Medizinische und Pharmazeutische Pr?fungsfragen (IMPP). Musteraufgaben f?r das Staatsexamen f?r Psychologische Psychotherapeuten. Mainz: IMPP: 2006. Zug?nglich unter: www.impp.de/pdf/Musteraufgaben_PT.pdf.

[14] J?nger J, Sch?fer S, Roth C, Schellberg D, Friedman BDM, Nikendei C. Effects of basic clinical skills training on objective structured clinical examination performance. Med Educ. 2005;39:1015-1020.

[15] Miller GE. The assessment of clinical skills/competence/performance. Acad Med. 1990;65:63-67.

[16] Mosier CI. A critical examination of the concept of face validity. Educ Psychol Meas. 1947;7:191-205.

[17] Norcini JJ, Shea JA. The credibility and comparability of standards. Appl Meas Educ. 1997;10:39-59.

[18] Paul S. The job and the exam. Br Med J. 1999;319:Career focus.

[19] Schulze J, Drolshagen S, N?rnberger F, Ochsendorf F, Sch?fer V, Brandt C. Einfluss des Fragenformates in Multiple-choice-Pr?fungen auf die Antwortwahrscheinlichkeit. GMS Z Med Ausbild. 2005;22:Doc. 218. Zug?nglich unter: http://www.egms.de/de/journals/zma/volume22.shtml.

[20] Schulze J, Drolshagen S, Ochsendorf F, N?rnberger F. Question format and knowledge presentation. Edinbourg: AMEE. 2004:Abstract 2G3.

[21] Schuwirth LWT, van der Vleuthen CPM. Changing education, changing assessment, changing research?. Med Educ. 2004;38:805-812. (A)

[22] Schuwirth LWT, van der Vleuthen CPM. Different written assessment methods: what can be said about their strengths and weaknesses?. Med Educ. 2004;38:974-979.

[23] Veloski JJ, Fields SK, Boex JR, Blank LL. Measuring Professionalism: A Review of Studies with Instruments Reported in the Literature between 1982 and 2002. Acad Med. 2005:80;366-370.

[24] Wass V, van der Vleuthen CPM, Schatzer J, Jones R. Assessment of clinical competence. Lancet. 2001;357:945-949.

[25] Wilkinson TJ, Frampton CM. Comprehensive undergraduate medical assessment improve prediction of clinical competence. Med Educ. 2004;38:1111-1116.

[26] Zimmerling W, Brehm RG. Der Pr?fungsprozess: ?berdenkungsverfahren, Klageverfahren, vorl?ufiges Rechtsschutzverfahren. K?ln, Berlin, M?nchen: Carl Heymanns Verlag. 2004;2. Aufl.:54-74.