Qualit?tsverbesserung von MC Fragen

Thomas Rotthoff 1Sibylle Soboll 2

1 Universit?tsklinikum D?sseldorf, Klinik f?r Endokrinologie, Diabetologie und Rheumatologie, D?sseldorf, Deutschland

2 Heinrich-Heine-Universit?t D?sseldorf, Medizinische Fakult?t, Dekanat, D?sseldorf, Deutschland

Zusammenfassung

Wegen fehlender notenrelevanter Pr?fungen an den Medizinischen Fakult?ten in Deutschland bestand bisher keine Notwendigkeit, die Fragenqualit?t in schriftlichen Pr?fungen konsequent zu reflektieren. Erst durch die neue Approbationsordnung sind zeugnisrelevante, fakult?tsinterne Pr?fungen vorgeschrieben. Es fehlen somit oftmals Strukturen und Prozesse, die zu einer Verbesserung der Fragenqualit?t f?hren. Damit die Klausuren das unterschiedliche Leistungsspektrum der Studierenden widerspiegeln, sind u.a. unterschiedliches Schwierigkeitsniveau und eine gute Trennsch?rfe der Pr?fungsfragen notwendig.

F?r eine fach?bergreifende Klausur des vierten Studienjahres an der Universit?t D?sseldorf sollten neue MC -Fragen entwickelt werden, die anwendungsorientiert pr?fen, eindeutig formuliert und weitgehend frei von formalen Fehlern sind.

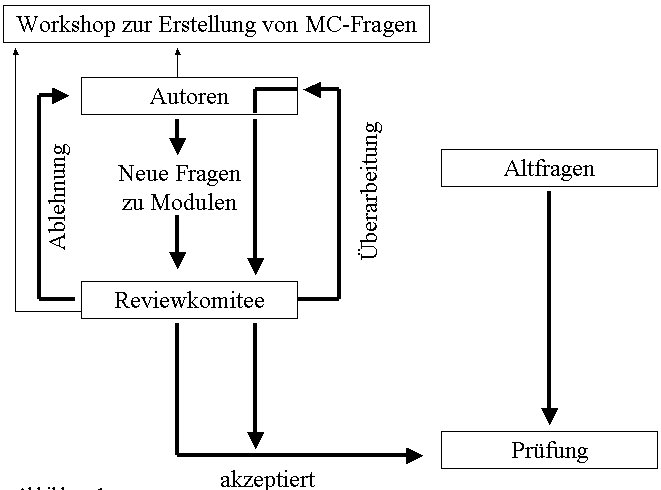

Die Umsetzung erfolgte in der Konzeption und Durchf?hrung von Workshops zur Erstellung von MC-Fragen f?r Fragenautoren und die Einrichtung eines interdisziplin?ren Reviewkomitees.

Es konnte gezeigt werden, dass eine Autorenschulung den Reviewprozess f?r das Reviewkomitee erleichtert und beschleunigt. Der Nutzen des Reviewprozesses spiegelt sich in einer hohen Anwendungsorientierung der einzelnen Items wider. Hochwertige, in einem Reviewverfahren erstellte und messtechnisch analysierte Pr?fungsfragen k?nnten k?nftig in interuniversit?re Datenbanken eingegeben werden und damit den anf?nglich erforderlichen Zeitaufwand relativieren. Durch die interdisziplin?re Zusammensetzung des Reviewkomitees bietet sich au?erdem die M?glichkeit einer verst?rkten Diskussion ?ber die Inhalte der Pr?fungsfragen.

Schlüsselwörter

Pr?fung, MC-Fragen, Multiple-Choice-Frage, Review, Medizinische Ausbildung

Einleitung

Durch die Novellierung der ?rztlichen Approbationsordnung (?AppO) werden ?nderungen in der Ausbildung und bei den Pr?fungen an den medizinischen Fakult?ten in Deutschland notwendig. Bisher dienten die fakult?tsinternen Klausuren im klinischen Abschnitt ausschlie?lich dem Scheinerwerb, ohne dass eine Differenzierung der Pr?fungsergebnisse erfolgen musste. Die an der Heinrich-Heine-Universit?t D?sseldorf (HHU) im klinischen Abschnitt eingesetzten MC-Fragen pr?ften ?berwiegend descriptives, weniger anwendungsorientiertes Wissen und in der Regel waren die Autoren in der Erstellung von MC-Fragen nicht geschult. F?r die Klausuren wurde auch auf einen den Studierenden bekannten Altfragenpool zur?ckgegriffen, woraus Bestehensquoten von teilweise ?ber 95% resultierten.

In der neuen ?AppO sind nun erstmalig benotete Leistungsnachweise in allen klinischen F?chern, einschlie?lich der Querschnittbereiche vorgeschrieben [1]. Diese Noten werden auf dem Abschlusszeugnis gesondert ausgewiesen, womit die Pr?fungen sowohl f?r die Studierenden als auch f?r die Hochschulen eine neue Qualit?t bekommen haben. Die Bedeutung der Noten ist bislang insbesondere im Hinblick auf die Vergleichbarkeit zwischen den Hochschulen unklar. Ein strukturierter Qualit?tssicherungsprozess ist aber vor diesem Hintergrund unabdingbar. Zus?tzlich soll die Anfechtbarkeit der Pr?fung durch eine eindeutige Formulierung der Pr?fungsfragen und damit eine juristische Auseinandersetzung mit den Studierenden vermieden werden.

Projektbeschreibung

Ziel des Projektes war die Entwicklung qualitativ hochwertiger MC-Fragen, die mehr pr?fen sollten als faktisches Wissen und weitgehend frei sind von formalen Fehlern wie z.B. Cues und schlechten Distraktoren [2]. Es sollte den Fragen nachgegangen werden, ob durch eine Dozentenschulung und Implementierung eines Reviewprozesses die Qualit?t von MC-Fragen verbessert werden kann und ob Fragen von geschulten Autoren den Reviewprozess schneller durchlaufen, als die Fragen von nicht geschulten Autoren.

Methode

Eine der ersten Pr?fungen mit benoteten Leistungsnachweisen wurde im klinischen Abschnitt an der HHU am Ende des WiSe 2004/2005 als Abschluss des 2. klinischen Studienjahres durchgef?hrt. F?r dieses Studienjahr wurde mit Beginn des SoSe 04 ein fach?bergreifender Unterricht eingef?hrt, der sich in 24 symptombezogene Wochenmodule aufteilt. Jede Modulwoche wird von einem modulverantwortlichen Oberarzt bzw. Ober?rztin betreut. An den Modulen sind die F?cher Innere Medizin, Chirurgie, klinische Chemie, Gyn?kologie, Urologie und Orthop?die beteiligt. Die Abschlusspr?fung setzt sich aus Fragen zu den Modulen sowie den begleitenden Vorlesungen zusammen. Dabei bilden jeweils drei F?cher- Innere Medizin, Gyn?kologie und Klinische Chemie bzw. Chirurgie, Orthop?die und Urologie einen gemeinsam benoteten fach?bergreifenden Leistungsnachweis. Die drei F?cher eines jeden fach?bergreifenden Leistungsnachweises werden zusammen in einer Klausur gepr?ft. Zus?tzlich wird auch das Ergebnis f?r jedes Einzelfach benotet und auf dem sp?teren universit?ren Abschlusszeugnis ausgewiesen. F?r die F?cher Innere Medizin und Chirurgie wurden je 40 Fragen und f?r die ?brigen F?cher je 20 Fragen gestellt. Auf Beschluss der zust?ndigen Unterrichtskommission sollte die Entwicklung neuer qualit?tsgepr?fter Fragen zun?chst als Pilotphase auf die Lerninhalte der symptombezogenen Module beschr?nkt werden. Die Fragen sollten dann, nach erfolgtem Review, gem?? ihres Inhaltes einzelnen F?chern f?r die sp?tere Bewertung zugeordnet werden. Die restlichen Pr?fungsfragen wurden einem Altfragenpool entnommen. Allen 24 Modulleitern wurde angeboten, an einer Schulung zur Erstellung von MC-Fragen teilzunehmen (siehe Abbildung 1 [Abb. 1]).

Zwei Dozenten der HHU entwickelten ein Workshopkonzept zur Erstellung von MC-Fragen anhand publizierter Kriterien und Standards [3], [4]. In dem D?sseldorfer Workshop wurden im Oktober 2004 unterschiedliche MC Fragen-Typen und die Prinzipien zur Fall-, Fragen- und Antwortkonstruktion vorgestellt. Die Teilnehmer (Modulleiter) sollten eigenst?ndig D?sseldorfer Klausurfragen vom SoSe 2004 in Kleingruppen in Bezug auf Qualit?tsmerkmale analysieren und die Ergebnisanalyse anschlie?end pr?sentieren. Die Teilnehmer erhielten Informationen ?ber die Erstellung einer Fallvignette, die Konstruktion von Antworten bzw. Distraktoren und sie sollten eigene Fragen entsprechend modifizieren.

Au?erdem wurde erstmalig f?r die Begutachtung der Fragen ein neues interdisziplin?res Review-Komitee eingerichtet. Bei der Bildung wurde auf eine interdisziplin?re Zusammensetzung unter Einbindung m?glichst vieler klinischen F?cher geachtet. (Innere Medizin, Chirurgie, Gyn?kologie, Urologie, Allgemeinmedizin und klinische Chemie). Insgesamt bestand das Komitee aus sieben freiwilligen Mitgliedern einschlie?lich des Projektleiters. Es waren sowohl Ober?rzte als auch Assistenz?rztInnen vertreten. Die Mitglieder des Reviewkomitees wurden ebenfalls mit dem o.g. Workshopformat geschult, erhielten jedoch dar?ber hinaus noch Hintergrundinformationen zu pr?fungstechnischen Begriffen.

Insgesamt wurden 24 Modulleiter aufgefordert, eine Fallvignette mit zwei anwendungsorientierten Fragen zu erstellen. Allen Fragenautoren wurde ein publiziertes, auf die D?sseldorfer Situation angepasstes Online-Formular zur Fragenerstellung zur Verf?gung gestellt [3]. Mit diesem Formular wurden die Fragen standardisiert per e-Mail beim Reviewkomitee eingereicht. Das Formular enthielt Angaben ?ber Autor, Pr?fziel und die Quellenangabe der richtigen L?sung sowie ein Feld f?r die Stellungnahme des Reviewkomitees. Die jeweiligen Fristen f?r die Eingabe der Fragen durch die Autoren wurden vom Reviewkomitee festgelegt. Nach Abschluss des Reviewprozesses lagen 37 Fragen vor, wovon 27 Fragen dem Fach Innere Medizin, 7 Fragen der Chirurgie und 3 Fragen der Orthop?die zugewiesen wurden. Die Fragen waren inhaltlich allerdings nicht nach einem Blueprint gewichtet . Die Umsetzung des Projektes wurde durch qualit?tssichernde Ma?nahmen begleitet. Jede neu entwickelte Frage wurde auf ihrem Weg durch den Reviewprozess verfolgt. Innerhalb des Reviewprozesses konnte eine Frage akzeptiert, zur ?berarbeitung an den Autor zur?ckgegeben oder auch abgelehnt werden (siehe Abbildung 1 [Abb. 1]). Dabei waren nur dem Projektleiter die Namen aller geschulten Autoren bekannt. Nach stattgehabter Klausur sollten alle neu erstellten und in die Klausur aufgenommenen Fragen auf ihre Itemschwierigkeit und Trennsch?rfe analysiert werden.

Die Berechnung der korrigierten Trennsch?rfen und Reliabilit?t (Cronbach?s alpha) erfolgte mit der SAS Software [5].

Ergebnisse

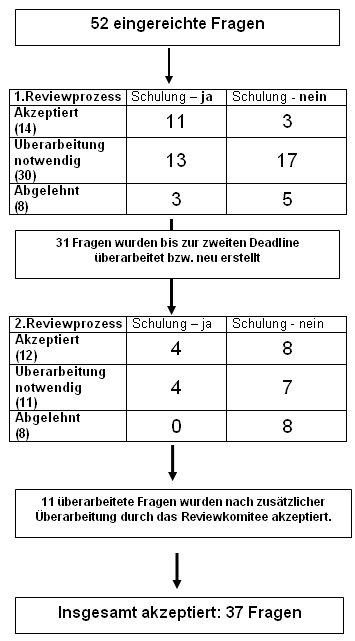

Insgesamt nahmen 19 Personen, davon 13 Modulleiter und sechs Mitglieder des Reviewkomitees, an einem halbt?gigen Workshop zur Erstellung von MC-Fragen teil. 52 Fragen wurden beim Review-Komitee zur Begutachtung eingereicht. Innerhalb des ersten Reviewprozesses (zwei Sitzungen) wurden 14 Fragen direkt akzeptiert, 30 an die Autoren zur?ckgegeben und 8 Fragen abgelehnt (siehe Abbildung 2 [Abb. 2]). Es zeigte sich, dass die Fragen von geschulten Autoren schneller akzeptiert wurden als die Fragen von ungeschulten Autoren. Geschulte Autoren nutzten ?berwiegend Fragen mit Einfachauswahl aus f?nf Antworten mit einer guten Fallvignette und weniger Cues. Ungeschulte Autoren benutzten h?ufig Typ K Fragen (Antwortkombinationen), die wegen ihrer messtechnischen Unsch?rfe international nicht mehr empfohlen werden. Alle Autoren erhielten das kommentierte Online-Formular zur?ck und wurden so ?ber das Ergebnis des Reviewprozesses informiert. Gleichzeitig wurden sie aufgefordert die Fragen zu ?berarbeiten oder bei Ablehnung, neue Fragen zu erstellen. Bis zur Abgabefrist erhielt das Reviewkomitee 31 ?berarbeitete bzw. neu erstellte Fragen zur?ck. Nicht alle Fragenautoren kamen der Aufforderung nach, die Pr?fungsfragen entsprechend der Kommentare des Reviewkomitees zu bearbeiten. Von den geschulten Autoren wurde fristgerecht nur die H?lfte der zu ?berarbeitenden oder neu zu formulierenden Fragen f?r einen zweiten Reviewprozess eingereicht. Ein nicht geschulter Autor sandte noch eine zus?tzliche Frage f?r den zweiten Reviewprozess ein. Insgesamt konnten acht Fragen auch im zweiten Reviewverfahren nicht akzeptiert werden. Die Gr?nde lagen in der unklaren Gesamtkonzeption der Fragen, dem nicht erkennbaren Pr?fziel, inad?quaten Distraktoren, Cues und einer unbefriedigenden Fallvignette. Insgesamt wurden 37 der eingereichten Fragen f?r die Klausur akzeptiert.

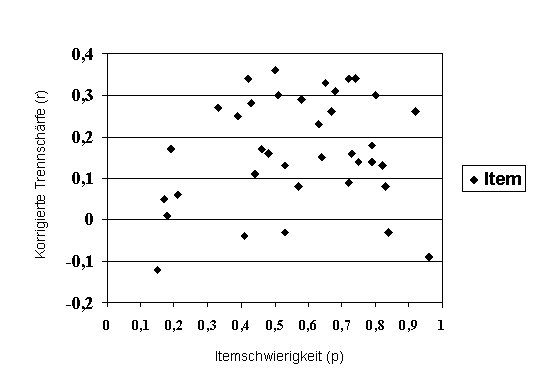

Trennsch?rfe

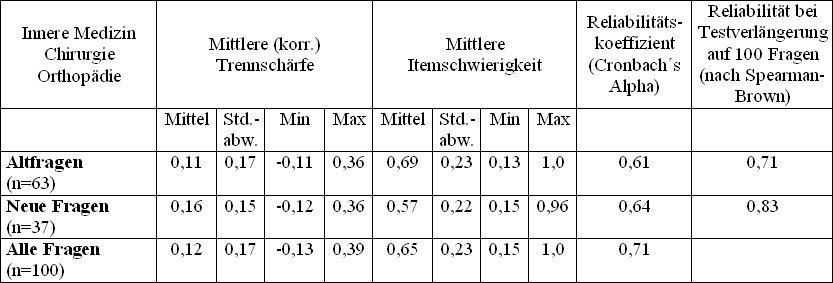

An der Pr?fung nahmen 113 Studierende teil. Die Antwortb?gen wurden elektronisch ausgewertet und f?r jedes Item die korrigierte Trennsch?rfe berechnet. Die Trennsch?rfe gibt die F?higkeit eines Items an, Kandidaten mit guter und schlechter Leistung in der Gesamtpr?fung zu trennen [6]. Um eine valide Aussage ?ber die Trennsch?rfe der neuen Fragen zu erhalten, wurden diese zus?tzlich aus der Gesamtmenge der 100 Fragen aus den F?chern Innere Medizin, Chirurgie und Orthop?die extrahiert und einer separaten Trennsch?rfenanalyse zugef?hrt. Diesen drei F?chern waren die 37 Fragen aus dem Review zugeordnet worden. Die mittlere korrigierte Trennsch?rfe aller 37 neuen Items lag separat gemessen bei 0,16 gegen?ber 0,11 bei den Altfragen der o.g. F?cher (siehe Tabelle 1 [Tab. 1]). Insgesamt hatten von den 37 neuen Items 15 Items (40,5%) eine Trennsch?rfe = 0,2 und je 11 Items (29,7%) eine Trennsch?rfe zwischen 0,1 und 0,2. bzw. < 0,1, wovon f?nf Items eine Trennsch?rfe kleiner Null aufwiesen (siehe Abbildung 3 [Abb. 3]). Bei diesen f?nf Items handelte es ausschlie?lich um chirurgische Items. Die Reliabilit?t (Crohnbach?s alpha) ist mit einem Wert von 0,71 f?r die Gesamtzahl der Fragen noch unbefriedigend. Eine hypothetische Testverl?ngerung mit den neuen Fragen k?nnte zu einem reliableren Pr?fungsergebnis (0,83) f?hren (siehe Tabelle 1 [Tab. 1]).

Itemschwierigkeit

Jedes Item wurde auf seine Schwierigkeit (mittlere erreichte Punktzahl je Item durch die m?gliche Gesamtpunktzahl) hin ?berpr?ft. Die mittlere Schwierigkeit der neuen Fragen lag bei 0,57 bzw. 0,69 bei den alten Fragen (Tabelle 1 [Tab. 1]). Bei einer anzustrebenden Itemschwierigkeit zwischen 0,4 und 0,9 mussten 7 Items (18,9%) mit einem Wert < 0,4 als schwer und nur ein Item mit einem Wert >0,9 (2,7%) als sehr leicht gewertet werden. 29 Items (78,4%) hatten eine ad?quate Schwierigkeit zwischen 0,4 und 0,9.

Diskussion

Schulung und Reviewverfahren

Bei summativen Pr?fungen wie z.B. Staatsexamina, ist ein Review der Pr?fungsfragen internationaler Standard. Ein interdisziplin?rer Reviewprozess war im klinischen Abschnitt der HHU bisher noch nicht implementiert. Wegen fehlender notenrelevanter Pr?fungen existierten bisher wenig Anreize die Fragenqualit?t konsequent zu reflektierten. Es fehlten somit Strukturen und Prozesse, die zu einer Verbesserung der Fragenqualit?t f?hren k?nnten. Der dargestellte Prozess best?tigt, dass eine Autorenschulung zur Erstellung von MC-Fragen und die Einrichtung eines Reviewkomitees die Fragenqualit?t verbessert und die Einfl?sse sachfremder Faktoren und Zuf?lligkeiten auf das Pr?fungsergebnis reduziert. Einschr?nkend muss jedoch darauf hingewiesen werden, dass alle neu erstellten Fragen in diesem Projekt nur mit Altfragen verglichen wurden. Eine Aussage ?ber die Qualit?t neuer Fragen die von ungeschulten Autoren erstellt und keinen Reviewprozess durchlaufen haben, ist nicht m?glich. Es konnte aber gezeigt werden, dass die Schulung der Fragenautoren den Reviewprozess durch eine gr??ere Akzeptanz prim?r eingereichter Fragen und einen geringeren Korrekturaufwand erleichtert und beschleunigt, obwohl auch bei den Autoren eine unterschiedliche Talentierung bei der Fragenerstellung erkennbar ist. Trotz einer schulungsbedingten Beschleunigung des Reviewprozesses ben?tigte der formale Review aller Fragen einen Zeitaufwand von ca. 6 Stunden in gemeinschaftlicher Sitzung. Der Zeitaufwand ist mit dem anderer Fakult?ten vergleichbar. Der Nutzen dieses aufwendigen Reviewprozesses spiegelt sich insbesondere in einer besseren Anwendungsorientierung der einzelnen Items wider, wodurch eine h?here Taxonomie kognitiver Lernziele erreicht wird [7]. Die neuen Items pr?ften klinische Entscheidungsfindungen und nicht ausschlie?lich Faktenwissen.

Trennsch?rfe

Die Angaben bez?glich einer optimalen Trennsch?rfe sind in der Literatur uneinheitlich. F?r fakult?tsinterne Pr?fungen mit h?ufig neu generierten Fragen wird bereits eine zuverl?ssige Leistungsdifferenzierung ab einer Trennsch?rfe > 0,1 m?glichst jedoch > 0,2 genannt [8]. In der psychometrischen Literatur werden dagegen Trennsch?rfen von 0,3 - 0,5 als mittel und erst solche > 0,5 als hoch bezeichnet [8]. Diese beziehen sich jedoch in erster Linie auf k?ufliche, wiederholt eingesetzte und in ihrer Fragenzusammensetzung konstante psychometrische Tests. Wegen des gro?en zeitlichen und personellen Aufwandes f?r eine Fakult?t kontinuierlich neue Fragen zu generieren, ist eine Verwerfung von Fragen mit einer Trennsch?rfe < 0,3 kaum praktikabel. Auf den ersten Blick erscheint die Trennsch?rfenanalyse f?r einige neue Items entt?uschend niedrig. Die Trennsch?rfenanalyse ist aber nicht nur abh?ngig von der Kandidatengruppe sondern auch von der Fragenzusammensetzung einer Pr?fung. Bevor gut formulierte und inhaltlich relevante Fragen eliminiert werden, erscheint es sinnvoll diese bei anderen Kandidaten und in Kombination mit anderen Items einzusetzen und die Messergebnisse zu vergleichen. Psychometrische Messergebnisse sind zwar wichtig f?r die Beurteilung eines Items, sollten aber auch nicht ?berbewertet werden, wenn das Item durch eine gute Anwendungsorientierung und klinischen Bezug zur Validit?t der Pr?fung beitr?gt [9], [10]. Im Gegensatz zu standardisierten psychologischen Tests, in denen in der Regel ein Score aus mehreren Items eine Aussage beispielsweise zu einem Symptomkomplex erm?glicht, steht in einer medizinischen MC-Pr?fung jedes einzelne Item f?r sich. Deshalb sollte sowohl eine ?berpr?fung der formalen Konzeption, die Berechnung von Trennsch?rfe und Schwierigkeit aber auch eine inhaltliche Analyse jedes einzelnen Items erfolgen bevor ?ber seine weitere Verwendung entschieden wird [9].

Ausblick

In einem Reviewverfahren erstellte und messtechnisch analysierte Pr?fungsfragen k?nnen k?nftig in Pr?fungsdatenbanken eingegeben werden, wie sie teilweise schon eingesetzt werden (Progress Test Berlin) oder sich momentan im Aufbau befinden (z.B. an der Universit?t Heidelberg oder f?r die medizinischen Fakult?ten in NRW an der Universit?t M?nster). Im Rahmen eines Pr?fungsverbundes mehrerer Fakult?ten kann so eine kritische Masse an Pr?fungsfragen erstellt und genutzt werden und damit die einzelnen Fakult?ten in der Erstellung von Pr?fungsfragen entlasten. Neben der qualitativen Fragenverbesserung ist zu fordern, dass der interdisziplin?re Reviewprozess auch zu einer inhaltlichen Einflussnahme auf das Curriculum f?hrt. Mittlerweile werden in der Fortsetzung des Projektes die Pr?fungsfragen vom Reviewkomitee auch inhaltlich kommentiert und nur dann f?r die Pr?fung akzeptiert, wenn das Pr?fziel ersichtlich ist und der Frageninhalt sich mit den definierten Lernzielen deckt. Die Erstellung eines Blueprints f?r die Pr?fungsinhalte fand bisher bei den Dozenten noch keine Akzeptanz. Seit dem SoSe 2005 werden die Pr?fungen zus?tzlich von einem Statistiker ausgewertet und die Ergebnisse den Fachbereichen zur Verf?gung gestellt. Geplant ist die Erstellung eines Pr?fberichtes f?r jede Pr?fung zur Qualit?tskontrolle und Verbesserung.

Schlussfolgerung

Die Arbeit zeigt exemplarisch f?r eine medizinische Fakult?t, dass Schulungen von Fragenautoren sowie die Einrichtung eines Reviewkomitees die Qualit?t von MC-Fragen formal und inhaltlich verbessert. Die Autorenschulung beschleunigt den Reviewprozess durch die Ber?cksichtigung formaler Vorgaben bei der Fragenerstellung. Dabei kann sich die Investition in den zeitaufwendigen Reviewprozess durch einen interuniversit?ren Austausch qualit?tsgepr?fter Fragen k?nftig relativieren. Die Fortsetzung des beschriebenen Projektes wurde durch die Unterrichtskommission beschlossen und personell unterst?tzt. Zwischenzeitlich wurde das Projekt in anderen Unterrichtskommissionen vorgestellt und die Gr?ndung von zwei weiteren Reviewkomitees nach gleichem Muster beschlossen. Eines ist bereits seit dem SoSe 2005 f?r das 3. klinische Studienjahr t?tig.

Unter Sicherheitsaspekten ist das aktuelle Verfahren, die Fragen per e-Mail an die Autoren zu verschicken, problematisch. Hier ist k?nftig der Einsatz eines gesicherten Bereiches und eine verschl?sselte Technologie erforderlich.

Danksagung

Mein Dank gilt Prof. Werner A. Scherbaum f?r die Unterst?tzung des Projektes, Dr. Reinhart Willers und Dipl.-Ing. Gerd Kopczynski f?r die Unterst?tzung bei der Fragenanalyse, Dr. Matthias Hofer f?r die Unterst?tzung bei der Entwicklung und Durchf?hrung der Workshops sowie Dr. Martin Fischer f?r die Beratung und kritische Durchsicht des Manuskriptes.

Literatur

[1] Bundesrat. Approbationsordnung f?r ?rzte 2002. Bonn: Bundesanzeiger Verlagsgesellschaft; 2002. Zug?nglich unter: http://www.bmgs.bund.de/download/gesetze/gesundheitsberufe/AeAppO.pdf.[2] MCCourbrie P. Improving the fairness of multiple-choice questions: a literature review. Med Teach. 2004;26(8):709-712.

[3] Bloch R, Hofer D, Krebs R, Schl?ppi R, Weiss S, Westk?mper R. Kompetent pr?fen, Bern/Wien: Institut f?r Aus-, Weiter- und Fortbildung Universit?t Bern; 1999.

[4] Case SM, Swanson DB. Constructing written Test Questions for the Basic and Clinical Sciences. Philadelphia: National Board of Medical Examiners; 2002.

[5] SAS Institute Inc. SAS/STAT User's Guide, Version 9.1. Cary, NC: SAS Institute Inc.; 2004.

[6] Lienert G, Raatz U. Testaufbau und Testanalyse 6. Auflage. Weinheim: Verlag Beltz, Psychologie Verlags Union; 1998.

[7] Bloom BS, Engelhart MD. Taxonomie von Lernzielen im kognitiven Bereich. 4.Aufl. Weinheim u. Basel: Beltz; 1974.

[8] Krebs R. Anleitung zur Herstellung von MC-Fragen und MC-Pr?fungen f?r die ?rztliche Ausbildung. Bern: Institut f?r Medizinische Lehre IML, Abteilung f?r Ausbildungs- und Examensforschung AAE; 2004.

[9] Schuwirth L, van der Vleuten C. Merging views on assessment. Med Educ. 2004;38(12):1208-1211.

[10] Downing SM. Threats to the Validity of Locally Developed Multiple-Choice Tests in Medical Education: Construct-Irrelevant Variance and Construct Underrepresentation. Adv Health Sci Educ Theory Pract. 2002;7(3):235-241.