F?nf Jahre Pr?fungen im Reformstudiengang Medizin an der Charit? - Universit?tsmedizin Berlin

Waltraud Georg 1Sebastian Schubert 1

Dieter Scheffner 1

Walter Burger 1

1 Charit? - Universit?tsmedizin Berlin, Arbeitsgruppe Reformstudiengang Medizin, Berlin, Deutschland

Zusammenfassung

Die Vergabe benoteter Leistungsnachweise ist f?r alle deutschen medizinischen Fakult?ten eine neue Herausforderung. Der Reformstudiengang Medizin (RSM) der Berliner Charit? f?hrt bereits seit 1999 regelm??ig benotete Pr?fungen durch. Ziel dieses Beitrags ist es, deren Entwicklung und wesentliche Ergebnisse darzustellen. Im Mittelpunkt steht dabei die Darstellung der zentralen Pr?fungsorganisation, der MC- und OSCE-Pr?fungen.

Schlüsselwörter

Reformstudiengang Medizin, Pr?fungen, MCQ, OSCE, benotete Leistungsnachweise

Einleitung

Mit dem Beginn des Reformstudiengangs Medizin (RSM) an der Charit? in Berlin im Wintersemester 1999 stand die Fakult?t vor einer ?hnlichen Aufgabe, wie sie die deutschen Fakult?ten derzeit erfahren: nach der jetzt g?ltigen Approbationsordnung f?r ?rzte muss jede Fakult?t f?r die 22 F?cher, 12 Querschnittsf?cher und 5 Blockpraktika im klinischen Studienabschnitt benotete Leistungsnachweise ausgegeben. Als Basis f?r die Vergabe der Leistungsnachweise werden jetzt in der Regel schriftliche, m?ndliche oder praktische Pr?fungen in den Lehrveranstaltungen durchgef?hrt. Dies ist im RSM seit seinem Beginn g?ngige Praxis, da eine zentrale Voraussetzung f?r das Berliner Modell die Ausnahmegenehmigung bez?glich der Anzahl und des Zeitpunktes der gesetzlich vorgeschriebenen Staatsexamina war. Anstelle der ?rztlichen Vorpr?fung und des 1. Abschnitts der ?rztlichen Pr?fung (bisheriges Recht) m?ssen die Studierenden des RSM am Semesterende jeweils eine Semesterabschlusspr?fung absolvieren, deren Noten, ?hnlich wie die Noten der neuen Leistungsnachweise, in einem Beiblatt zum abschlie?enden Staatsexamenszeugnis einzeln aufgef?hrt werden.

Wegweisend f?r die Gestaltung der Pr?fungen im RSM war die bekannte Tatsache, dass Pr?fungen das Lernverhalten der Studierenden ganz wesentlich bestimmen. Da Studierende vor allem das lernen, was gepr?ft wird, muss eine umfassende Curriculumsreform neben ver?nderten Inhalten und Lernformen immer auch grunds?tzliche Ver?nderungen und Anpassungen des Pr?fungssystems vorsehen. Im Unterschied zu den bisherigen Pr?fungen, bei denen F?cher nach einer Unterrichtseinheit meistens abschlie?end gepr?ft wurden, sollen die regelm??igen Leistungstests im RSM den Lehrenden und Lernenden kontinuierliche R?ckmeldung ?ber den Lehr- und Lernerfolg geben. Ihre inhaltliche Ausrichtung entspricht der f?cher?bergreifenden Struktur der Lerninhalte, das hei?t es findet keine isolierte Pr?fung einzelner F?cher statt und die bisherige Dominanz der schriftlichen MC-Pr?fungen, unter Vernachl?ssigung der praktischen Fertigkeiten, wird aufgehoben.

Der RSM kann mittlerweile auf 5 Jahre Erfahrungen mit der Durchf?hrung fakult?tseigener studienbegleitender Pr?fungen zur?ckblicken und somit Erfahrungen und m?gliche Anpassungswege hinsichtlich deren Planung und Durchf?hrung aufzeigen. Im Folgenden werden zun?chst die strukturellen Rahmenbedingungen f?r die Gestaltung der Pr?fungen und anschlie?end Details zu den eingesetzten Pr?fungsformaten dargestellt.

Strukturelle Rahmenbedingungen

1. Das Curriculum im RSM

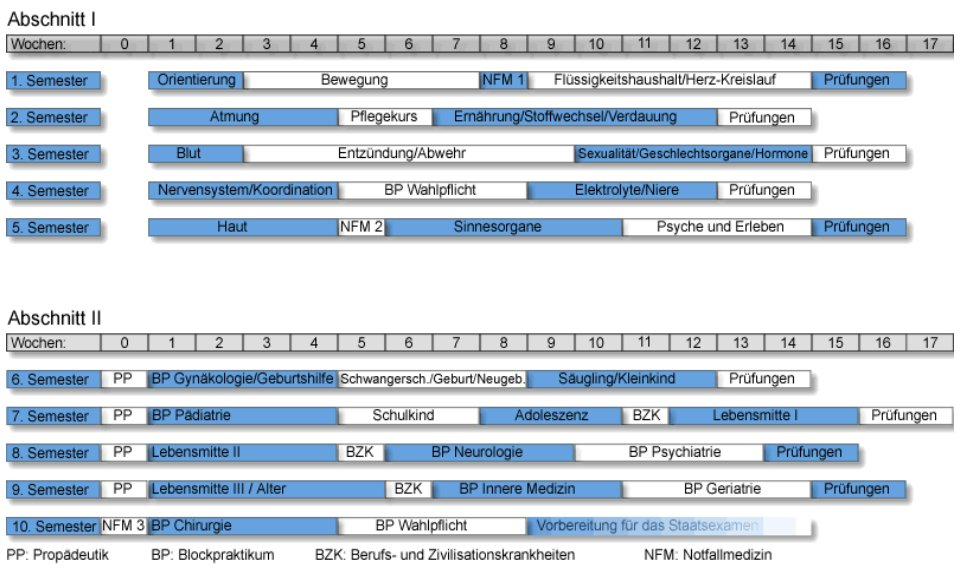

Seit dem Wintersemester 1999/2000 beginnen j?hrlich 63 Studierende ihr Studium im Reformstudiengang an der Charit?, der parallel zum Regelstudiengang durchgef?hrt wird. Sie stellen 10% der j?hrlich immatrikulierten Studierenden f?r Humanmedizin in Berlin dar. Das Curriculum ist in zwei Studienabschnitte gegliedert, die in mehrw?chige Bl?cke unterteilt sind. Sie orientieren sich im ersten Abschnitt an Organsystemen und im zweiten Abschnitt an Lebensaltersabschnitten und werden mit dem 2. Abschnitt der ?rztlichen Pr?fung (bisheriges Recht) abgeschlossen. Darauf folgt das Praktische Jahr und abschlie?end der 3. Abschnitt der ?rztlichen Pr?fung. Eine detaillierte Beschreibung des Curriculums (siehe Abbildung 1 [Abb. 1]) erfolgte andernorts [1].

Die Themenbl?cke werden grunds?tzlich interdisziplin?r geplant und durchgef?hrt. F?r jeden Themenblock werden von einer Blockplanungsgruppe Lernziele formuliert, die f?r die Studierenden und Lehrenden den inhaltlichen Rahmen bilden und nicht zuletzt ma?geblich f?r die Gestaltung der Pr?fungen sind. Um der Komplexit?t ?rztlicher T?tigkeit gerecht zu werden, werden im RSM drei Kategorien von Lernzielen unterschieden, "kognitive", "anwendungsbezogene" und "emotionale" Lernziele.

Die Curriculumsplanung und Durchf?hrung wird durch eine zentrale Arbeitsgruppe (AG RSM) koordiniert, in der wissenschaftliche Mitarbeiter die inhaltlichen Schwerpunkte wie beispielsweise das Problemorientierte Lernen (POL), die ?bung "Interaktion", die Bereiche Simulationspatienten, Pr?fungen und Evaluation fachlich betreuen. Die inhaltliche Verantwortung liegt bei einem von der Fakult?t eingesetztem Studienausschuss. Die Studien- und Pr?fungsordnung [2] f?r den RSM enth?lt Details zum Studienverlauf und den Pr?fungen.

2. Pr?fungsordnung und Verfahrensregelungen

In der Pr?fungsordnung sind optional vier Pr?fungsformate mit entsprechenden Durchf?hrungsbestimmungen vorgesehen: m?ndliche, praktische, schriftliche und kombinierte OSCE-Pr?fungen. Diese k?nnen im zweiw?chigen Pr?fungszeitraum am Semesterende summativ, d.h. bestehensrelevant, eingesetzt werden. Basierend auf den curricularen Inhalten entscheidet der Pr?fungsausschuss, welche Formate im jeweiligen Fachsemester summativ eingesetzt werden. Besteht eine Semesterabschlusspr?fung aus mehreren Teilen, so muss jeder Pr?fungsteil einzeln bestanden und benotet werden. Ausgleichsm?glichkeiten gibt es nicht, weil unterschiedlich Kompetenzen gepr?ft werden. Jeder Pr?fungsteil kann zweimal wiederholt werden, bei dreimaligem Misserfolg m?ssen die Studierenden aus dem Reformstudiengang ausscheiden. Nach jedem Pr?fungsteil haben die Studierenden das Recht, begr?ndete Einspr?che gegen Pr?fungsinhalte zu formulieren und der Pr?fungsausschuss entscheidet abschlie?end ?ber die Wertung/Nicht-Wertung dieser Pr?fungsinhalte.

Basierend auf der Pr?fungsordnung haben sich die nachfolgenden Planungsstrukturen etabliert.

3. Planungsstrukturen f?r die Pr?fungen

Im RSM liegt die Verantwortung f?r die Gestaltung und Durchf?hrung der Semesterabschlusspr?fungen bis einschlie?lich zum 10. Fachsemester bei der Fakult?t. Die ?rztliche Vorpr?fung und der 1. Abschnitt der ?rztlichen Pr?fung (bisheriges Recht) werden durch diese Pr?fungen ersetzt. Einem von der Fakult?t eingesetzten Pr?fungsausschuss obliegt die Kontrolle ?ber ihre Durchf?hrung. Die Ausschussmitglieder mussten aufgrund der neuen Curriculumsstruktur zun?chst Erfahrungen mit neuen Pr?fungsformaten sammeln. Wichtig f?r ihre Arbeit war ein gro?es Interesse an innovativen Methoden und die tats?chliche ?bernahme der Verantwortung f?r die Pr?fungen durch die Ausschussmitglieder. Unterst?tzt wurden sie dabei von den Mitarbeitern des RSM, die sich bereits in der Planungsphase intensiv mit den vielf?ltigen internationalen Entwicklungen und Forschungsergebnissen im Bereich "Pr?fungen in der medizinischen Ausbildung" auseinandergesetzt hatten [3], [4]. Aufgrund dieser Expertise der RSM Mitarbeiter konnten die Sitzungen so vorbereitet werden, dass Entscheidungen im Pr?fungsausschuss auf wissenschaftlich fundierter Basis unter Ber?cksichtigung ihrer Umsetzbarkeit an der Fakult?t getroffen wurden. F?r die Umsetzung der Beschl?sse sind die Mitarbeiter des Pr?fungsbereichs der AG RSM in ihrer koordinierenden Funktion verantwortlich.

Basierend auf den bisher gemachten Erfahrungen wurde im Jahr 2003 im Pr?fungsausschuss schlie?lich ein Leitbild erarbeitet, das "Ziele und Durchf?hrung der Bewertung und Einsch?tzung der Studierenden und des Curriculums im Reformstudiengang Medizin der Charit?" formuliert (verf?gbar unter:

- summative Pr?fung aller Bl?cke gemeinsam am Ende des Semesters

- eindeutiger Bezug der Pr?fungsinhalte auf die formulierten Lernziele des Semesters

- f?cher?bergreifende ?berpr?fung der Lernziele

- Einsatz verschiedener Formate zur Erfassung der unterschiedlicher Dimensionen ?rztlicher T?tigkeit

- Etablierung eines Verfahrens zur Einspruchnahme gegen Pr?fungsteile f?r Studierende

- Engmaschige R?ckmeldung der Ergebnisse an Studierende und Lehrende.

Auswahl und Umsetzung der Pr?fungsformate

Im Pr?fungsausschuss wurde die Entscheidung getroffen, sich zun?chst vornehmlich auf die beiden summativen Formate "Multiple-Choice-Questions" (MCQ) und "Objective Structured Clinical Examination" (OSCE) zu konzentrieren und diese bestm?glich umzusetzen und weiterzuentwickeln. Diese Entscheidung basierte auf der Einsch?tzung, dass qualitativ hochwertige Pr?fungen, die den wesentlichen Testg?tekriterien wie Validit?t, Reliabilt?t und Objektivit?t gen?gen, einen erheblichen Entwicklungsaufwand erfordern, der in Aufbauprozess des RSM nur begrenzt leistbar war. Neben den summativen setzt sich der Pr?fungsausschuss auch mit formativen Pr?fungen auseinander. Formativ, dass hei?t nicht bestehensrelevant, wurden bisher im Verlauf des Modellversuchs vereinzelt m?ndliche Pr?fungen, schriftliche fallbasierte Pr?fungen im MEQ-Format sowie computerbasierte Pr?fungen eingesetzt und evaluiert. Hier lag die Zielsetzung in einem zeitlich eng an den jeweiligen Block gekn?pften Feedback.

Summative Pr?fungsteile

1. Multiple-Choice-Pr?fungen

Der Pr?fungsausschuss hat zu Beginn des RSM nach ausf?hrlicher Diskussion und Ber?cksichtigung der Literatur [5], [6] beschlossen, die kognitiven Lernziele nach jedem Semester mit dem Multiple-Choice-(MC)-Verfahren zu ?berpr?fen.

Trotz des schlechten Rufs dieses Pr?fungsformats bei vielen Studierenden und Lehrenden ?berwiegen dessen Vorteile gegen?ber anderen schriftlichen Pr?fungsformaten: MC-Pr?fungen sind objektiv, auch f?r gro?e Studierendenzahlen kosteng?nstig durchzuf?hren und auszuwerten, sie sind fast allen Studierenden und Lehrenden bekannt und sie sind sehr gut erforscht [7]. Pro Stunde Pr?fungszeit kann mit sorgf?ltig erstellten MC-Fragen eine h?here Reliabilit?t erreicht werden als mit den meisten anderen Pr?fungsformaten [8]. Viele Kritikpunkte, zum Beispiel das ausschlie?liche oder ?berwiegende Pr?fen von isoliertem Detailwissen, sind nicht formatbedingt und lassen sich durch die sorgf?ltige Gestaltung der Fragen vermeiden. Ein weiterer Grund f?r den Einsatz von MC-Pr?fungen im RSM war der Wunsch eine methodische Vergleichbarkeit mit den Pr?fungen im Regelstudiengang zu schaffen.

Die MC-Fragen werden nicht ver?ffentlicht. Als Fragenformate werden nur "Einfachauswahlfragen" und "erweiterte Zuordnungsaufgaben" verwendet [6], [7]. Alle Fragen werden in der eigenen Fakult?t erstellt und es werden m?glichst nur Fragen mit klinischen Fallvignetten verwendet. Die Anzahl der MC-Fragen je Block in der Semesterabschlusspr?fung ist genau festgelegt und richtet sich nach der L?nge des Blocks. Folgendes Vorgehen bei der Erstellung einer MC-Semesterabschlusspr?fung hat sich im RSM bew?hrt:

Grundlage der MC-Pr?fungen sind die Lernziele der Themenbl?cke, ein vierw?chiger Block hat zwischen 25 und 40 Lernziele. Um den Pr?fungsinhalt transparent zu machen, wird nur gepr?ft, was in den Lernzielen steht. Die Blockplanungsgruppe legt die Gewichtung der Lernziele (MC-Fragen pro Lernziel) als "Blueprint" schriftlich fest. Es wird angestrebt, jedes Lernziel mit mindestens einer MC-Frage zu pr?fen. Die Erstellung und Gewichtung der Lernziele durch die interdisziplin?re Blockplanungsgruppe ist ein wichtiges Instrument zur Sicherung der Validit?t der MC-Pr?fung [9].

Im zweiten Schritt wird auf der Basis der Schwierigkeitsindices und Trennsch?rfen aus vorangegangenen Pr?fungen entschieden, welche schon einmal eingesetzten MC-Fragen wieder verwendet werden sollen. Dabei gibt es keine festgelegten Grenzwerte zum Ausschluss von Fragen auf Grund von f?r Schwierigkeit und Trennsch?rfe aber alle Fragen, deren Schwierigkeit au?erhalb p= 0,4-0,85 oder Trennsch?rfe r

Da gelegentlich neue Lernziele hinzukommen, problematische MC-Fragen aussortiert werden, sich die Gewichtung der Lernziele ?ndert und in jeder Pr?fung ein Anteil von mindestens 20% Neufragen anstrebt wird, m?ssen jedes Semester neue MC-Fragen geschrieben werden. Die Blockplanungsgruppe benennt m?gliche Fragenautorinnen und -autoren. Die Erstellung guter MC-Fragen ist eine anspruchsvolle Aufgabe, die dadurch honoriert wird, dass der Zeitaufwand daf?r auf die Lehrleistung angerechnet wird. Die Fragenautorinnen und -autoren sind fast immer auch als Dozentinnen und Dozenten an den Unterrichtsveranstaltungen der Bl?cke beteiligt.

Alle MC-Fragen werden zentral in einer webbasierten Datenbank mit zurzeit ca. 4000 Fragen verwaltet. Alle neu erstellten Fragen durchlaufen einen Peer-Review-Prozess. Dabei wir die ?bereinstimmung zwischen MC-Frage und Lernziel, die Einhaltung des vorgegebenen MC-Fragenformats, die Relevanz und die Angemessenheit f?r den jeweiligen Ausbildungsstand der Studierenden begutachtet. In der Regel werden 70-80% der MC-Fragen von den Autoren mit ?nderungsvorschl?gen des Review-Komitees modifiziert.

Die endg?ltige Auswahl der MC-Fragen f?r die jeweilige Pr?fung erfolgt durch den Blockverantwortlichen, der damit auch die inhaltliche Verantwortung f?r die Pr?fung tr?gt. Die Vorbereitung der Pr?fungsunterlagen, die Organisation, Durchf?hrung und Auswertung der Pr?fung und die Ergebnismitteilung an die Studierenden erfolgt durch die Mitarbeiter der AG RSM.

F?r die MC-Pr?fungen liegt die Bestehensgrenze bei 60% der m?glichen Punkte. Sollte der Mittelwert minus eine Standardabweichung unter 60% liegen, gilt dieser Wert als Bestehensgrenze ("Gleitklausel"). Da die Pr?fungsfragen nicht ver?ffentlicht werden, haben die Studierenden nach jeder Pr?fung die M?glichkeit, die Pr?fungsfragen einzusehen, um Einspr?che gegen einzelne Fragen zu formulieren. Im Durchschnitt werden vier bis f?nf Fragen pro Semester nach Einspr?chen der Studierenden vom Pr?fungsausschuss aus der Wertung genommen.

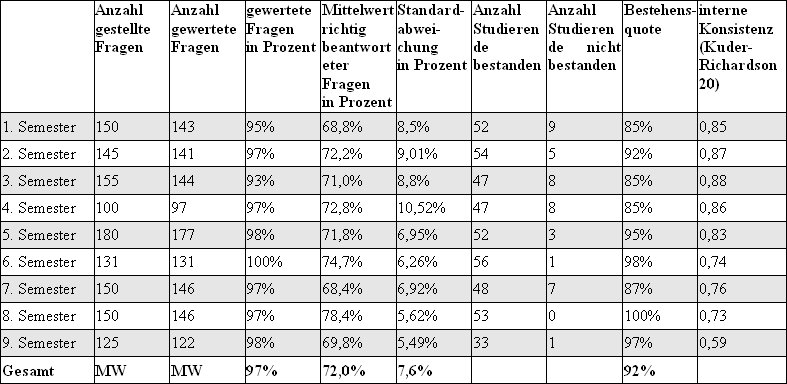

Die Ergebnisse werden an die Fragenautoren und die Blockplanungsgruppen r?ckgemeldet. In der Regel stellt ein Mitarbeiter der AG RSM die Pr?fungsergebnisse auf einer Blockplanungssitzung vor. In der Tabelle 1 [Tab. 1] sind die Anzahl der gestellten und gewerteten Fragen, der Mittelwert und die Standardabweichung der richtig beantworteten Fragen, die Bestehensquote und die interne Konsistenz [11] der MC-Pr?fungen im Wintersemester 2003/2004 und im Sommersemester 2004 dargestellt. F?r das erste bis f?nfte Semester ist die interne Konsistenz, als Ma? f?r die Reliabilit?t der Pr?fungen mit Werten ?ber 0,8 gut. F?r das sechste bis achte Semester sind die Werte akzeptabel. Nur f?r das neunte Semester ist die interne Konsistenz mit 0,59 zu niedrig [12]. Es handelt sich hier um die erstmalige Durchf?hrung dieser Pr?fung, neben der Fragenanzahl und -qualit?t k?nnten die inhaltlich sehr dicht beieinander liegenden Lernziele einen Erkl?rungsansatz f?r die geringere interne Konsistenz liefern. Der Unterschied der internen Konsistenz zwischen den Pr?fungen des 1. und 2. Studienabschnittes konnte bisher nicht zufrieden stellend erkl?rt werden und bedarf weiterer Untersuchungen.

Unter Hinzurechnung der zwei Wiederholungspr?fungen, die jeweils ca. 50 % neue Fragen gegen?ber der Hauptklausur enthalten, werden pro Semester ca. 1000-1500 MC-Fragen eingesetzt.

Die Studierenden erhalten als R?ckmeldung ?ber ihre Pr?fungsleistung mit ihrem Zeugnis eine blockbezogene Auswertung ihres eigenen Ergebnisses im Verh?ltnis zum Mittelwert und der Standardabweichung aller Testteilnehmer.

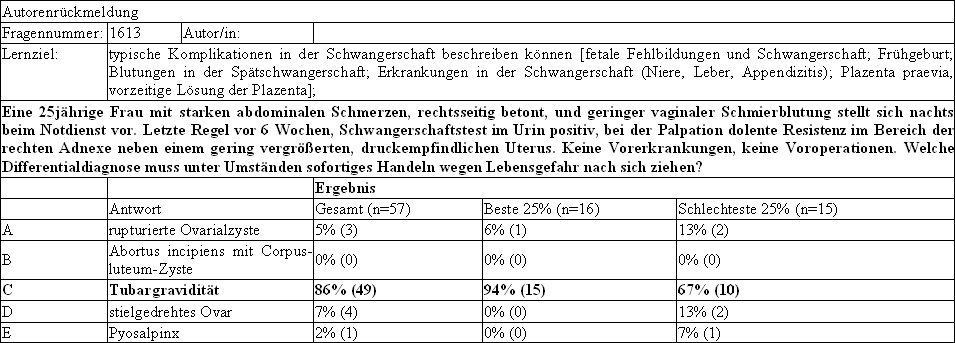

Die Autoren erhalten als R?ckmeldung ?ber das Antwortverhalten der Studierenden auf ihre Fragen eine fragenbezogene Auswertung, wie in der Abbildung 2 [Abb. 2] dargestellt. Sie zeigt, wie h?ufig jede Antwortalternative von den Studierenden gew?hlt wurde. Um zu sehen, ob eine Frage gut zwischen den leistungsstarken und den leistungsschw?cheren Studierenden unterscheidet, enth?lt die Autorenr?ckmeldung auch das Antwortverhalten der 25% Testbesten und 25% Testschlechtesten. Die R?ckmeldung an die Autoren ist ein wichtiges Instrument zur Curriculumsevaluation und -optimierung. Da fast alle Fragenautoren auch Dozenten im RSM sind, k?nnen sie der Autorenr?ckmeldung entnehmen, wie "erfolgreich" ihre Lehrveranstaltung war. Durch die R?ckkopplung der Pr?fungsergebnisse an die Blockplanung, k?nnen die Lernziele immer wieder auf Sinnhaftigkeit und Realisierbarkeit ?berpr?ft werden.

Der alleinige Einsatz von Einfachauswahl- und Zuordnungsaufgaben zur Pr?fung des kognitiven Wissens ist sicher nicht ausreichend und sollte um andere MC-Formate und Formate mit offenen Antworten erg?nzt werden. Das war im RSM bisher auf Grund des hohen Entwicklungsaufwands f?r hochwertige MC-Pr?fungen nur punktuell m?glich. Mit der zunehmenden Routine in der Durchf?hrung der MC-Pr?fungen werden jedoch jetzt Kapazit?ten frei, neue Formate zu erproben bzw. weiterzuentwickeln.

2. Objective Structured Clinical Examination (OSCE)

Das Pr?fungsformat Objective Structured Clinical Examination (OSCE) erm?glicht die strukturierte Erfassung der klinisch- praktischen Fertigkeiten der Studierenden [13], [14]. Da im RSM ein Schwerpunkt auf der Vermittlung der praktischen Fertigkeiten liegt, m?ssen demzufolge diese Fertigkeiten in den Semesterabschlusspr?fungen summativ erfasst werden. In Pilotprojekten wurde bereits vor Beginn des RSM die Umsetzbarkeit von OSCE Pr?fungen erprobt, weil diese Methode in der Fakult?t bislang unbekannt war. Das Verfahren ist international etabliert und wird unter anderem in den Staatspr?fungen in Kanada und den USA [15] eingesetzt und auch an vielen deutschsprachigen Fakult?ten (z.B. M?nster, Hamburg Heidelberg, M?nchen, Bern, Wien) werden OSCEs im Rahmen der fakult?tsinternen Leistungs?berpr?fungen durchgef?hrt.

Ein OSCE ist in der Regel fester Bestandteil der Semesterabschlusspr?fungen und bezieht sich auf alle Bl?cke des abgelaufenen Semesters. In einem Pr?fungsparcours werden Stationen mit unterschiedlichen Aufgabenstellungen aufgebaut, die alle Studierenden nacheinander durchlaufen m?ssen. Ma?geblich f?r die Gestaltung der Stationen sind die anwendungsbezogenen Lernziele der verschiedenen Bl?cke. Aus diesen werden von der Blockplanungsgruppe je zwei bis vier ausgew?hlt und dazu passende Aufgabenstellungen und Checklisten entwickelt. Die Im Unterschied zum MC-Fragen Review werden die Checklisten im kleinen Kreis von Fachexperten entwickelt, begutachtet und teilweise im Rahmen der Pr?ferschulungen erprobt.

In jeder Pr?fungsstation wird die Leistung der Studierenden von einem Pr?fer mit Hilfe einer detaillierten Checkliste erfasst und dokumentiert. Sie erhalten vorbereitende Informationsunterlagen und ein kurzes Training, um eine m?glichst konstante Bewertung zu gew?hrleisten. Es gibt Anamnese- und Untersuchungsstationen sowie Stationen in denen praktische Fertigkeiten, wie beispielsweise eine Venenpunktion am Modell, demonstriert werden m?ssen. Kombinierte Anamnese- und Untersuchungsaufgaben in einer Station sind ebenso m?glich. Im ersten und zweiten Fachsemester ist die Pr?fungszeit je Station mit 5 Minuten bemessen, in den h?heren Fachsemestern erh?ht sich die Zeit bis auf 10 Minuten je Station, weil die Aufgabenstellungen komplexer werden. Ein OSCE besteht derzeit aus maximal 10 Stationen. In ca. 70% davon werden Simulationspatienten eingesetzt und damit die M?glichkeit gegeben, die Arzt-Patienten-Kommunikation zu beobachten. Der Erwerb kommunikativer Kompetenzen ist ein wichtiger Ausbildungsschwerpunkt im RSM und im Rahmen des OSCE ist es m?glich, diese zu beurteilen. Auf der Basis von umfangreichen Studien zur Validierung eines Bewertungsinstrumentes werden in K?rze die kommunikativen Kompetenzen der Studierenden mit einem Global-Rating-Instrument in die Bewertung mit einbezogen [16].

Der OSCE ist bestanden, wenn der Mittelwert der erreichten Punktzahlen an den Stationen mindestens 60 % betr?gt. Alle Stationen gehen mit dem gleichen Gewicht in die Auswertung ein. Die Studierenden erhalten einen Auswertungsbogen, der ihre individuelle Leistung an jeder Station im Vergleich zum Mittelwert der Gesamtgruppe auff?hrt. Neben der Auswertung f?r die Studierenden werden die einzelnen Items der Checklisten der Stationen ausgewertet, um Hinweise auf M?ngel im Stationsdesign zu erhalten, aber auch um eine R?ckmeldung f?r die Veranstaltungsplanung des folgenden Jahrgangs zu gewinnen. Die Mitarbeiter des RSM unterst?tzten die Fakult?tsmitglieder bei der Gestaltung der Stationen und tragen die Verantwortung f?r den organisatorischen Ablauf.

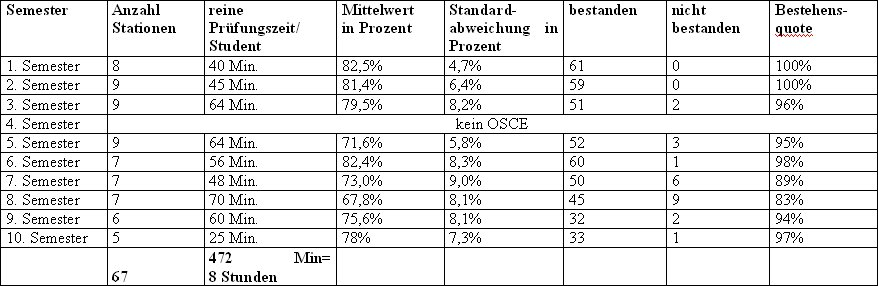

Tabelle 2 [Tab. 2] zeigt, dass die Studierenden im Verlauf ihres Studiums ca. 8 Stunden Pr?fungszeit durchlaufen. Diese Vielzahl an OSCE's kann nur mit Hilfe des Simulationspatientenprogramms und den r?umlichen Gegebenheiten des "Trainingszentrums f?r ?rztliche Fertigkeiten" (T?F) realisiert werden. In allen Anamnese-, Aufkl?rungs-/Beratungsstationen und den meisten Untersuchungsstationen werden Simulationspatienten bzw. Modelle eingesetzt. Die Durchf?hrung ist auch mit einem hohen personellen Aufwand f?r die Fakult?t verbunden, da alle Stationen mit Pr?fern besetzt werden. Im Wintersemester 2003/04 waren 78 Fakult?tsmitglieder als Pr?fer t?tig. Ein positiver Effekt dieser Aktivit?ten bei den Pr?fern ist die Reflektion ?ber Anspruch und Wirklichkeit im Hinblick auf die praktischen klinischen Fertigkeiten. Aufgrund der OSCE Ergebnisse wurden bereits Unterrichtskonzepte f?r die praktische ?bungen ?berarbeitet und ein "Leitfaden zu klinischen Untersuchungen und praktischen Fertigkeiten" [17] ver?ffentlicht.

Der interdisziplin?re Prozess der Stationsentwicklung und Pr?fungsdurchf?hrung zu einem Themenblock kann als eine Besonderheit des RSM angesehen werden, in der Literatur werden ?berwiegend fachspezifische OSCEs beschrieben [18], [19]. An der Planung und Umsetzung des OSCE f?r das 3. Semester sind beispielsweise acht verschiedene F?cher beteiligt, die sich im Planungsprozess mit den Anforderungen der anderen Fachgebiete auseinandersetzen m?ssen. Gleichzeitig muss kritisch angemerkt werden, dass aufgrund dieser Struktur ein wesentlicher Aspekt der Testkonstruktion des OSCE, die "Fallspezifit?t (case specificity)" nicht ausreichend gew?rdigt wird ([12]. Die verschiedenen Bl?cke eines Semesters m?ssten mit einer deutlich h?heren Anzahl von Stationen gepr?ft werden, um zuverl?ssige Aussagen ?ber die praktischen Fertigkeiten der Pr?flinge zu erhalten, dies ist aber aufgrund der Vorgaben der Pr?fungsordnung und der zur Verf?gung stehenden Ressourcen nicht realisierbar.

Deutlich sichtbar wird der enorme lernsteuernde Effekt dieser Pr?fungsmethode im T?F, wenn die Studierenden vor den Pr?fungen intensiv die umfangreichen ?bungsm?glichkeiten nutzen, um sich auf die OSCEs aber auch auf den sp?teren klinischen Alltag vorzubereiten. Ebenso wird der Tatsache Rechnung getragen, dass kommunikative Kompetenzen eine Voraussetzung f?r sp?ter erfolgreiche Arzt-Patientenkontakte sind und im Rahmen des Studiums unterrichtet und gepr?ft werden m?ssen.

Formative Pr?fungsangebote

In Erg?nzung zu den summativen Pr?fungsteilen, wurden den Studierenden einzelner Jahrg?nge auch formative Pr?fungen wie beispielsweise "strukturierte m?ndliche Pr?fungen", "Modified Essay Questions (MEQ)" und "computerbasierte Pr?fungen" angeboten. Auf diese Weise konnten neue oder ver?nderte Pr?fungsformate hinsichtlich ihrer Umsetzbarkeit und Anwendungsm?glichkeiten erprobt werden. Insgesamt wurden diese Projekte von den Studierenden positiv aufgenommen und auch einige Lehrende zeigten sich sehr engagiert. Die Erfahrungen und gesammelten Daten werden in weitere Pilotprojekte einflie?en, um auch bisher noch nicht gepr?fte Fertigkeiten und F?higkeiten der Studierenden zu erfassen und zeitnahe Feedbackmechanismen zu etablieren. Leider ist die regelm??ige Durchf?hrung formativer Pr?fungen in allen Semestern auf Grund begrenzter personeller Ressourcen bisher nicht m?glich.

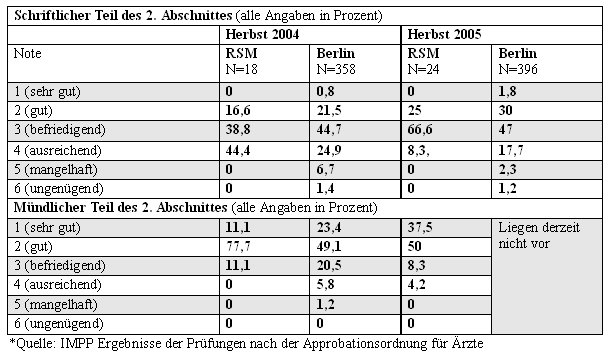

Erste Ergebnisse der Staatspr?fungen

Im Herbst 2004 haben sich die ersten Studierenden des Reformstudiengangs Medizin in Berlin zum 2. Teil der ?rztlichen Pr?fung (bisheriges Recht) angemeldet. Tabelle 3 [Tab. 3] zeigt die Notenverteilung des schriftlichen und m?ndlichen Teils im Vergleich zu allen Berliner Teilnehmern. Weitere statistische Untersuchungen zum Unterschied der beiden Gruppen sind aufgrund der geringen Fallzahlen in der RSM-Gruppe noch nicht m?glich. Im Herbst 2004 haben 28,5% der Studierenden des Reformstudiengangs Medizin diese Pr?fung innerhalb der Regelstudienzeit erfolgreich abgelegt. Dies entspricht der prozentualen Verteilung der Pr?fungserstteilnehmer und erfolgreichen Studierenden des Regelstudiengangs der Charit? in Berlin.

Die praktischen Fertigkeiten der Absolventen werden mit den jetzigen Staatspr?fungen nicht oder nur ungen?gend erfasst. Es ist derzeit deshalb leider nicht m?glich, mit Hilfe eines externen Evaluationsinstrumentes m?gliche signifikante Unterschiede hinsichtlich dieser Kompetenzen aufzuzeigen. Ergebnisse aus der Absolventenforschung werden zuk?nftig hier weitere Anhaltspunkte liefern k?nnen.

Zusammenfassung und Ausblick

Am Beginn des RSM stand die Vorstellung, baldm?glichst viele innovative Pr?fungsmethoden einzuf?hren, um der Lehr- und Lernvielfalt eine entsprechende Pr?fungsvielfalt gegen?berzustellen. Die Synchronisation von Curriculums- und Pr?fungsplanung ist Voraussetzung f?r eine erfolgreiche Curriculumsreform. Die Realit?t zeigt aber, dass die Planung der Inhalte und Lehrveranstaltungen h?ufig im Vordergrund steht und die Planung der Pr?fungen zuletzt stattfindet, gleichzeitig werden M?ngel an den Pr?fungen von den Studierenden viel deutlicher und vehementer kritisiert, als Anlaufschwierigkeiten in der Lehre. Aufgrund ?hnlicher Probleme im RSM wurde deutlich mehr Zeit und Arbeit als urspr?nglich vorgesehen, in die inhaltliche Feinabstimmung zwischen den Lernzielen und Pr?fungsinhalten investiert. Dieser Prozess hat eine hohe Transparenz und auch Akzeptanz der Pr?fungen des RSM zur Folge, die auch daran erkennbar wird, dass es bisher keine Klagen vor dem Verwaltungsgericht gegen Pr?fungsinhalte bzw. -teile gegeben hat. Sechs Studierende sind bislang aufgrund ihres Misserfolges in den Semesterabschlusspr?fungen zu einem recht fr?hen Studienzeitpunkte aus dem RSM ausgeschieden und haben ihr Studium im Regelstudiengang fortgef?hrt.

Der ?bergang von der bekannten F?cherstruktur zu den f?cher?bergreifenden Themenbl?cken ist immer noch eine der gro?en Herausforderungen im Curriculums des RSM. Die damit verbundenen organisatorischen Aspekte haben zur Implementierung zentraler Organisationsstrukturen f?r die Lehre und die Pr?fungen gef?hrt. Auf diese Weise k?nnen die Rahmenbedingungen und die inhaltlichen Fragestellungen koordiniert sowie Qualit?tsstandards f?r Lehre und Pr?fungen etabliert werden. Gerade die interdisziplin?re Begutachtung von Pr?fungsinhalten f?hrt zu einem Austausch von Fachwissen und der kritischen Auseinandersetzung mit den eigenen Ausbildungszielen. ?hnliche Strukturen sind f?r die Organisation der f?cher?bergreifenden Leistungsnachweise notwendig , daher wurden im RSM erprobte und inzwischen etablierte Prozesse bei der Pr?fungserstellung und Durchf?hrung auch f?r den Regelstudiengang an der Charit? ?bernommen. Mittlerweile gibt es den Assessment-Bereich, in dem alle pr?fungsbezogenen Aufgaben, unabh?ngig vom RSM oder Regelstudiengang, bearbeitet werden.

Der Entwicklungsaufwand der einzelnen Pr?fungsmethoden und die Notwendigkeit, neue Strukturen zu etablieren, wurden insgesamt untersch?tzt und erst jetzt, nachdem f?r MCQ und OSCE effiziente Abl?ufe und Ressourcen vorhanden sind, r?cken andere Formate ins Blickfeld. Perspektivisch werden eine gr??ere Formatvielfalt sowie zus?tzliche formative Angebote f?r Studierende angestrebt. Es gilt insbesondere die Aspekte des Curriculums wie beispielsweise "klinische Entscheidungsf?higkeit" oder die F?higkeit zur Selbsteinsch?tzung, die noch gar nicht mit Pr?fungen erfasst werden, durch die Einf?hrung angepasster Methoden aufzuwerten, denn gelernt wird was gepr?ft wird.

Anmerkung

Der "Reformstudiengang Medizin" wird durch die Bund-L?nder-Kommission f?r Bildungsplanung und Forschungsf?rderung gef?rdert und im Rahmen von wissenschaftlichen Projekten durch eine Reihe von Institutionen und F?rderern unterst?tzt (unter anderem: Robert Bosch Stiftung, VolkswagenStiftung, Carl Gustav Carus Stiftung, Deutsche ?rzte Finanz)

Danksagung

Wir danken folgenden ehemaligen und noch aktiven Mitarbeitern des Reformstudienganges f?r ihre Mitarbeit bei der Entwicklung, Durchf?hrung und Auswertung der Pr?fungen: Heiko Brandes, Claudia Hahn, Mark Helle, Michel Knigge, Simone Scheffer und Andreas Stein. Wir danken allen Kolleginnen und Kollegen, die an den Pr?fungen beteiligt sind und den Studierenden des RSM f?r ihre konstruktive Mitarbeit.

Literatur

[1] Burger W, Froemmel C. Der Berliner Reformstudiengang Medizin, Zielsetzung und erste Erfahrungen. Bundesgesundheitsbl. 2002;(45):152-158.[2] Humboldt-Universit?t zu Berlin. Amtliches Mitteilungsblatt vom 26.07.1999. Studienordnung und Pr?fungsordnung f?r den Reformstudiengang Medizin. Berlin: Humboldt-Universit?t; 1999:16.

[3] Lowry S. Medical education: Assessment of students. BMJ. 1993;(306):51-54.

[4] Des Marchais JE, Vu NV. Developing and evaluating the student assessment system in the preclinical problem-based curriculum at Sherbrooke. Acad Med. 1996 ;71(3):274-283.

[5] Case SM, Swanson DB. Constructing written test questions for the basic and clinical sciences. 2nd ed. Philadelphia: NBME; 1998.

[6] Haladyna TH. Developing and validating Multiple-Choice test items. 2nd ed. Mahwah, New Jersey: Lawrence Erlbaum Ass; 1999.

[7] Schuwirth LW, van der Vleuten CP. ABC of learning and teaching in medicine: Written assessment. BMJ. 2003;326(7390):643-645.

[8] Newble DI, Swanson DB. Psychometric characteristics of the objective structured clinical examination. Med Educ. 1988;22:325-334.

[9] Downing SM. Validity: on the meaningful interpretation of assessment data. Med Educ. 2003;37(9):830-837.

[10] Krebs R. Anleitung zur Erstellung von MC-Fragen und MC-Pr?fungen f?r die ?rztliche Ausbildung. Bern: IML/AAE; 2004.

[11] Kuder GF, Richardson MW. The theory of the estimation of test reliability. Psychometrika. 1937;2:151-160.

[12] Downing S. Reliability: on the reproducibility of assessment data. Med Educ. 2004; 38(9):1006-1012.

[13] Harden RM, Gleeson FA. Assessment of medical competence using an objective structured clinical examination (OSCE). Med Educ. 1979;13(1):41-54.

[14] Newble D. Techniques for measuring clinical competence: objective structured clinical examinations. Med Educ. 2004;38(2):199-203.

[15] Papadakis MA. The Step 2 clinical-skills examination. N Engl J Med. 2004; 350(17):1703-1705.

[16] Scheffer S, Muehlinghaus I, Froemmel A, Ortwein H, Georg W, Burger W. Assessing Students' Communication Skills: Results of the validation of a Global Rating. Edingburgh: AMEE; 2004. Zug?nglich unter: http://www.amee.org/conf2004/AMEE2004_Abstracts.pdf .

[17] Dashti H, K?chenmeister J, Georg W, Schnabel K. Leitfaden zu klinischen Untersuchungen und praktischen Fertigkeiten. Reformstudiengang Medizin. Berlin: Charit?-Universit?tsmedizin Berlin; 2002.

[18] Hodges B, Hanson M, McNaughton N, Regehr G; University of Toronto Psychiatric Skills Assessment Project. Creating, monitoring, and improving psychiatry OSCE: a guide for faculty. Acad Psychiatry. 2002;26(3):134-161.

[19] Carraccio C, Englander R. The objective structured clinical examination: a step in the direction of competency-based evaluation. Arch Pediatr Adolesc Med. 2000;154(7):736-741.