[Characteristics of learning, learning strategies and acceptance of computer-based learning (CBL) ]

Amina Katharina Hahne 1Holger Krause 2

Holger Pfaff 3

Stefan Herzig 4

1 Universit?t zu K?ln, Institut f?r Pharmakologie, K?ln, Deutschland

2 Universit?t Bielefeld, Fakult?t f?r Gesundheitswissenschaften, Bielefeld, Deutschland

3 Universit?t zu K?ln, Institut f?r Arbeitsmedizin, Sozialmedizin und Sozialhygiene, K?ln, Deutschland

4 Universit?t zu K?ln, Institut f?r Pharmakologie und Studiendekanat der Medizinischen Fakult?t, K?ln, Deutschland

Abstract

Medical education faces ever-increasing demands: larger amounts of knowledge have to be taught to larger student numbers in a time- and cost-effective manner. Therefore, new media have gained respect and raised high expectations, due to their obvious advantages. Hence, the aim of this study was to develop a standardised instrument, which allows for valid assessment of parameters relevant for the evaluation of computer-based learning (CBL). The main emphasis was placed on the overall acceptance of CBL as well as on some pertinent characteristics of individual learners. We took this as an example to systematically describe the construction of a questionnaire, focussing on the methodological and scientific aspects of this multi-step process. A first version, which was constructed on theoretical grounds, was analysed and revised using standard pretest conditions (n=18). The second revision was done using a cognitive pretest-technique, called "Think-Aloud" (n=10). After this qualitative evaluation, the questionnaire was offered to a representative sample of n=328 third-year medical students. In this quantitative analysis, 12 valid psychometric scales could be confirmed by factor analysis. Reliability analysis yielded satisfying values (a=0.71-0.91) in 10 cases: 5 scales on learner properties, 2 scales on learning strategies, one scale on the attitude towards CBL and 2 scales on expectations regarding CBL. For 2 scales (a=0.66-0.67), we identified a need for further revision in order to improve accuracy. The described questionnaire provides a valid, quantitative means to assess relevant parameters to evaluate CBL interventions.

Keywords

computer-based learning, evaluation, questionnaire, quantitative methods, learner characteristics

Einleitung

Methoden des Lehrens und des Lernens sollen akademische Inhalte so vermitteln, dass weniger das Auswendiglernen von Faktenwissen, sondern eine verst?ndnis- und anwendungsorientierte Wissensvernetzung im Vordergrund steht. Andererseits sollen sie den Studierenden darin unterst?tzen, seine Rolle als aktiven und selbstst?ndig Lernenden zu begreifen und im Lernprozess umzusetzen. Dazu sind Lernkompetenzen und -m?glichkeiten notwendig, die sowohl Lernende als auch Lehrverantwortliche vor neue Aufgaben stellen: innovative Lehrmethoden sollen den Lernenden ‚dort abholen‚ wo er steht'. Die Wirksamkeit neuer Lernmethoden wird jedoch entscheidend davon abh?ngen, inwiefern sie imstande sind, die Masse der Studierenden zu erreichen. Die ausschlie?liche F?rderung einer spezifischen Gruppe, z.B. besonders talentierter Studierender, kann nicht Ziel aufwendiger Konzeptions- und Reformierungsarbeit sein. Angesichts erheblicher Varianz im Lernverhalten und divergierende Bed?rfnisse der Studentenschaft muss die Evaluation neuer Lehrmethoden diese Vielf?ltigkeit potenzieller Einflussgr??en in Rechnung stellen.

Der Untersuchung des computerbasierten Lernens (CBL) als neue Lehr- und Lernmethode kommt gegenw?rtig eine bedeutsame Stellung zu. Ohne auf die verschiedenen technologischen Umsetzungen von CBL-Anwendungen hier n?her eingehen zu k?nnen, sollen einige Vorteile genannt werden: die Erweiterung der Wissensvermittlung um multimediale Darbietungsformen er?ffnet der breiten Studentenschaft eine raum- und zeitunabh?ngige, tiefergehende und praxisnahe Wissensaneignung, die zielgerichtete Nutzung eines umfassenden Informationsinstrumentes verspricht eine h?here Effektivit?t der Lernprozesse und nicht zuletzt die interaktive Aufbereitung forciert selbstgesteuertes Lernen. Dass sich derlei erw?nschte Wirkungen jedoch nicht per se einstellen, zeigen zahlreiche Forschungsergebnisse, deren Schwerpunkte allerdings ?berwiegend in einer technikorientierten und mediendidaktischen Betrachtung liegen. Fokussiert wird das gestalterische und didaktische Design der Produkte [1]. Eine Optimierung der Produktqualit?t ist zwar w?nschenswert, doch weder garantiert sie allein gelingende Implementierungsprozesse noch liefert dieser Ansatz Aufschluss ?ber deren weitere erfolgsrelevante Faktoren [11]. Voraussetzungen seitens der Lernenden um das technologische Potenzial im intendierten Sinne auszusch?pfen, r?cken h?ufig in den Hintergrund [13]. Ihr m?glicherweise zentraler Erkl?rungswert f?r das effektive Gelingen der Mensch-Computer-Interaktion im Lehr- und Lernkontext erf?hrt jedoch zunehmend Betonung [24], [9], [7] und bildete den Ausgangspunkt f?r die hier dargestellten Forschungsbem?hungen.

Im Rahmen der Evaluation eines computerbasierten Lernsystems f?r die theoretische und klinische Kardiologie, welches sich vorrangig an Studenten der Humanmedizin richtet, galt es, ein Messinstrument zu konzipieren, das Aussagen ?ber die Akzeptanz dieser Innovation sowie deren Determinanten zul?sst. Dabei wurde das Ziel verfolgt, 1. allgemeine Merkmale des individuellen Lernverhaltens, wie Lernmotivation, und 2. gegenstandsspezifische Merkmale, wie Einstellung zu CBL, zu ber?cksichtigen. Diese ?berlegungen erforderten die Entwicklung eines Fragebogens, der die zahlreichen relevanten Konstrukte bei vertretbarem Zeitaufwand ermittelt. Die folgenden Ausf?hrungen sollen in erster Linie das methodische Vorgehen einer solchen Konstruktionsarbeit, beispielhaft an dem hier verfolgten Forschungsanliegen, offen legen.

Die Fragebogenkonstruktion

Die Qualit?t einer Befragung h?ngt von der Reliabilit?t und Validit?t der genutzten Messinstrumente ab. Ein-Item-Messinstrumente, die einen Sachverhalt ?ber nur eine Frage erheben, sind nicht nur messfehleranf?llig, sondern insbesondere dem Facettenreichtum komplexer Sachverhalte nicht angemessen. F?r die Messung solcher latenter Gr??en, wie z.B. Einstellungen, bieten psychometrische Skalen, die aus mehreren Items bestehen und deren G?tekennwerte Aussagen ?ber die Messqualit?t zulassen, eine geeignete Methode. F?r die Messung von Faktoren des Lernverhaltens und im Hinblick auf die Evaluation von CBL galt es daher, Instrumente zu entwickeln, die den Qualit?tsstandards der empirischen Sozialforschung gen?gen w?rden.

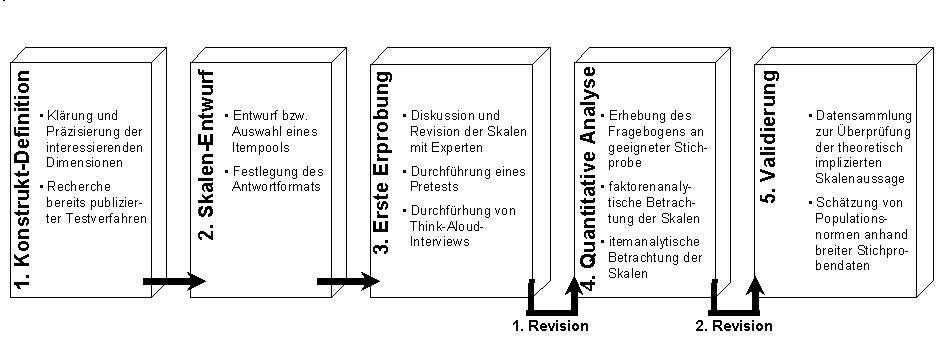

Die Konstruktion eines psychometrischen Fragebogens erfordert immer einen mehr-schrittigen Prozess, in dem sich Konstruktions-, Test- und Revisionsphasen abl?sen. Abbildung 1 [Abb. 1] veranschaulicht dieses Vorgehen, wobei die klein gedruckten Konkretisierungen dem hier verfolgten Ansatz entsprechen, oftmals jedoch abweichenden Inhalts sein k?nnen. Die Erl?uterung der Schritte 1-5 sind Gegenstand der folgenden Abschnitte.

Schritt 1: Konstrukt-Definition

Die Problematik von Evaluationen im Bildungsbereich ist nicht zuletzt auf die Vielzahl potenzieller Einflussfaktoren auf das Lernverhalten zur?ckzuf?hren. Angesichts dessen fordert Schott [20] eine ganzheitliche Sichtweise, um die G?te von Bildungsma?nahmen festzustellen. Bereiche beeinflussender Faktoren k?nnen sein:

1. Eigenschaften der Lernenden,

2. Eigenschaften des Lehrstoffes,

3. Eigenschaften der Lehrmethoden,

4. Eigenschaften der Medien,

5. Eigenschaften des Umfeldes, in dem die Ma?nahme stattfindet.

Der thematische Fokus des vorliegenden Ansatzes lag auf den Eigenschaften des Lernenden. Ziel war es, die Bedeutung des individuellen Lernverhaltens im Kontext einer neuen Lehr- und Lernmethode zu ermitteln und f?r Aussagen ?ber abh?ngige Variablen, wie Akzeptanz oder Lernerfolg, ber?cksichtigen zu k?nnen.

Vor der Erstellung eines Fragebogens sollte ?berpr?ft werden, ob geeignete Instrumente bereits vorliegen [5], was hier teilweise zutraf. Neben der testmethodischen Qualit?t und der zielgruppennahen Ausrichtung des Fragebogens stellte eine praktikable K?rze ein wichtiges Zielkriterium dar. Existierende Skalen wurden daher nur gek?rzt ?bernommen, und es kam zu zahlreichen Neu- und Umformulierungen von Items, um eine optimale Abstimmung auf den vorliegenden Kontext zu erreichen. Bei der Entwicklung neuer Items wurden die klassischen Kriterien zur Itemerstellung ber?cksichtigt [19]. Im Folgenden wird eine n?here Beschreibung der interessierenden Konstrukte und ihre Einordnung in das Forschungsfeld vorgenommen.

Allgemeine Merkmale des Lernverhaltens: Lerneigenschaften und Lernstrategien

Jeder Lernende weist ein individuelles Netzwerk von kognitiven, motivationalen und emotionalen Merkmalen auf, das als komplexes Geflecht von Einflussfaktoren die Qualit?t des Lernprozesses beeinflusst. Die Methode des selbstgesteuerten Lernens, bei der zwar Lernziele vorgegeben werden, die Auswahl und Steuerung jedoch dem Lernenden selbst ?berlassen wird, bietet m?glicherweise eine L?sung der unerf?llbaren Aufgabe einer optimalen Passung von „Lernzielen, Inhalten und Medien einerseits und individuellen Lernervariablen andererseits" ([10], S.298). Inwiefern es zu einer aktiven Selbststeuerung des Lernprozesses kommt, d?rfte sich folglich aus der dynamischen Interaktion der Instanzen - Lernangebot und Individuum - ergeben. Bei der Konstruktauswahl wurde versucht, verhaltensrelevante Charakteristika von Lernprozessen aufzugreifen, die mit der Kompetenz des selbstgesteuerten Lernens verkn?pft sind. Als zentrale Mediatoren motivationaler Einfl?sse auf die Lernleistung [16] werden des Weiteren Lernstrategien ber?cksichtigt. Diese werden als konkrete Verhaltensweisen sowie Kognitionen verstanden, die Lernende intentional und situationsgebunden [28] zur Informationsverarbeitung einsetzen.

Spezifische Merkmale der Studierenden hinsichtlich des Evaluationsgegenstands

Hierunter werden Konstrukte gefasst, die den zu evaluierenden Gegenstand, CBL, und darauf bezogene Kompetenzen und Erwartungen betreffen. Von zentralem Rang ist die Einstellung zu CBL, da sie die mentale Anstrengung, die in einen Lernprozess investiert wird, und somit dessen Effektivit?t mitbestimmt [26]. Um Erwartungshaltungen an qualitative Gestaltungsoptionen von CBL zu ermitteln, wurden relevante Eigenschaftskomplexe von CBL auf der Basis einer umfassenden Literaturrecherche herausgearbeitet. Qualit?tsaspekte, die mit Blick auf das hier zu evaluierende Endprodukt ma?geblich erschienen, haben sodann Eingang in Itemaussagen gefunden.

Schritt 2: Skalen-Entwurf

Auf der Grundlage vorhandener Messinstrumente und eigener Neuentwicklungen wurde eine erste Fragebogen-Version entwickelt. Teilweise konnten Originalitems aus existierenden Skalen ?bernommen werden. Von der ?bernahme vollst?ndiger Skalen wurde aufgrund inhaltlicher Abweichungen zum hier verfolgten Fokus und der zeitlichen Handhabbarkeit des Fragebogens abgesehen. Bei Konstrukten, f?r die keine Orientierung an bestehenden Fragebogeninventaren m?glich war, erfolgte die Operationalisierung in Anlehnung an ihre theoretische Besprechung in der Literatur. Erwartungsgem?? fanden sich f?r die Lerneigenschaften und -strategien empirisch gut belegte Quellen, die f?r die Konstruktionsarbeit genutzt werden konnten [27], [21], [18], [22]. F?r die Messung der Einstellung und Erwartungen an CBL waren Neukonstruktionen erforderlich. Auf diese Weise resultierte eine Fragebogen-Rohversion mit einem Pool von insgesamt 126 Items. Das Antwortformat entsprach f?r alle Skalenitems einer f?nfstufigen Likert-Skala. Die Antwortschl?ssel erm?glichten eine Zustimmungsabstufung (1=„trifft nicht zu" bis 5=„trifft voll zu") oder eine H?ufigkeitsabstufung (1=„sehr selten" bis 5=„sehr oft").

Schritt 3: Erste Erprobung

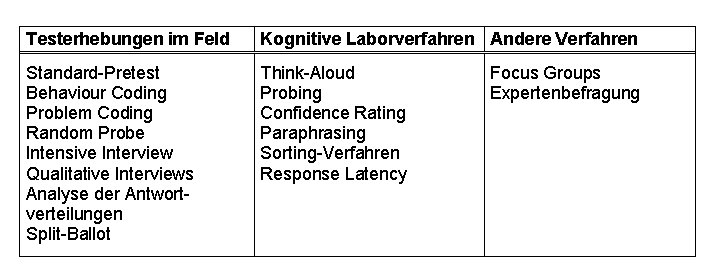

Auch bei Ber?cksichtigung der methodologischen Literatur (u.a. [14]) ergibt sich regelhaft die Notwendigkeit einer Erprobung des Instrumentes. Hierzu stehen eine Reihe von Verfahren zur Verf?gung (Tabelle 1 [Tab. 1]), die empfehlungskonform [8] kombiniert zum Einsatz kamen. Ein Standard-Pretest wurde durchgef?hrt, der zur Ermittlung ‚grober' Fehler und Auff?lligkeiten f?hren sollte. Anschlie?ende Think-Aloud-Interviews f?hrten zur endg?ltigen Fragebogenform. Parallel zur Fragebogenevaluation wurden au?erdem Experten zu Rate gezogen.

Der Standard-Pretest

Methode: Bei einem Pretest handelt es sich um eine explorative Voruntersuchung, die dazu dient, inhaltliche und untersuchungstechnische Fragen im Zusammenhang mit dem Erhebungsinstrument zu beantworten. Neben der Eignung des Untersuchungsger?ts (z.B. ist die Handhabung selbsterkl?rend?) wird der Inhalt (z.B. ist die Itemformulierung verst?ndlich?) sowie ein reibungsloser Ablauf (z.B. treten Erm?dungserscheinungen auf?) ?berpr?ft. Trotz der Verbreitung des Pretest-Verfahrens in der sozialwissenschaftlichen Forschung existieren keine standardisierten Regeln zu seiner Durchf?hrung. Aus der Literatur lassen sich ?bereinstimmungen hinsichtlich seines Grundger?stes skizzieren [17], [5]:

▪ In einer einmaligen Erhebung absolvieren Probanden einen Untersuchungsdurchgang mit dem zu pr?fenden Erhebungsinstrumentes.

▪ Die Probanden sind f?r die Stichprobe der Hauptuntersuchung repr?sentativ.

▪ Der Pretest findet unter ?hnlichen Bedingungen wie die in der Hauptstudie statt.

▪ Ein Interviewer registriert dabei - meist passiv - alle Auff?lligkeiten, Probleme und Vorkommnisse, die im Laufe der Erhebungsdurchf?hrung auftreten.

Als empfohlene Fallzahl einer Pretestung finden Pr?fer & Rexroth [17] zwischen 10 und 200 Personen. Des Weiteren variiert die Verfahrensanwendung bez?glich des Ausbildungsstandes der Interviewer sowie des Informationsstandes der Befragten ?ber den Zweck der Erhebung. Die Vorz?ge eines Pretest sind offenkundig (schnelle Durchf?hrung, geringer organisatorischer Aufwand, niedrige Kosten).

Durchf?hrung: Die Durchf?hrung des Pretests fand in zwei Gruppen (n=10 und n=8, Geschlechterverh?ltnis von weiblich zu m?nnlich lag bei 8:10) statt, die repr?sentativ f?r die Zielstichprobe waren. Die Leitung ?bernahm die mit dem Projekt betraute Forschungs-Assistentin. Die Probanden wurden ?ber den Erprobungscharakter der Erhebung aufgekl?rt und um freiwillige, unentgeltliche Teilnahme gebeten. Da das Forschungsziel in der Optimierung von Studienbedingungen bestand, war die Kooperationsbereitschaft der Studierenden hoch. Sie wurden instruiert, Unklarheiten im Zusammenhang mit dem Fragebogen durch Markierungen festzuhalten. Des Weiteren wurde mitgeteilt, dass nach Ausf?llen des Fragebogens Gelegenheit f?r Anmerkungen gegeben w?rde. Im ?brigen wurde wie in der Hauptuntersuchung verfahren, um ‚Ernstfall'-Bedingungen zu schaffen.

Ergebnisse: Es zeigte sich, dass die Bearbeitungszeit von durchschnittlich 20 Minuten auf keine negativen Reaktionen (Erm?dungserscheinungen oder Akzeptanzprobleme) bei den Studenten stie?. Die meisten Verst?ndnisschwierigkeiten zeigten Items, durch die Merkmale von CBL abgedeckt wurden. Diese reichten von Unkenntnis spezifischer Vokabeln (z.B. „Simulation") bis hin zu widerspr?chlichen Auffassungen, was mit bestimmten Programmeigenschaften gemeint sei (z.B. „Programm gibt einen Lernwegvorschlag"). Das Vorwissen der Studenten in Bezug auf diese Lernmethode erwies sich als heterogen. Um im Weiteren ein einheitliches Verst?ndnis zu gew?hrleisten, kam es hier zu Erg?nzungen. Im Hinblick auf die Skalen zur Erfassung von Pers?nlichkeitsmerkmalen ergaben sich kaum Auff?lligkeiten. Lediglich die negative Formulierung einzelner Items zur Balancierung negativer und positiver Aussagen f?hrte in einigen F?llen zu Irritationen. Diese Items wurden ?berarbeitet, wobei hier zugunsten einer besseren Verst?ndlichkeit und auf Kosten der Ausgeglichenheit der Polung entschieden wurde [3]. F?r das Layout und die Handhabung des Fragebogens ergaben sich keine Ver?nderungen. Wenn auch die Vorz?ge eines Pretest unbestritten sind und er als solches unersetzlich ist, muss doch auf die ‚grobe' Information hingewiesen werden, die er erzeugt. So liefert er zwar Informationen ?ber die Funktionst?chtigkeit des Instrumentes (verst?ndliche Handhabung, Erhebungsdauer), tiefergehende Einblicke in die korrekte Interpretation der Items gew?hrt er jedoch nicht. Auch eine richtig beantwortete Frage kann das Ergebnis einer falsch verstandenen Inhaltsauffassung sein. Dieser Problematik begegnet das im Folgenden erl?uterte Verfahren.

Die Think-Aloud-Interviews

Methode: Die Methode der Think-Aloud-Interviews wird zu den kognitiven Laborverfahren gez?hlt, die aus der Zusammenarbeit von Kognitionspsychologen und Umfrageforschern hervorgingen. Gemeinsam ist diesen Verfahren, dass sie ?ber die Erfassung kognitiver Prozesse R?ckschl?sse auf das tats?chliche Zustandekommen einer Antwort zulassen. Diese Technik der Qualit?tssicherung beinhaltet prim?r eine Minimierung der Messfehler durch Optimierung der Fragebogenverst?ndlichkeit. Die Think-Aloud-Technik erm?glicht dabei eine zielgruppennahe Validit?tspr?fung. Der Proband wird gebeten, alle Gedanken, die ihn zu einer Antwort f?hren, laut auszusprechen. Ziel ist es, ?ber diese ?u?erungen Aufschluss ?ber die Iteminterpretation zu erhalten. ?hnlich wie beim Pretest gilt der Mangel an pr?zisen Regeln auch f?r diese Methode. Ungekl?rt bleibt z.B., nach wie vielen Fehlernennungen eine ?nderung im Fragebogen erfolgen sollte und ob jede ge?nderte Version erneut getestet werden muss [12]. Unterschieden wird zwischen der ‚Concurrent-Think-Aloud-Methode' (Lautes Denken w?hrend Antwortvergabe) und der ‚Retrospektive-Think-Aloud-Methode' (Lautes Denken nach Antwortvergabe). Erstere erwies sich in zahlreichen Studien als erfolgreich [4] und wurde auch hier angewandt.

Durchf?hrung: Insgesamt wurden 10 Think-Aloud-Interviews mit freiwilligen Teilnehmern, die repr?sentativ f?r die Zielpopulation waren (Geschlechterverh?ltnis von weiblich zu m?nnlich lag bei 5:5), durchgef?hrt, wobei jedes Interview durchschnittlich 1,5 Stunden dauerte. Um einen iterativen Verbesserungsprozess des Fragebogens abzubilden, wurde nach den ersten 5 Durchg?ngen eine ?berarbeitung des Fragebogens vorgenommen. ?nderungen wurden umgesetzt, wenn diesbez?glich Auff?lligkeiten bei mindestens 2 Personen aufgetreten waren. Zun?chst wurde der Proband ?ber den Zweck der Erhebung und ?ber die Methode aufgekl?rt. Die Instruktionen bestanden daraufhin in der Aufforderung, den Fragebogen wie ?blich auszuf?llen, gleichzeitig jedoch laut zu denken, d.h. die ?berlegungen zwischen Frage und Antwortvergabe zu artikulieren. Die Interviewerin hatte w?hrend des gesamten Prozesses Einblick in den Fragebogen, so dass die ?u?erungen der Probanden mit ihren Antworten verglichen werden konnten. Trotz der L?nge der Interviews blieb die Bereitschaft zur Mitarbeit bis zum Ende hoch, da das Verfahren mit Interesse aufgenommen wurde. Es zeigten sich keine Erm?dungserscheinungen.

Ergebnisse: Zum einen wurde eine Erg?nzung im Einleitungstext des Fragebogens vorgenommen. Bei Erw?hnung von CBL ?u?erten mehrere Probanden spontan Unklarheiten hinsichtlich einer Lehrplan?nderung, des Nutzungsortes und der Nutzungsverpflichtung (z.B. „Wird die Veranstaltung durch CBL ersetzt?"). Im n?chsten Durchgang tauchten diesbez?glich keine Missverst?ndnisse mehr auf. Die Items, die sich auf Merkmale computerbasierter Lernsysteme beziehen, erzeugten immer noch Vokabelunsicherheiten. So wurde z.B. das Wort ‚Interaktivit?t' nun in der zweiten Fragebogenfassung in einer Fu?note erl?utert. Die Pers?nlichkeitsskala „Selbstwirksamkeitserwartungen im Fach" wurde nahezu g?nzlich neu formuliert, da die Items als zu ?hnlich und uneindeutig empfunden wurden. Des Weiteren wurden Instruktionen im Fragebogen ge?ndert, da das Vorgehen beim Ausf?llen nicht unmittelbar verst?ndlich war. Bei vier Fragen wurde der Antwortschl?ssel umgedreht. Die Probanden waren an die Reihenfolge von 1 „trifft nicht zu" bis 5 „trifft zu" gew?hnt. Bei vier ja/nein-Fragen stand das ja-K?stchen an erster Stelle und das nein-K?stchen an zweiter. Hier zeigte sich ein Z?gern („Ach so, jetzt ist das anders herum..."), da bei einer ja-Antwort automatisch zur rechten Seite der Antwortm?glichkeiten tendiert wurde, was in einigen F?llen zu fehlerhaften Antworten f?hrte.

Schritt 4: Quantitative Analyse

Methode

Die statistische Absicherung des Erhebungsinstrumentes erfolgte an einer f?r die Zielpopulation repr?sentativen Stichprobe von 328 Studierenden. Die Studenten der Humanmedizin rekrutierten sich aus den Universit?ten K?ln (n=123), Dresden (n=100) und Hamburg (n=105). Das durchschnittliche Alter betrug 23,87 Jahre (SD=3,11). Das Geschlechterverh?ltnis betrug 195 (60% weiblich) zu 130 (40% m?nnlich). Die Befragung fand unter den Teilnehmern der Veranstaltung ‚Allgemeine Pharmakologie' statt, die Mehrheit der Befragten (66%) befand sich zu diesem Zeitpunkt im 6. Fachsemester. Es wurde die jeweils letzte Veranstaltungssitzung des Sommersemesters 2002 als Erhebungszeitpunkt gew?hlt. Um eine m?glichst einheitliche Ausgangsbasis an allen Erhebungsstandorten zu schaffen, hatten die Dozenten zuvor standardisierte Instruktionen erhalten, um die Studierenden zur Teilnahme zu bewegen. Die ausgef?llten Frageb?gen wurden anschlie?end von den Verantwortlichen vor Ort entgegengenommen, was einen 100%igen R?cklauf sicherte.

Ergebnisse

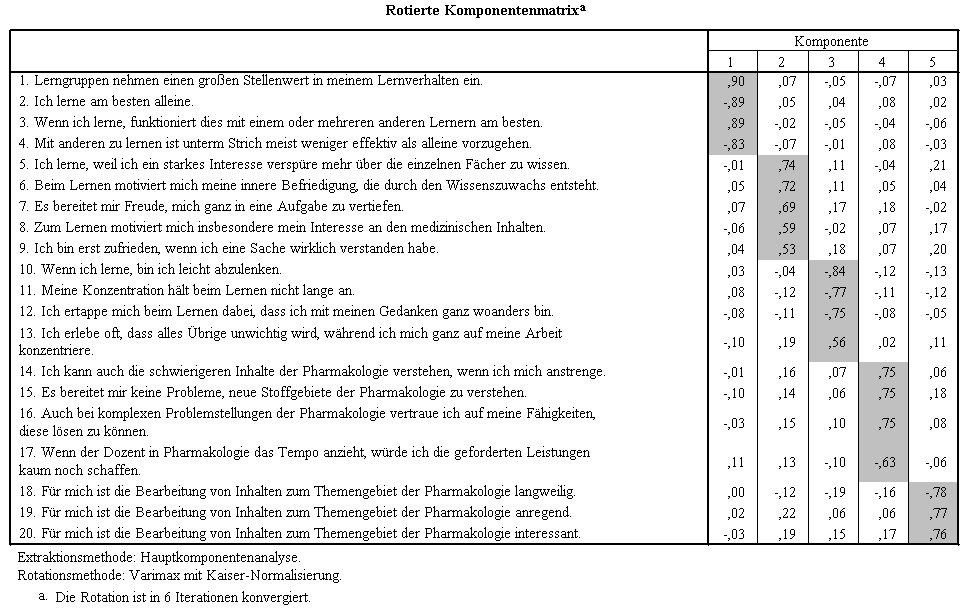

Faktorenanalyse: Als faktorenanalytische Methode wurde die Hauptkomponenten-Analyse gew?hlt. Die Faktorenextraktion erfolgte unter Anwendung des Scree-Kriteriums, nach dem Faktoren mit einem kontinuierlich hohen Eigenwerte-Verlauf solange als bedeutsam erachtet werden bis ihre Varianzaufkl?rung pl?tzlich einbricht (‚Knick im Eigenwertediagramm'). Das orthogonale Rotations-Verfahren bestand in der VARIMAX-Methode. Nach jeder Faktorenanalyse wurden Items, die den itemanalytischen Anforderungen nicht entsprachen, solange entfernt, bis eine zufrieden stellende Faktorenstruktur erreicht war. Folgende Kriterien wurden f?r die Zugeh?rigkeit eines Items zu einem Faktor festgelegt: 1. Die Ladung auf dem Hauptfaktor betr?gt >,50, 2. Die Differenz zwischen Hauptfaktorladung und Fremdfaktorladung ist >,15, und 3. Es herrscht ‚face validity': die Items passen inhaltlich zum theoretischen Konstrukt. Items, die sich inhaltlich auf ?hnliche Sachverhalte beziehen, gingen gleichzeitig in einen Analyseschritt ein. Diese ‚gegenseitige Testung' konstruktnaher Faktoren erzeugt qualitativ hochwertigere Skalen als die einfache Faktorenanalyse, bei der die Konstrukte getrennt voneinander betrachtet werden. F?r den Bereich der allgemeinen Merkmale wurden die Lernstrategien zusammen betrachtet, da hier jeweils konkrete Umgehensweisen mit Lernmaterialien thematisiert werden. Des weiteren wurden die ?brigen Lerneigenschaften konstrukt?bergreifend analysiert, da alle ?berdauernde, abstraktere Facetten und Tendenzen des Lernprozesses abbilden. Im Bereich der spezifischen Lernermerkmale thematisierten alle Items CBL und gingen daher gemeinsam in eine Analyse ein.

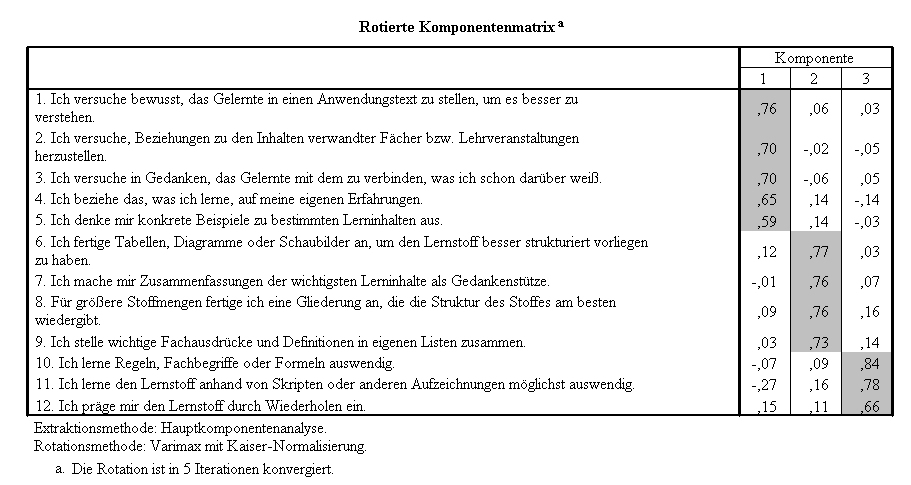

Lerneigenschaften und Lernstrategien: Die faktorenanalytische Betrachtung des Item-Komplexes zu den Lerneigenschaften erbrachte f?nf distinkte Skalen. In fast allen F?llen ergab sich eine ?bereinstimmung der a-priori konzipierten und empirisch gewonnenen Skalen (Abbildung 2 [Abb. 2]). Die Komponenten 1-4 konnten in vollem Umfang faktorenanalytisch best?tigt werden. Die Komponente 5 war zun?chst mit 5 Items operationalisiert worden, von denen 2 Items nicht den itemanalytischen Anforderungen gen?gten. Nach Eliminierung dieser Items konnte eine zufrieden stellende Faktorenstruktur erzielt werden ohne dabei die Inhaltsvalidit?t des Konstruktes zu gef?hrden. Ein Konstrukt, „Selbstst?ndigkeit beim Lernen", musste aufgrund ungen?gender Itemkennwerte ausgeschlossen werden. Hierbei handelte es sich um eine gek?rzte Version einer Skala des Leistungsmotivationsinventars (LMI) [21]. Da dieses Konstrukt f?r die sp?tere Evaluation von CBL aus wissenschaftlichem Interesse unverzichtbar ist, wird es in der revidierten Fragebogenfassung vollst?ndig gem?? dem LMI ?bernommen. Die faktorenanalytische Betrachtung der Lernstrategie-Items erbrachte 3 distinkte Skalen (Abbildung 3 [Abb. 3]), die angenommen werden konnten. Mehrere Items mussten aufgrund unbefriedigender G?tekennwerte eliminiert werden. Ein Konstrukt, „Metakognitive Lernstrategien", konnte nicht best?tigt werden. Da es f?r die Forschungsziele nicht zentral war, wurde es wegen defizit?rer Verwendbarkeit fallen gelassen.

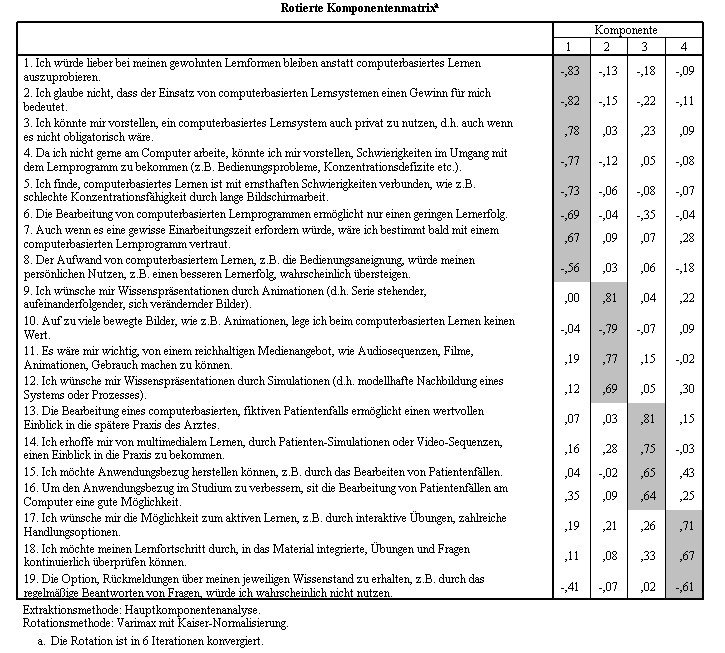

Die spezifischen Merkmale im Hinblick auf den Evaluationsgegenstand: Nach Eliminierung zahlreicher Items, die keinem Hauptfaktor zugeordnet werden konnten, resultierten 4 unabh?ngige Skalen zur Messung der Einstellung und der spezifischen Erwartungen an CBL (Abbildung 4 [Abb. 4]). F?r alle drei Bereiche - Eigenschaften, Strategien, CBL-Merkmale - ergab eine geschlechtsspezifische ?berpr?fung eine erhaltene Faktorenstruktur in beiden Stichproben (w / m).

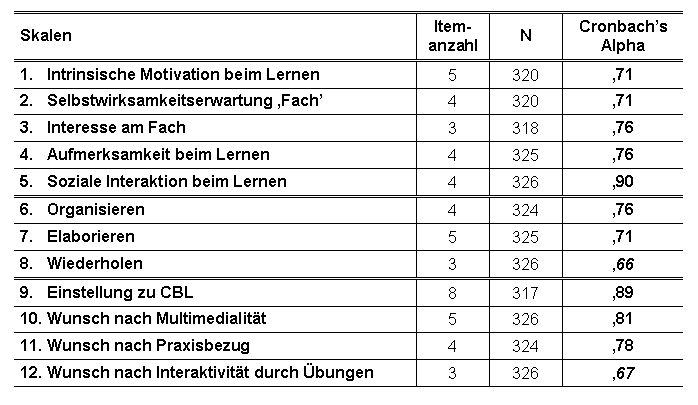

Reliabilit?tsanalyse: Die Reliabilit?t, gesch?tzt anhand des Konzepts der internen Konsistenz, entschied im Weiteren ?ber die Annahme eines Faktors als Skala. Die interne Konsistenz einer Skala wurde mittels des Alpha Koeffizienten nach Cronbach errechnet (Tabelle 2 [Tab. 2]). Meinungen ?ber zufrieden stellende Untergrenzen von Alpha variieren stark (zwischen ,60 und ,90). W?hrend der traditionelle Alpha-Wert mit ,60 [2] angegeben wird, liegt der aktuell ?bliche Standard bei ,70 (z.B. [15], [6]), der auch hier als Untergrenze gew?hlt wurde. Die kursiv gedruckten Alpha-Werte der Skalen „Wiederholen" und „Wunsch nach Interaktivit?t durch ?bungen" deuten auf notwendige Verbesserungen der Skalen hin.

Schritt 5: Validierung

Das Testg?tekriterium der Validit?t liefert Informationen dar?ber, ob ein Test das misst, was er zu messen vorgibt [5]. Die Erfassung der Validit?t ist zumeist aufwendig, da vergleichbare Zusatzinformationen verf?gbar sein m?ssen. Im vorliegenden Fall sollte, wie hier geschehen, eine faktorenanalytische Betrachtung der Messinstrumente vorgenommen werden (Konstruktvalidierung), nicht aber eine Kriteriumsvalidierung. Dies begr?ndet sich darin, dass hierf?r die Messung zus?tzlicher Parameter notwendig ist, was die Fragebogenl?nge in einem nicht mehr akzeptablen Ma?e erh?ht h?tte. Zudem ergibt sich die M?glichkeit zur Erhebung von Au?enkriterien (z.B. tats?chliches Lernverhalten) naturgem?? beim Einsatz des Instruments im Rahmen einer Intervention. Daher erfolgt die Kriteriumsvalidierung zu einem sp?teren Zeitpunkt.

Diskussion

Das Hauptanliegen dieser Arbeit war es, einen systematischen Einblick in die Entwicklung eines Befragungsinstrumentes unter Ber?cksichtigung geltender sozialwissenschaftlicher Standards zu geben. Der so entstandene 57-Item-Fragebogen kann im Hinblick auf die Testg?tekriterien der Objektivit?t, Reliabilit?t und Validit?t als zufrieden stellend beurteilt werden, wobei noch folgende Optimierungsvorschl?ge zu nennen sind:

▪ F?r zwei Skalen („Wiederholen" und „Wunsch nach Interaktivit?t durch ?bungen") sollten die m??igen Reliabilit?tskennwerte durch Erh?hung der Itemanzahl verbessert werden.

▪ In der revidierten Fassung soll die Skala „Selbstst?ndigkeit" in Anlehnung an den LMI [21] vollst?ndig ?bernommen werden.

▪ Mit den faktorenanalytischen Untersuchungen hat eine Konstruktvalidierung stattgefunden. F?r eine Kriteriumsvalidierung sind weitere Untersuchungen vorgesehen.

In Anbetracht dessen, dass ein standardisiertes quantitatives Verfahren vorliegt, kann die Auswertungsobjektivit?t als erf?llt gelten. Die Durchf?hrungsobjektivit?t wurde durch standardisierte Instruktionen sicher gestellt. Erm?dungserscheinungen oder Akzeptanzprobleme waren bei der urspr?nglichen Bearbeitungszeit von 20 Minuten nicht zu verzeichnen. Die Bearbeitungszeit sollte nunmehr bei ca. 10 Minuten liegen.

Mit dem konzipierten Fragebogen liegt ein quantitatives Instrument vor, das f?r die Evaluation von CBL-Programmen eingesetzt werden kann. Der lernerzentrierte Schwerpunkt erlaubt die Betrachtung von Akzeptanz- oder Leistungsmessungen unter Ber?cksichtigung individueller Kompetenzen und Lerngewohnheiten, was bisher kaum erfolgt ist. Damit k?nnten nicht nur Erkenntnisse ?ber individuumsabh?ngige Determinanten der Akzeptanz oder des Lernerfolgs von CBL gewonnen werden, sondern auch Hinweise darauf, inwiefern (und welche) Voraussetzungen auf Seiten der Lernenden bei der Konstruktion von CBL-Programmen ber?cksichtigt werden sollten.

Danksagung

Das Projekt wurde vom BMBF unterst?tzt (NM 08 NM 109 C an S.H.).

Literatur

[1] Adler MD, Johnson KB. Quantifying the literature of computer-aided instruction in medical education. Acad Med. 2000; 75: 1025-8.[2] Aharony L, Strasser S. Patient satisfaction: what we know about and what we still need to explore. Med Care Rev. 1993; 50: 49-79.

[3] Benninghaus H. Einf?hrung in die sozialwissenschaftliche Datenanalyse. M?nchen: Oldenbourg; 1990.

[4] Bishop G. Qualitative Anlaysis of Question-Order and Context Effects: The Use of Think-Aloud-Responses. In: Schwarz N, Sudman S, eds. Context Effects in Social and Psychological Research. New York: Springer; 1992. p. 149-162.

[5] Bortz J, D?ring N. Forschungsmethoden und Evaluation f?r Sozialwissenschaftler. Berlin: Springer; 2002.

[6] Bullinger M. Lebensqualit?tsmessung mit dem SF-36 Health Survey. In: Ruprecht T. Qualit?tsbewertung von Gesundheitsdienstleistungen - Konzepte, Methoden, praktische Beispiele. Sankt Augustin: Asgard; 1998. p. 93-99.

[7] Dillon A, Gabbard R. Hypermedia as an educational technology: A review of the quantitative research literature on learner comprehension, control, and style. Rev Educat Res. 1998; 68: 322-49.

[8] Fowler FJ. Improving Survey Questions. Thousands Oaks: Sage; 1995.

[9] Hartley K, Bendixen LD. Educational research in the internet age: examining the role of individual characteristics. Educat Res. 2001; 53: 22-5.

[10] Issing LJ, Strzebkowski R. Lehren und Lernen mit Multimedia. Medienpsychologie. 1995; 7: 287-319.

[11] Keane DR, Norman GR, Vickers J. The inadequacy of recent research on computer-assisted instruction. Acad Med. 1991; 66: 444-8.

[12] Land A, Pfaff H, Toellner-Bauer U, Scheibler F, Freise DC. Qualit?tssicherung des K?lner Patientenfragebogens durch kognitive PretestTechniken. In: Pfaff H, Freise DC, Mager G, Schrappe M, eds. Der K?lner Patientenfragebogen (KPF). Sankt-Augustin: Asgard; 2001. p. 91-100.

[13] Leutner D, Br?nken R, eds. Neue Medien in Unterricht, Aus- und Weiterbildung: aktuelle Ergebnisse empirischer p?dagogischer Forschung. M?nster: Waxmann; 2000.

[14] Lienert GA, Raatz U. Testaufbau und Testanalyse. 5th ed. Weinheim: Beltz Psychologie Verlags-Union; 1994.

[15] Pfaff H, Freise DC. Der K?lner Patientenfragebogen (KPF): Skalen und Indizes. In: Pfaff H, Freise DC, Mager G, Schrappe M, eds. Der K?lner Patientenfragebogen (KPF). Sankt-Augustin: Asgard; 2001. p. 101-135.

[16] Pintrich PR. The dynamic interplay of student motivation and cognition in the college classroom. Adv Motiv Achievement. 1989; 6: 117-60.

[17] Pr?fer P, Rexroth M. Verfahren zur Evaluation von Survey-Fragen: Ein ?berblick. ZUMA-Nachrichten. 1996; 39: 95-115.

[18] Schiefele U. Thematisches Interesse, Variablen des Leseprozesses und Textverstehen. Zeitschr Exp Angew Psychol. 1990; 37: 304-32.

[19] Schnell R, Hill, PB, Esser E. Methoden der empirischen Sozialforschung. M?nchen: Oldenbourg, 1989.

[20] Schott F. Evaluation aus theoriegeleiteter, ganzheitlicher Sicht. In: Schenkel P, Tergan SO, Lottmann A, eds. Qualit?tsbeurteilung multimedialer Lern- und Informationssysteme. Evaluationsmethoden auf dem Pr?fstand. N?rnberg: BW; 2000. p. 106-125.

[21] Schuler H, Prochaska M, Frintrup A. Leistungsmotivationsinventar. Dimensionen berufsbezogener Leistungsorientierung. G?ttingen: Hogrefe; 2001.

[22] Schwarzer R, Jerusalem M. Skalen zur Erfassung von Lehrer- und Sch?lermerkmalen. Dokumentation der psychometrischen Verfahren im Rahmen der wissenschaftlichen Begleitung des Modellversuchs Selbstwirksame Schulen; 1999. Korrigierte Web Version, 2001: http://psychologie.de/Schwarzer

[23] Spector PE. Summated Rating Scale Construction. An Introduction. Newbury Park, CA: Sage Publications; 1992.

[24] Steele DJ, Johnson Palensky JE, Lynch TG, Lacy NL, Duffy SW. Learning preferences, computer attitudes, and student evaluation of computerised instruction. Med Educ. 2002; 36: 225-32.

[25] Sudman S, Bradburn N. Asking Questions. A Practical Guide to Questionnaire Design. San Francisco: Jossey-Bass; 1982.

[26] Weidenmann B. Psychologie des Lernens mit Medien. In: Weidenmann B, Krapp A, Hofer M, Huber GL, Mandl H, eds. P?dagogische Psychologie. Ein Lehrbuch. Weinheim: Beltz Psychologie Verlags-Union; 1993. p. 493-554.

[27] Wild KP, Schiefele U, Winteler A. LIST - Ein Verfahren zur Erfassung von Lernstrategien im Studium. In: Krapp A, ed. Arbeiten zur empirischen P?dagogik und p?dagogischen Psychologie (Bd. 20). Neubiberg: Gelbe Reihe; 1992.

[28] Wild KP. Lernstrategien im Studium. Strukturen und Bedingungen. M?nster: Waxmann; 2000.