[OSCE - hands on instructions for the implementation of an objective structured clinical examination]

Christoph Nikendei 1Jana J?nger 1

1 Medizinische Universit?tsklinik Heidelberg, Ludolf-Krehl-Klinik, Klinik f?r Allgemeine Klinische Medizin und Psychosomatik, Heidelberg, Deutschland

Abstract

Introduction: Objective structured clinical examinations (OSCEs) have proved to be a reliable and valid assessment tool for basic clinical skills. In regards to the more and more practical education of medical students there is an increasing need for the implementation of OSCEs. To facilitate this implementation we would like to give a review of literature and to present our 12 station OSCE at the Medical Hospital of the University of Heidelberg.

Methods: During winter term 2004 / 2005 143 medical students in thir 3rd year of training participated the OSCE. For the conception of the assessment a blueprint was used. Standard setting was carried out with a modified Angoff method, students performance was assessed by experts using self-developed checklists.

Results: The OSCE at the Medical Hospital of the University of Heidelberg showed a reliability of 0,748. According to the results of the standard setting procedure 142 students (99,3%) passed the exam. Taking the OSCE on the first, second or third day of assessment did not have impact on students' performance.

Discussion: The OSCE at the Medical Hospital of the University of Heidelberg proves to be a reliable and fair assessment tool. Even the OSCE represents an assessment tool that needs resources and time it is well accepted in students and raters if it is planned and organised carefully.

Keywords

OSCE, undergraduate medical education, standard setting, reliability, validity

Einleitung

Klinisch-praktische Pr?fungen im Licht der Novellierung der ?rztliche Approbationsordnung

Klinisch-praktische Pr?fungen in Form eines OSCE (objective structured clinical examination, [57]) haben in den vergangenen Jahren weltweit eine hohe Akzeptanz und Verbreitung gefunden. Mit dieser Pr?fungsform werden die Medizinstudenten direkt auf der Stufe des "shows how" der Lernpyramide von Miller [34] gepr?ft, also die Durchf?hrung prozeduraler Fertigkeiten und F?higkeiten direkt beurteilt. Die Novellierung der Approbationsordnung f?r ?rzte [3] betont eine praxisnahe Ausbildung von Medizinstudenten, womit in der Konsequenz auch die Durchf?hrung solcher klinisch-praktischen Pr?fungen an deutschen Medizinischen Fakult?ten zur Leistungsbewertung und Notenvergabe einen wichtigen Stellenwert einnehmen wird. Dies impliziert die Notwendigkeit, eine gerechte, dem Wissensstand angepasste, reliable und valide OSCE-Pr?fung zu gew?hrleisten. Hierbei werden die einzelnen Fakult?ten mit organisatorischen und logistischen Schwierigkeiten konfrontiert. Um die Planung, Konzeption und Durchf?hrung eines OSCE zu erleichtern, m?chten wir den aktuellen Forschungsstand und die Konsequenzen f?r eine praxisnahe, ressourcensparende Umsetzung einer OSCE-Pr?fung am Beispiel der Medizinischen Universit?tsklinik Heidelberg skizzieren.

Was ist ein OSCE?

Das Pr?fungsformat eines OSCE wurde erstmals an der Universit?t Dundee in Schottland durchgef?hrt und von Harden et al. [19] publiziert. Die einzelnen Medizinstudenten rotieren beim OSCE durch einen Pr?fungsparcours mit einer Serie von Pr?fungsstationen, an denen sie definierte klinisch-praktische Fertigkeiten unter Beweis stellen m?ssen. An jeder Pr?fungsstation wird die Pr?fungsleistung durch einen Pr?fer anhand einer Checkliste beurteilt. Die im Namen beinhaltete "Objektivit?t" und "Strukturierung" spiegeln sich in der hohen Anzahl von Pr?fungsstationen und beteiligten Pr?fern sowie in den standardisierten Aufgabenstellungen und inhaltlich definierten Checklisten wieder.

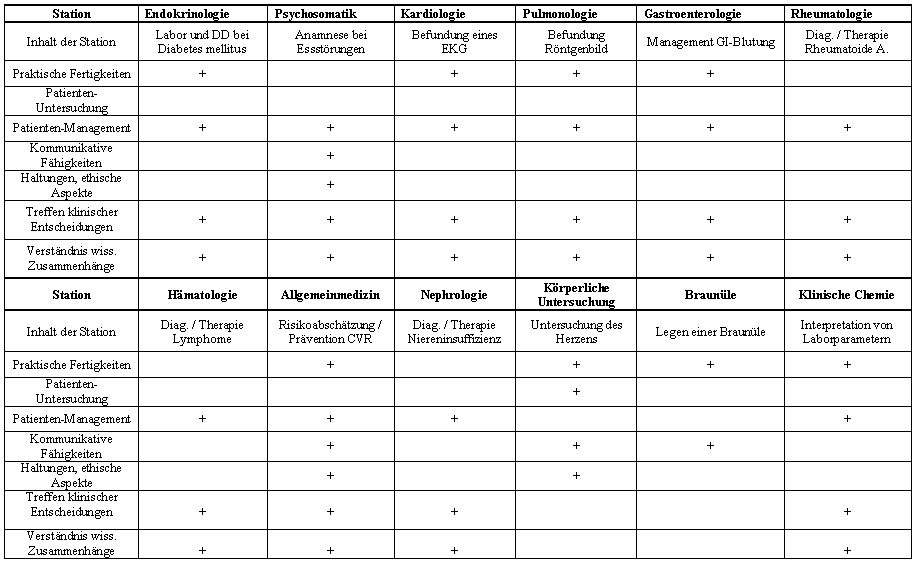

Validit?t des OSCE und Blueprint

Die Validit?t von OSCEs konnte in vielen F?llen nachgewiesen werden (z.B. [22], [29], [6], [7]). Um eine hohe Inhaltsvalidit?t eines OSCE herzustellen, empfiehlt Newble [37] drei Schritte bei der Pr?fungskonzeption: Erstens die Festlegung von Problemfeldern, in denen die Pr?flinge kompetent sein sollen, zweitens die Definition von Aufgabenstellungen innerhalb dieser Problemfelder und - drittens - die Erstellung eines "Blueprint". Mit Hilfe des "Blueprint" werden die Pr?fungsinhalte des OSCE mit den Zielen des der Pr?fung zugrunde liegenden Curriculums abgeglichen. Der Blueprint gew?hrleistet, dass alle Curriculumsziele gepr?ft werden und die entscheidenden Schl?sselprobleme angemessen repr?sentiert sind [14]. Im einfachsten Fall besteht ein Blueprint aus einer zweidimensionalen Matrix, bei der auf einer Achse allgemeine zu testende Kompetenzen (z.B. Anamneseerhebung, k?rperliche Untersuchung usw.) verzeichnet sind, auf der anderen die Problemstellungen, mit welchen diese Kompetenzen abgepr?ft werden sollen [36]. Ein Beispiel f?r einen Blueprint wird in Tabelle 1 [Tab. 1] veranschaulicht.

Reliabilit?t des OSCE: Anzahl und Dauer der Pr?fungsstationen

Zu den Einflussvariablen, die die Reliabilit?t [35] eines OSCE m?glicherweise beeinflussen k?nnen, z?hlen die Anzahl der Pr?fer, die Anzahl an Pr?fungsstationen, die Strukturiertheit der Pr?fung und die unterschiedlichen bei der Pr?fung eingesetzten standardisierten Patienten [55]. Den gewichtigsten Faktor stellt allerdings die Anzahl der beim OSCE verwandten Pr?fungsstationen dar. Aufgrund der Spezifit?t der Problemstellungen an den einzelnen Pr?fungsstationen ist es notwendig, eine hohe Anzahl von unterschiedlichen Problemf?llen und damit von Pr?fungsstationen zum Einsatz zu bringen, um eine Reliabilit?t um 0,8 zu erzielen, wie f?r "high stakes" Examina gefordert [56], [50], [37]. Das Accreditation Council for Graduate Medical Education (ACGME) und das American Board of Medical Specialties (ABMS) [50] empfehlen die Implementierung von 14 - 18 Pr?fungsstationen ? 10 - 15 Minuten. F?r eine einzelne Pr?fungsstation mit einem standardisierten Patienten (SP) [4] zur Anamneseerhebung und Durchf?hrung einer k?rperlichen Untersuchung ist eine Pr?fungszeit von 15 Minuten einzukalkulieren [8]. Anzahl und Dauer der OSCE-Stationen werden in der Praxis ganz unterschiedlich festgelegt:

• Universit?t Dundee, Schottland: 25 - 35 Pr?fungsstationen ? 4? Minuten [14]

• Medical Council, Canada: 20 Pr?fungsstationen ? 10 Minuten [44]

• Havard Medical School, USA: 16 Pr?fungsstationen ? 9 Minuten [18]

Die in der Literatur f?r die Durchf?hrung von reliablen OSCEs veranschlagte Zeitdauer und Anzahl der Pr?fungsstationen d?rfte f?r die deutschen Fakult?ten kaum realisierbar sein (vgl. [56], [50], [37]). Ziel der vorliegenden Untersuchung war es deshalb zu pr?fen, inwieweit ein OSCE mit weniger Stationen und k?rzerer Pr?fungsdauer die geforderte Reliabilit?t erreicht.

Checklisten oder globales Rating?

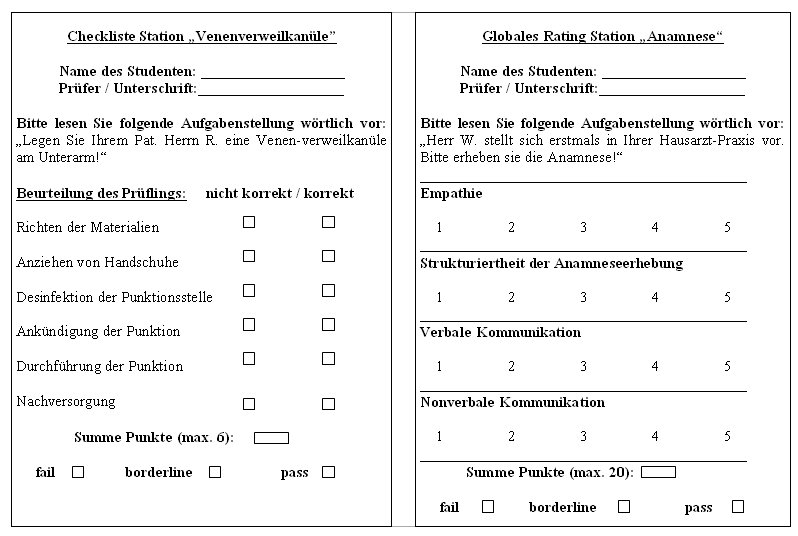

Traditionell werden beim OSCE Checklisten mit bin?ren Items ("korrekt" / "nicht korrekt") verwandt, mit deren Hilfe die korrekte Durchf?hrung von Teilschritten der Pr?fungsaufgabe festgehalten wird [32], [49] (siehe Abbildung 1 [Abb. 1]). Bei einem globalen Rating hingegen werden z.B. f?r insgesamt vier prozedurale Dimensionen jeweils f?nf Punkte vergeben [21] (siehe Abbildung 1 [Abb. 1]). Checklisten mit bin?ren Items bergen die Gefahr, die Pr?fer durch eine Fokussierung auf die Checklisten-Items abzulenken [15], [23], [47], so dass eine steigende Zahl von Items die Reliabilit?t und Validit?t des OSCE reduziert [59]. Auch insgesamt erweist sich ein globales Rating (siehe Abbildung 1 [Abb. 1]) in Bezug auf Reliabilit?t, interne Konsistenz und Validit?t der Verwendung von Checklisten als ebenb?rtig [22], [43], [42], [45], [54] und bildet interaktive Kompetenzebenen wie Empathie und ethische Haltungen besser ab [41], [53]. Auf der Ebene der Pr?flinge f?hrt ein globales Rating bei der Pr?fung kommunikativer F?higkeiten zu vermehrt offenen Fragen, ein Checklisten-Rating zu vielen fokussierten, geschlossenen Fragen [23]. Die Kombination aus globalem Rating und der Verwendung von Checklisten ist m?glich und kann durchaus sinnvoll sein. Newble [37] empfiehlt bei Stationen mit vorrangig technischen Fertigkeiten eine Checkliste als ad?quates Evaluationsinstrument, bei der Pr?fung von kommunikativen Kompetenzen hingegen die Verwendung eines globalen Ratings. Ziel der vorliegenden Studie war es, ein eigenes Checklistenformat zu entwickeln, welches die Vorteile eines Checklisten-Ratings und einem globalen Rating vereint.

Der OSCE als formative und summative Pr?fungsform / Feedback w?hrend des OSCE

OSCEs k?nnen mit unterschiedlichen Intentionen durchgef?hrt werden. In vielen F?llen wird der OSCE als sogenannte formative Pr?fung eingesetzt [31]. Dies bedeutet, dass der OSCE in diesem Falle dazu dient, den Studenten ein konstruktives Feedback ?ber ihren aktuellen Wissens- und K?nnensstand geben zu k?nnen. Defizite in der Durchf?hrung prozeduraler Fertigkeiten k?nnen somit identifiziert und korrigiert werden [52]. Bei summativen Pr?fungen dient der OSCE dagegen vorrangig zur Entscheidung ?ber das Vorhandensein notwendiger Qualifikationen zum Bestehen von definierten Abschnitten eines Curriculums.

Eine eineinhalbmin?tiges Feedback im Anschluss an die Absolvierung einzelner OSCE-Stationen wird von den Medizinstudenten als hilfreich und wenig st?rend empfunden [1]. Ein solches Feedback f?hrt nachgewiesener Ma?en nachfolgend zu einer Verbesserung der studentischen Fertigkeiten [20].

Standard Setting - Ermittlung der Bestehensgrenze eines OSCE

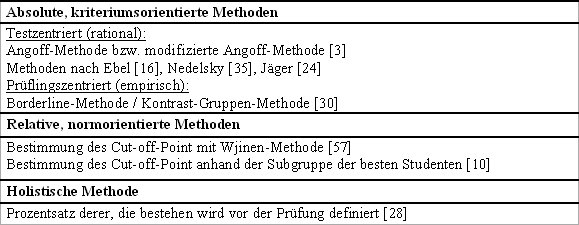

Mit einem Standard Setting wird die Bestehensgrenze eines OSCE festgelegt, die "kompetente" von "nicht-kompetenten" Studenten trennen soll. Man unterscheidet je nach Vorgehensweise kriteriumsorientierte, normorientierte und holistische Methoden (siehe Tabelle 2 [Tab. 2]). Die willk?rliche Festlegung einer Bestehensgrenze (z.B. 60%), wie es das Vorgehen bei der holistischen Methode vorsieht, weist eine ungen?gend begr?ndbare Entscheidungsbasis ?ber das Bestehen oder Nicht-Bestehen einer Pr?fung auf [17]. Aber auch normorientierte Verfahren haben Schw?chen, die in unter anderem in der relativen Bewertung der Studenten untereinander zu sehen sind [28]. Die kriteriumsorientierten Methoden bieten hingegen gute Zug?nge zur Ermittlung der Bestehensgrenze und sollen hier kurz skizziert werden.

Bei der Methode nach Angoff, die beispielsweise in den USA (ECFMG/CSA) [5] verwandt wird, wird die Bestehensgrenze bereits vor der Pr?fung durch eine Gruppe von Experten festgelegt. Diese Experten sollten ?ber die Pr?fungsstandards informiert und mit der Pr?fungsmethode vertraut sein und den Kenntnisstand der Medizinstudenten einsch?tzen k?nnen. Zudem sollten sie sich ?ber die Schwierigkeit der Pr?fungsaufgabe im Klaren sein, was durch die Demonstration von Videos oder die eigene Durchf?hrung der Pr?fungsaufgabe unter examens?hnlichen Bedingungen unterst?tzt werden kann [5], [17]. Searle [48] verwandte f?r die Angoff-Methode eine Anzahl von drei Experten.

Friedman [17] empfiehlt eine modifizierte Angoff-Methode ("modified Angoff") mit einem Vorgehen in vier Schritten in dessen Zentrum die Frage steht, wie viele Punkte ein sogenannter "Borderline-Pr?fungskandidat" an einzelnen Pr?fungsstation erzielen w?rde. Nach einem ersten Rating der Experten werden die Einsch?tzungen untereinander pr?sentiert und diskutiert, bevor ein zweites, endg?ltiges Rating erfolgt. Ein "Borderline-Pr?fungskandidat" wird dabei definiert als ein Pr?fungsteilnehmer, der die Experten weder als qualifiziert, noch als unqualifiziert einsch?tzen [5]. Der Mittelwert dieser Einsch?tzungen gibt die Bestehensgrenze f?r die einzelnen Stationen bzw. die Mittelwertsbildung ?ber alle Pr?fungsstationen die Bestehensgrenze f?r die gesamte OSCE-Pr?fung an. Es ist dabei zu ber?cksichtigen, dass die Ratings immer in Form der Anzahl von erreichten Punkten erfolgen sollten und nicht in Prozentwerten, da sich gezeigt hat, dass sich die Experten von g?ngigen Vorstellungen von Bestehensgrenzen (z.B. 50% oder 70%) beeinflussen lassen. Nachteile der Angoff-Methode sind in der Zeitaufwendigkeit und der hypothetischen Herangehensweise zur Festlegung der Bestehensgrenze zu sehen [17].

Bei der Borderline-Methode, die beispielsweise vom Medical Council von Canada verwandt wird [45], wird die Bestehensgrenze hingegen empirisch durch eine direkte Beobachtung w?hrend der Pr?fung festgelegt, so dass keine zus?tzliche Zeit zur Bestimmung der Bestehensgrenze aufgewandt werden muss [37]. Nachteil dieser Methode ist es, dass die Bestehensgrenze nicht wie in den meisten Studienordnungen gefordert vor der Pr?fung festgelegt werden kann. Die Einsch?tzung, ob ein Pr?fling ein "Borderline-Pr?fungskandidat" ist, wird durch eine zus?tzliche Skala auf der Checkliste der einzelnen Stationen festgelegt (siehe Abbildung 1 [Abb. 1]), die in der Praxis auf unterschiedliche Weise erfolgen kann:

• Rating auf einer Skala bestehend aus: pass / borderline / fail [46]

• Rating auf einer Skala bestehend aus: fail, borderline, pass, above expected standard [13]

Der Mittelwert der an den einzelnen Stationen von den "Borderline-Pr?fungskandidaten" erreichten Punktzahlen entspricht wiederum der Bestehensgrenze der OSCE-Pr?fung.

Eine Modifikation der Borderline-Methode stellt die Kontrast-Gruppen-Methode dar, bei der keine Gruppe von "Borderline-Pr?fungskandidaten" definiert wird, sondern lediglich eine Unterscheidung in "kompetent" vs "„nicht-kompetent" erfolgt und anhand dieser Festlegung die Errechnung der Bestehensgrenze erfolgt [5]. Sowohl die Borderline-Methode als auch die Kontrast-Gruppen-Methode bieten beide konsistente und realistische Standards [12].

Sowohl bei der Methode nach Angoff als auch bei der Borderline-Methode stellt es sich f?r die Experten bzw. die Pr?fer h?ufig als schwierig dar, sich einen "Borderline-Pr?fungskandidaten" vorzustellen. Ziel war es dementsprechend eine modifizierte Angoff-Methode zu entwickeln, die es erlaubt eine Standard Setting innerhalb kurzer Zeit effizient durchzuf?hren.

Der OSCE als kompensatorische oder non-kompensatorische Pr?fungsform?

Bei einem kompensatorischen Ansatz muss der Pr?fling lediglich eine bestimmte Gesamtpunktzahl beim OSCE erreichen - eine unzufriedenstellende Leistung an einer einzelnen OSCE-Station kann durch eine bessere Leistung an einer beliebigen anderen Station ausgeglichen werden. Bei einem non-kompensatorischen OSCE m?ssen die Studenten einzelne oder im Extremfall an allen OSCE-Stationen die Bestehensgrenze erreichen, um auch den gesamten OSCE erfolgreich zu bestehen. Es existiert keine falsche oder richtige Antwort auf die Frage, ob ein kompensatorischer oder non-kompensatorischer Ansatz pr?feriert werden sollte und welcher Zugang der validere ist [37]. F?r die Bef?rwortung einer non-kompensatorischen Vorgehensweise spricht, dass die Pr?flinge in allen Bereichen ihre F?higkeiten unter Beweis stellen m?ssen. Die Gefahr dieses Modells ist jedoch, dass eine schlecht konzipierte Station eventuell schlecht zwischen "kompetenten" und "nicht-kompetenten" Studenten trennt und nicht nur die "nicht-kompetenten" Studenten die Leistungserwartung an dieser Station nicht erf?llen. Au?erdem kann es auch f?r gute Studenten zul?ssig sein, Schwierigkeiten bei der Absolvierung von ein oder zwei Stationen aufzuweisen [9], [17]. Als schwierig erweist sich bei non-kompensatorischen OSCE-Stationen auch die Wiederholung von nicht bestandenen OSCE-Stationen. Da der Pr?fling meist nur wenige Stationen nicht bestanden hat, m?sste er nur diejenigen wiederholen, was in einem laufenden OSCE nicht praktikabel ist.

Im Folgenden soll die praktische Umsetzung einer klinisch-praktischen Pr?fung am Beispiel des OSCE im Wintersemester 2004 / 2005 an der Medizinischen Universit?tsklinik Heidelberg in Hinblick auf Konzeption, Bestimmung der Bestehensgrenze, Durchf?hrung und Notenvergabe dargestellt werden.

Methoden

Der OSCE an der Medizinischen Universit?tsklinik Heidelberg

An der Medizinischen Universit?tsklinik Heidelberg werden OSCEs seit dem Wintersemester 2001/2002 durchgef?hrt (vgl. [26]). Die OSCEs finden im 6. bzw. 7. Studiensemester am Ende des 14-w?chigen Blockkurses "Innere Medizin" statt, w?hrend dem sich die Studenten klinisch-praktisch Kompetenzen beim Kommunikationstraining mit standardisierten Patienten [25] [40], beim Skills-Lab-Training [38], [39] und beim Einsatz auf Station erwerben k?nnen. Die Pr?fungsinhalte werden jeweils mit Hilfe eines Blueprint auf die Lernziele des Blockes Innere Medizin abgestimmt (siehe Tabelle 1 [Tab. 1]). Zu Beginn ihres Einsatzes in der Medizinischen Universit?tsklinik werden die Studenten ?ber den Ablauf und die Formalien des OSCE informiert. Die OSCE-Pr?fung in Heidelberg ist eine kompensatorische Pr?fung. Bei Nicht-Bestehen muss die gesamte Pr?fung ein Semester sp?ter wiederholt werden.

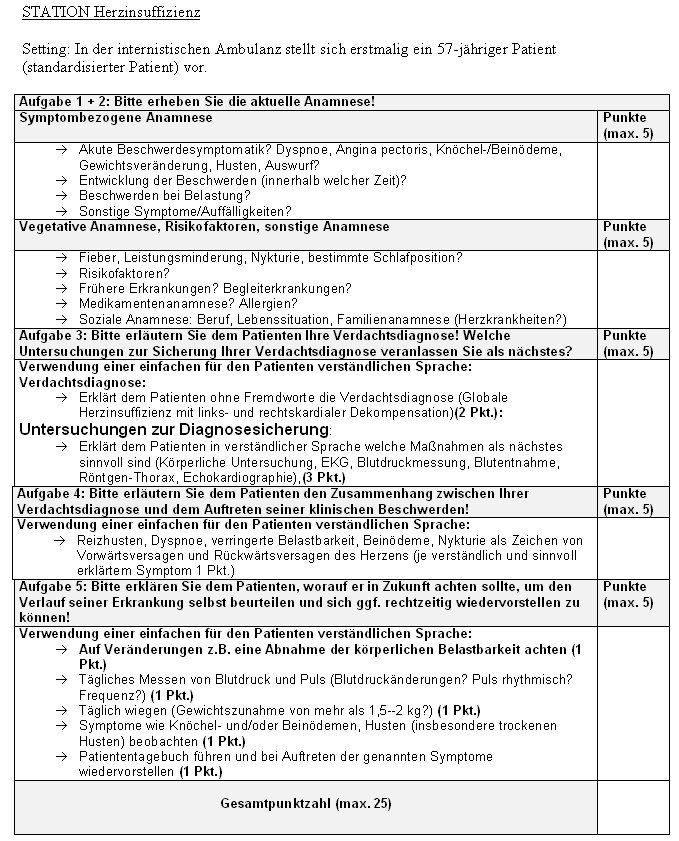

Design der Stationen und Checklisten / Standard Setting und Notenvergabe

Die einzelnen Pr?fungsstationen des 12-Stationen-OSCE wurden von Vertretern der jeweiligen internistischen Teildisziplin in ?bereinstimmung mit dem entworfenen Blueprint entwickelt. Als Grundlage diente ein definiertes Checklistenformat mit einem modifizierten Rating mit f?nf Teilaufgaben, bei denen jeweils 5 Punkte zu erzielen waren. Insgesamt konnte somit eine Maximalpunktzahl von 25 pro Pr?fungsstation erreicht werden. Das Checklistenformat beinhaltet sowohl Anteile des Checklisten-Ratings als auch des globalen Ratings: So werden z.B. f?r die Teilaufgabe 1 und 2 der Checkliste in Abbildung 2 [Abb. 2] nur die maximal zu erreichende Punktzahl vorgegeben, so dass der Gesamteindruck des Pr?fers bez?glich der Gespr?chsf?hrung und Empathie mit in die globale Bewertung einflie?en kann.

Zur Ermittlung der Bestehensgrenze wurde ein modifiziertes Vorgehen nach Angoff [2] entwickelt. Ein Vertreter jeder internistischen Teildisziplin (n=10) nahm als Experte am Standard Setting teil und gab ein Rating zur "minimal zu demonstrierenden Kompetenz" in Form der minimal zu erreichenden Punktzahl f?r jede einzelne Stationen ab. Der Mittelwert der Einsch?tzung aller Experten ergab die Bestehensgrenze f?r die entsprechende Station, der Mittelwert ?ber alle Stationen hinweg die Bestehensgrenze f?r den OSCE. Da in Deutschland die Notwendigkeit der Notenvergabe besteht, wurden die Punktwerte ?ber der Bestehensgrenze in vier gleichgro?e Abschnitte unterteilt, entsprechend den Noten eins bis vier.

Ablauf des OSCE

Alle 12 Stationen des OSCE im Wintersemester 2004 / 2005 waren mit der Stationsnummer beschildert. Maximal zwei Stationen waren - abgetrennt durch einen Sichtschutz - in einem Pr?fungsraum lokalisiert. Pro Station stand den Medizinstudenten eine Pr?fungszeit von f?nf Minuten zur Verf?gung mit einer sich anschlie?enden einmin?tigen Wechselzeit. Der Beginn und das Ende der Pr?fungszeit wurde jeweils mit einem lauten Signalton angezeigt. Ein einmaliger Durchlauf des 12-Stationen-OSCE nahm somit 72 Minuten in Anspruch. Bis zum nachfolgenden OSCE-Durchlauf wurde jeweils eine Pause von 18 Minuten eingelegt. ?ber drei Tage hinweg wurden jeweils zwei Mal nacheinander zwei parallele OSCE-Pr?fungen durchgef?hrt, somit also pro Tag maximal vier Gruppen ? 12 Studenten gepr?ft. Insgesamt wurden an den drei Pr?fungstagen 143 Studenten der OSCE-Pr?fung unterzogen.

Um eine Informationsweitergabe zwischen den Studentengruppen zu vermeiden, wurden die Pr?flinge eines Pr?fungstages gemeinsam in einem Warteraum gesammelt. Zwischen den einzelnen Pr?fungstagen wurden die OSCE-Parcours inhaltlich leicht modifiziert, um ebenfalls eine Informationsweitergabe zu erschweren. Die Identifikation der Medizinstudenten erfolgte mittels Personalausweis. Die von den Medizinstudenten mitzubringenden Utensilien umfassten Arztkittel, Stethoskop und Reflexhammer. Bevor die Studenten den Parcours betraten, wurden sie mittels eines Parcours-Planes ?ber die Lage der Stationen informiert und in den zeitlichen und r?umlichen Ablauf unterwiesen.

An den Stationen selbst wurde zuerst der Namen der Studenten erfragt und dieser auf der Checkliste notiert. Mit dem ersten Signalton wurde die Aufgabenstellung vom Pr?fer w?rtlich vorgelesen. Diese stand den Studenten zus?tzlich in schriftlicher Version an den einzelnen Pr?fungsstationen zur Verf?gung. Mit dem zweiten Signalton endete die Pr?fungszeit und die erreichte Gesamtsumme wurde vom Pr?fer notiert. Der Medizinstudent erhielt ein kurzes Feedback (ca. 30s) zu seiner Pr?fungsleistung ohne die Nennung des erreichten Punktwertes, bevor er zur n?chsten Station gebeten wurde. Anschlie?end wurde die Checkliste vom Pr?fer unterschrieben und in die vorgesehene Ablage gelegt.

Die Pr?fer

F?r jede Pr?fungsstation des OSCE wurde ein Pr?fer aus dem jeweiligen Fachgebiet festgelegt. Alle Pr?fer erhielten direkt vor dem Beginn der Pr?fung eine 30-min?tige Einf?hrung in den Ablauf der Pr?fung, das Procedere an den Pr?fungsstationen sowie die erwarteten L?sungen der Aufgabenstellungen. Alle Pr?fer pr?ften zwei OSCE-Durchl?ufe und wurden in der Pause mit Essen und Trinken versorgt. Da mit zwei parallelen Parcours gepr?ft wurde, wurden pro Tag 24 Pr?fer ?ber eine Zeit von ca. 3,5 Stunden (inklusive Einf?hrung und Pause) ben?tigt, um 48 Studenten zu pr?fen.

Die Helfer und standardisierten Patienten

F?r den Aufbau der beiden 12-Stationen-OSCEs war die Hilfe von vier Personen ?ber ca. drei Stunden erforderlich. W?hrend des OSCE war f?r beide Parcours ein "Zeitgeber" f?r die Einhaltung der Pr?fungszeiten und die Abgabe des Signaltons sowie eine Person als zentrale Aufsicht und als Ansprechpartner bei auftretenden Problemen verantwortlich. Eine weitere Person pro Parcours war f?r das Einsammeln der Checklisten und deren Kontrolle auf Vollst?ndigkeit zust?ndig, dar?ber hinaus achtete eine zus?tzliche Person pro Parcours darauf, dass die Studenten problemlos zur n?chstfolgenden Pr?fungsstation fanden. Eine Person ?ber dieselbe Zeit diente der Kontrolle, Einf?hrung und Betreuung der Studenten vor ihrem jeweiligen Pr?fungsbeginn, so dass insgesamt vier Helfer zum Aufbau sowie sieben Helfer w?hrend der eigentlichen Pr?fungszeit ben?tigt wurden. Dass lediglich ein "Zeitgeber" und eine zentrale Aufsicht zum Einsatz kommen musste lag an der r?umlichen N?he der beiden Parcours. An jeweils zwei Pr?fungsstationen waren standardisierte Patienten (SP) [4] f?r die Pr?fung kommunikativer F?higkeiten und an einer Stationen ein SP f?r die Pr?fung k?rperlicher Untersuchungstechniken eingesetzt. Nicht ber?cksichtigt bleibt in dieser Aufstellung der Zeitaufwand f?r die Erstellung der Pr?fungsstationen (je nach Vorerfahrung ca. 3 Stunden pro Station), f?r die im Vorfeld notwendige Pr?fungsorganisation, f?r das Standard Setting (ca. 2,5 Stunden) sowie f?r die Auswertung der Pr?fungsergebnisse.

Bestehensgrenze, Leistungsbewertung und statistische Analyse

Die Bestehensgrenze des OSCE wurde anhand des zuvor beschriebenen Standard Setting bestimmt. Die Punktwerte ?ber der Bestehensgrenze wurden in vier gleich gro?e Anteile geteilt und den Notenwerten 1 bis 4 zugeteilt. Die Reliabilit?t des OSCE wurde mittels Cronbach alpha auf Basis der an den einzelnen Pr?fungsstationen erreichten Punktwerte bestimmt. Zudem wurde f?r die einzelnen Stationen die durchschnittlich erreichte Punktzahl, die Standardabweichung, die Trennsch?rfe (Korrelation der Punktzahl mit der Gesamtpunktzahl an allen Stationen) und die korrigierte Trennsch?rfe (Korrelation der Punktzahl mit der Summe aller anderen Stationen) errechnet. Das Abschneiden an den einzelnen Pr?fungstagen wurde mittels Varianzanalyse verglichen.

Ergebnisse

Stichprobenbeschreibung

Im Wintersemester 2004 / 2005 nahmen n = 143 Medizinstudenten des 6. Studiensemesters des interdisziplin?ren Blocks Innere Medizin (53 M?nner, 88 Frauen) mit einem Durchschnittsalter von 24,7 Jahren (M?nner 25,4 J., Frauen 24,2 J.) teil.

Ergebnisse des Standard Setting und Bestehensgrenze

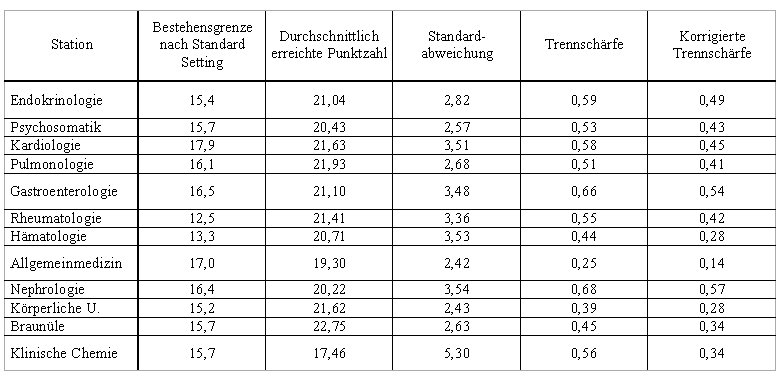

Die Bestehensgrenze f?r die einzelnen OSCE-Stationen wird aus Tabelle 3 [Tab. 3] ersichtlich. Die Mittelwertbildung ?ber die 12 Stationen ergab f?r den OSCE des WS 2004 / 2005 eine Bestehensgrenze von 188 Punkten.

Pr?fungsergebnisse und Notenvergabe

Die im Durchschnitt erreichten Punktzahlen an den 12 Pr?fungsstationen ist ebenfalls Tabelle 3 [Tab. 3] zu entnehmen. Im Durchschnitt wurde von den Studenten eine Gesamtpunktzahl von 249,6 (SD = 20,2; min. = 172, max. = 284) erreicht. Studenten, die am ersten, zweiten und dritten Pr?fungstag den OSCE durchliefen unterschieden sich in ihren Pr?fungsergebnissen nicht voneinander (Varianzanalyse: F(2,140) = 0,844, p = 0,432). Daten zur Aufgabenschwierigkeit und Trennsch?rfe [35] finden sich ebenfalls in Tabelle 3 [Tab. 3]. Die Reliabilit?t des OSCE belief sich auf ein Cronbach alpha von 0,748.

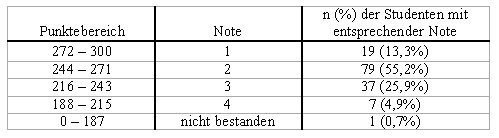

Die prozentuale Verteilung der Noten entsprechend der erreichten Gesamtpunktzahlen ist aus Tabelle 4 [Tab. 4] ersichtlich. Ein Student (0,7%) blieb unterhalb der Bestehensgrenze und erreichte das Pr?fungsziel nicht.

Diskussion

Der OSCE stellt eine Pr?fungsmethode dar, die sich sehr gut zur Pr?fung von wesentlichen klinisch-praktischen und kommunikativen Kompetenzen zuk?nftiger ?rzte eignet. Vor allem in Folge der Novellierung der Approbationsordnung f?r ?rzte [3] wird die Durchf?hrung einer klinisch-praktischen Pr?fung zunehmend an Bedeutung gewinnen. Allerdings ist die OSCE-Pr?fung bei den Studentenzahlen deutscher Fakult?ten mit organisatorischen und logistischen Herausforderungen verkn?pft. Das Anliegen der vorliegenden Arbeit war eine zeit- und ressourcenschonende Implementierung an anderen Fakult?ten in Hinblick auf Konzeption, Durchf?hrung und Notenvergabe zu erleichtern.

Die Bestehensgrenze f?r den an der Medizinischen Universit?tsklinik Heidelberg durchgef?hrten OSCE wurde mit einem modifizierten Standard Setting Verfahren nach Angoff [2], [17] festgelegt. Wenngleich dieses zus?tzliche Zeit- und Personalressourcen beansprucht und im Vergleich zur Borderline-Methode [30] einen hypothetischen Zugang zur Festlegung einer Bestehensgrenze pr?feriert [17], bietet sie deutliche Vorteile gegen?ber der Borderline-Methode: So kann der Notwendigkeit der Ank?ndigung der Bestehensgrenze vor Pr?fungsbeginn leichter Rechnung getragen werden und die Bildung von Expertenteams zur Festlegung der Bestehensgrenzen dient dar?ber hinaus der Curriculumsentwicklung und dem Einbezug von Kollegen in verantwortliche Entscheidungsprozesse.

In der Konzeption des OSCE entschieden wir uns f?r ein neues Checklistenformat, welches die Vorteile eines Checklisten-Ratings und eines globalen Ratings integriert, um h?here Kompetenzebenen mit zu erfassen [41] [53] sowie f?r die Durchf?hrung des OSCE in einer kompensatorischen Form. Hiermit sollte vermieden werden, dass schlechter konzipierte Stationen zum Nachteil f?r "kompetente" Studenten werden (vgl. [9], [17]), zumal bisher unklar ist, welcher Zugang der validere ist [37]. Der vorgestellte OSCE beinhaltete sowohl Pr?fungsstationen mit hoher Trennsch?rfe, die gut zwischen "kompetenten" und "nicht-kompetenten" Studenten unterschieden, als auch Stationen, die elementares Grundwissen mit geringerer Trennsch?rfe abpr?ften.

99,3% der Medizinstudenten erreichten die festgelegte Bestehensgrenze unseres OSCE. ?quivalent zu Berichten in der Literatur (vgl. [33]) lagen die erreichten Punktwerte der Pr?flinge im oberen Wertebereich. Eine differenzierte Notenvergabe war problemlos m?glich. Obwohl sich die gesamte Pr?fung ?ber drei Tage hinzog, unterschieden sich die studentischen Pr?fungsleistungen an den unterschiedlichen Pr?fungstagen nicht. Die Erfahrung zeigt, dass eine Informationsweitergabe mit nachfolgenden T?uschungsversuchen eher zu einem schlechteren Abschneiden f?hrt, da die Studenten auf eine Modifikationen der Stationen nicht vorbereitet sind und in dem Versuch zuvor geh?rtes zu reproduzieren nicht mehr so ungezwungen und frei auftreten. Das informelle Feedback von studentischer Seite und von Pr?fern zeigt, dass der OSCE als Pr?fung sowohl den Pr?flingen als auch den Pr?fern Spa? bereitet und auf beiden Seiten Zufriedenheit hinterl?sst. Diese in Fokusgruppen zusammengetragene Resonanz bezieht sich dabei sowohl auf die Art der Pr?fungsform, die Pr?fungsinhalte als auch auf das Feedback w?hrend der Pr?fung selbst.

Aufgrund der hohen Anzahl von zu pr?fenden Studenten war in Hinblick auf die Personalintensit?t des OSCE notwendig, Pr?fer mit einzubeziehen, die noch nicht gen?gend Erfahrung mit dieser Pr?fungsform sammeln konnten. Hilfreich war hier das obligatorische Pr?fertraining direkt vor dem OSCE. Aufgrund der unmittelbaren zeitlichen N?he zur Pr?fung und den direkten Bezug zur zu pr?fenden Station, erwies sich dieses als sehr effizient.

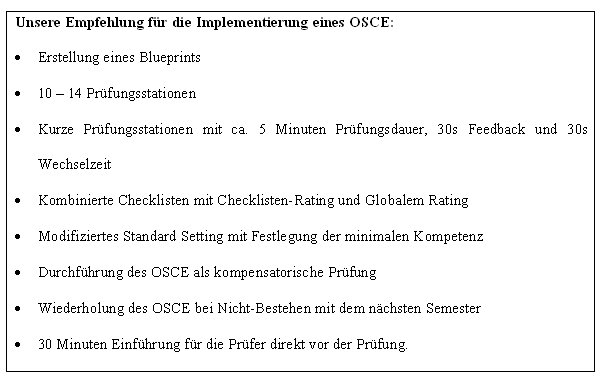

Der vorgestellte OSCE (Abbildung 3 [Abb. 3]) erweist sich als reliables und faires Pr?fungsinstrument, welches wichtige ?rztliche Basisfertigkeiten direkt pr?ft, Medizinstudenten und Pr?fern Spa? bereitet und nicht zuletzt durch das integrierte Feedback einen wichtigen Lerneffekt f?r die Studenten beinhaltet.

Literatur

[1] Allen R, Heard J, Savidge M, Bittergle J, Cantrell M, Huffmaster T. Surveying Students' Attitudes During the OSCE. Adv Health Sci Educ Theory Pract. 1998;3:197-206.[2] Angoff WH. Scales, norms, and equivalent scores. In: Thorndike RL, editor. Educational measurement (2nd ed.), Washington, DC: American Council on Education; 1971; p. 508-600.

[3] Approbationsordnung f?r ?rzte, Beschluss des Bundesrates vom 26.4.2002. Bonn: Bundesanzeiger Verlagsgesellschaft mbH, Drucksache 316/02; 2002.

[4] Barrows HS. An overview of the uses of standardized patients for teaching and evaluating clinical skills. Acad Med. 1993;68(6):443-453.

[5] Boulet JR, de Champlain AF, McKinley DW. Setting defensible performance standards on OSCEs and standardized patient examinations. Med Teach. 2003;25:245-249.

[6] Campos-Outcalt D, Watkins A, Fulginiti J, Kutob R, Gordon P. Correlations of family medicine clerkship evaluations and Objective Structured Clinical Examination scores and residency directors' ratings. Fam Med. 1999;31:90-94.

[7] Cerilli GJ, Merrick HW, Staren ED. Objective Structured Clinical Examination technical skill stations correlate more closely with postgraduate year level than do clinical skill stations. Am Surg. 2001;67:323-326.

[8] Chambers KA, Boulet JR, Gary NE. The management of patient encounter time in a high-stakes assessment using standardized patients. Med Educ. 2000;34:813-817.

[9] Chesser AM, Laing MR, Miedzybrodzka ZH, Brittenden J, Heys SD. Factor analysis can be a useful standard setting tool in a high stakes OSCE assessment. Med Educ. 2004;38:825-831.

[10] Cohen-Schotanus J, van der Vleuten CPM, Bender W. Een betere cesuur bij tentamens: de beste studenten als referentiepunt [A better cutoff for examinations: the best students as a reference point]. In: Ten Cate TJ, Dikkers JH, Houtkoop E, Pollemans MC, Pols J, Smal JA, (Hrsg). Gezond Onderwijs [Health Education], Vol. 5. Houten/ Diegem, The Netherlands: Bohn Stafleu van Loghum. 1996;83-88.

[11] Colliver JA, Willis MS, Robbs RS, Cohen DS, Swartz MH. Assessment of empathy in a standardized-patient examination. Teach Learn Med. 1998;10:8-11.

[12] Cusimano MD, Rothman AI. Consistency of standards and stability of pass/fail decisions with examinee-based standard-setting methods in a small-scale objective structured clinical examination. Acad Med. 2004;79:25-27.

[13] Dauphinee WD, Blackmore DE, Smee SM, Rothman AI, Reznick RK. Using the judgments of physician examiners in setting the standards for a national multi-center high stakes OSCE. Adv Health Sci Educ Theory Pract. 1997;2:201-211.

[14] Davis MH. OSCE: the Dundee experience. Med Teach. 2003;25:255-261.

[15] Dreyfus HL, Dreyfus SE. Mind over Machine. New York: Free Press; 1986.

[16] Ebel RL. Essentials of educational measurement. Englewood Cliffs, NJ: Prentice Hall; 1972.

[17] Friedman Ben-David M. Standard setting in student assessment. AMEE Med. Educ. Guide No. 18. Dundee: AMEE; 2000.

[18] Hamann C, Volkan K, Fishman MB, Silvestri RC, Simon SR, Fletcher SW. How well do second-year student learn physical diagnosis? Observational study of an objective structured clinical examination (OSCE). BMC Med Educ. 2002;2:1.

[19] Harden RMcG, Stevenson M, Wilson Downie W, Wilson GM. Assessment of Clinical Competence using Objective structured Examination. Brit Med J. 1975;1:447-451.

[20] Hodder R, Rivington R, Calcutt LE, Hart IR. The effectiveness of immediate feedback during the OSCE. Med Educ. 1989;23:184-188.

[21] Hodges B, McIlroy JH. Analytic global OSCE ratings are sensitive to level of training. Med Educ. 2003;37:1012-1016.

[22] Hodges B, Regehr G, Hanson M, McNaughton N. Validation of an objective structured clinical examination in psychiatry. Acad Med. 1998;73:910-912.

[23] Hodges B, Regehr G, McNaughton N, Tiberius R, Hanson M. Checklists do not capture increasing levels of expertise. Acad Med. 1999;74:1129-1134.

[24] Jaeger RM. An interactive structures judgement process for establishing standards on competency tests. Theory and application. Educ Eval Policy Anal. 1982;4:461-476.

[25] J?nger J, K?llner V. Integration eines Kommunikationstrainings in die klinische Lehre. Psychother Psychosom Med Psychol. 2003;53:56-64.

[26] J?nger J, Nikendei C. OSCE Pr?fungsvorbereitung Innere Medizin. Stuttgart: Thieme; 2005.

[27] J?nger J, Sch?fer S, Schellberg D, Roth C, Ben-David M, Nikendei C. Effects of Basic Clinical Skills Training on OSCE performance among medical students: a group control design study. Med Educ. 2005;39:1015-1020.

[28] Kaufman DM, Mann KV, Muijtjens AMM, van der Vleuten CPM. A Comparison of Standard-setting Procedures for an OSCE in Undergraduate Medical Education. Acad Med. 2000;75:267-271.

[29] Lieberman ME, Volkan K, Shaffer K, Novelline R, Lang EV. Clinical competence assessment in radiology: introduction of an objective structured clinical examination in the medical school curriculum. Acad Radiol. 2001;8:74-81.

[30] Livingston SA, Zieky MJ. Passing scores: A manual for setting standards of performance on educational and occupational tests. Princeton, New Jersey: Educational Testing Services; 1982.

[31] Mavis B, Cole B, Hoppe R. A survey of student assessment in U.S. medical schools: The balance of breadth versus fidelity. Teach Learn Med. 2001;13:74-79.

[32] McIlroy JH, Hodges B, McNaughton N, Regehr G. The effect of candidates' perceptions of the evaluation method on reliability of checklist and global rating scores in an objective structured clinical examination. Acad Med. 2002;77:725-728.

[33] McLachlan JG, Whiten SG. Marks, scores and grades: scaling and aggregating student assessment outcomes. Med Educ. 2000;34:788-797.

[34] Miller GE. The assessment of clinical skills/competence/performance. Acad Med. 1990;65:63-67.

[35] M?ltner A. Die quantitative Analyse einer Pr?fung. GMS Z Med Ausbild. 2006;23(3): Doc. 52.

[36] Nedelsky L. Absolute grading standards for objective tests. Educ Psychol Meas. 1954;14:13-19.

[37] Newble D. Techniques for measuring clinical competence: objective structured clinical examinations. Med.Educ. 2004;38:199-203.

[38] Nikendei C, Schilling T, Nawroth P, Hensel M, Ho AD, Schwenger V, Ritz E, Herzog W, Schellberg D, Katus HA, Dengler T, Stremmel W, M?ller M, J?nger J. Integriertes Skills-Lab-Konzept f?r die studentische Ausbildung in der Inneren Medizin. Dtsch Med Wochenschr. 2005a;130:1133-1138.

[39] Nikendei C, Zeuch A, Dieckmann P, Roth C, Sch?fer S, V?lkl M, Schellberg D, Herzog W, J?nger J. Role-playing for a More Realistic Technical Skills Training. Med Teach. 2005b;27(2):122-126.

[40] Nikendei C, Zipfel S, Roth C, L?we B, Herzog W, J?nger J. Kommunikations- und Interaktionstraining im Psychosomatischen Praktikum: Einsatz von standardisierten Patienten. Psychother Psychosom Med Psychol. 2003;53(11):440-445.

[41] Norman GR, van der Vleuten CPM, de Graaff E. Pitfalls in the pursuit of objectivity: issues of validity, efficiency and acceptability. Med Educ. 1991;25:119-126.

[42] Regehr G, Freeman R, Hodges B, Russell L. Assessing the generalisability of OSCE measures across content domains. Acad Med. 1999;74:1320-1322.

[43] Regehr G, MacRae H, Reznick R, Szalay D. Comparing the psychometric properties of checklists and global rating scales for assessing performance on an OSCE-format examination. Acad Med. 1998;73:993-997.

[44] Reznick R, Blackmore D, Dauphinee WD, Rothman A, Smee S. Large-scale high- stakes testing with an OSCE. Report from the Medical Council of Canada. Acad Med. 1996;71:19-21.

[45] Reznick R, Regehr G, Yee G, Rothman A, Blackmore D, Dauphinee D. Process rating forms versus task specific checklists in an OSCE for medical licensure. Acad Med. 1998;73:97-99.

[46] Rothman AI, Blackmore D, Dauphinee WD, Reznick R. The use of global ratings in OSCE station scores. Adv Health Sci Educ Theory Pract. 1997;1:215-219.

[47] Schmidt HG, Norman GR, Boshuizen E. A cognitive perspective on medical expertise: theory and implications. Acad Med. 1990;65:611-621.

[48] Searle J. Defining competency - the role of standard setting. Med Educ. 2000;34:363-366.

[49] Simon SR, Volkan K, Hamann C, Duffey C, Fletcher SW. The relationship between second-year medical students' OSCE scores and USMLE Step 1 scores. Med Teach. 2002;24:535-539.

[50] Swanson DB, Norman GR, Linn RL. Performance-based assessment: Lessons learnt from the health professions. Educ Res. 1995;24:5-11.

[51] Swing S, Bashook PG. Toolbox of Assessment Methods. ACGME Outcomes Project. Accreditation Council for Graduate Medical Education (ACGME) & American Board of Medical Specialties (ABMS); Version 1.1; 2000. Zug?nglich unter: http://www.acgme.org/outcome/assess/toolbox.pdf.

[52] Townsend AH, Mcllvenny S, Miller CJ, Dunn EV. The use of an objective structured clinical examination (OSCE) for formative and summative assessment in a general practice clinical attachment and its relationship to final medical school examination performance. Med Educ. 2001;35:841-846.

[53] Van der Vleuten CPM, Norman GR, de Graaff E. Pitfalls in the pursuit of objectivity: issues of reliability. Med Educ. 1991;25:110-118.

[54] Van der Vleuten CPM, Swanson DB. Assessment of clinical skills with standardized patients: state of the art. Teach Learn Med. 1990;2:58-76.

[55] Van der Vleuten CPM. Reliability of OSCEs. University of Maastricht: AMEE conference, 29th August - 1st September 2002. Maastricht: AMEE; 2002. Zug?nglich unter: http:// www.fdg.unimaas.nl/educ/cees/amee.

[56] Van der Vleuten CPM. The assessment of professional competence: Developments, research and practical implications. Adv Health Sci Educ. 1996;1:41-67.

[57] Wass V, van der Vleuten C, Shatzer J, Jones R. Assessment of clinical competence. Lancet. 2001;357:945-949.

[58] Wijnen WHFW. Onder of Boven de Maat [Missing or Hitting the Mark]. PhD dissertation. Groningen, The Netherlands: University of Groningen; 1971.

[59] Wilkinson TJ, Frampton CM, Thompson-Fawcett M, Egan T. Objectivity in objective structured clinical examinations: checklists are no substitute for examiner commitment. Acad Med. 2003;78:219-223.